Hauptlinks

Suchen

Gerüchteküche: Aktuelle Performance-Projektionen sehen nVidias Ampere GA102 und AMDs "Big Navi" grob gleichauf

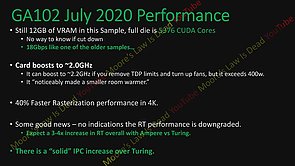

In einem YouTube-Video breiten Moore's Law Is Dead die neueste Gerüchtelage zu nVidias Ampere und AMDs "Big Navi" aus. Die dabei präsentierten Informationen werden nur zum kleineren Teil belegt, stammen aber augenscheinlich zum gehörigen Teil aus bereits bekannten Leaks/Gerüchten, teilweise werden jedoch auch neue Informationen eingeflochten. Man kann es somit als aktuellen Stand der Gerüchteküche verstehen, weniger denn als singulären Leak. Bezüglich nVidias Ampere werden die maximal 84 Shader-Cluster des GA102-Chips bestätigt, zudem soll ein Testsample mit 12 GB Speicher auf 18 Gbps ausgestattet sein und auf realen Boosttaktraten von ~2.0 GHz laufen, wofür aber auch über 300 Watt Stromverbrauch zu Buche stehen. Ohne TDP-Limit geht es dann auf real anliegende ~2.2 GHz hinauf und werden Stromverbrauch-Werte sogar oberhalb von 400 Watt erreicht.

nVidia "Ampere" GA102

voller Chip trägt 5376 Shader-Einheiten

12 GB Speicher auf 18 Gbps (auf diesem Testsample)

Testsample boostet real auf ~2.0 GHz, wobei mehr als 300 Watt Stromverbrauch erreicht werden

realer Boosttakt geht ohne TDP-Limit auf ~2.2 GHz hinauf, dabei werden 400 Watt Stromverbrauch überschritten

40% mehr Rasterization-Performance unter 4K

"solider" IPC-Gewinn gegenüber Turing

RayTracing-Performance soll keinen großen Performance-Verlust mehr produzieren

DLSS 3.0 als weitere Qualitäts-Verbesserung gegenüber DLSS 2.0 (möglicherweise per default aktiviert)

NVCache (nVidias Antwort auf AMDs HBCC)

Tensor Memory Compression (20-40% VRAM-Ersparnis mittels VRAM-Kompression durch Tensor-Kerne)

Launch: September

Quelle: Moore's Law Is Dead @ YouTube am 19. Juli 2020

Der eigentlich spannende Punkt des ganzen ist die Aussage zur "Rasterization-Performance" – womit nicht die Raster-Engines gemeint sind, sondern die reguläre Art der Spielegrafik-Berechnung im prä-RayTracing-Zeitalter. Die dort genannten +40% sind ein erneuter Hinweis darauf, dass eine große reguläre Performance-Verbesserung augenscheinlich nicht die Zielsetzung nVidias bei der Ampere-Generation war. Zwar sind +40% Mehrperformance nicht schlecht, allerdings für den Sprung von der 12nm- auf die 8nm-Fertigung auch nicht wirklich prall. Aber wie gesagt hatte nVidia wohl andere Designziele – und dies läuft ganz augenscheinlich auf die RayTracing-Performance heraus, welche nun nicht (mehr) "downgraded" sein soll. Der Performance-Verlust von RayTracing muß faktisch marginal sein, wenn von einer Steigerung der RayTracing-Performance auf das 3-4fache gesprochen wird. nVidia würde damit durchaus ein beachtbares Argument zugunsten der Ampere-Serie gewinnen, denn bisher war der heftige Performance-Verlust von RayTracing ein Haupthinderungsgrund dieses Grafik-Features.

Aber auch andere genannte Punkte sprechen für eine Zielrichtung hin zu mehr Technik und weniger denn mehr Rohperformance: So wird es NVCache als Antwort auf AMDs HBCC geben – womit vielleicht sogar (teilweise) das System der kommenden NextGen-Konsolen mit ihren schnellen SSDs nachgebildet werden kann. Eine "Tensor Memory Compression" soll die Tensor-Kerne für eine Speicherkompression nutzen, welche immerhin 20-40% Grafikkartenspeicher einsparen soll – was man dann als weiteren Hinweis darauf werten kann, dass die Ampere-Generation in der Mehrheit nicht mehr Grafikkartenspeicher mitbringen wird. Und letztlich soll mit DLSS 3.0 eine weitere Qualitäts-Verbesserung gegenüber DLSS 2.0 erreicht werden – verbunden allerdings mit der Möglichkeit, dass nVidia DLSS 3.0 defaultmäßig aktiviert und auch die Hardwaretester dazu animiert, die Ampere-Grafikkarten in diesem Zustand zu testen. Sollte dies so kommen, wird dies sicherlich größere Diskussionen nach sich ziehen, ob jene Vorgehensweise bzw. solcherart Benchmarks wirklich fair sind.

Auf AMD-Seite sind die Angaben wesentlich kürzer und geht es nur um die groben Chip-Daten sowie eine Performance-Projektion. In beiden Fällen wird damit zudem grob das bestätigt, was erst kürzlich seitens MLID höchstselbst derart genannt wurde: "Big Navi" aka "Navi 21" mit 72 Shader-Clustern für den vollen Chip sowie mit +95-125% Mehrperformance zur Radeon RX 5700 XT. Selbige Performance-Angabe passt gut zum vorherigen Stand von +40-50% auf die GeForce RTX 2080 Ti, denn basierend dem 3DCenter UltraHD Performance-Index ergibt die frühere Performance-Aussage einen 4K-Index von ~330-354%, die neuere Performance-Aussage hingegen ~304-351%. Interessant ist daneben der Launchtermin zu "Big Navi", welcher augenscheinlich bewußt spät erst um die Thanksgiving-Zeit herum (Ende November) stattfinden soll. AMD will hierbei (angeblich) bewußt zusammen mit den NextGen-Konsolen herauskommen, um mittels der gemeinsamen RDNA2-Architektur mediale Synergieeffekte aufzubauen.

AMD "Big Navi"

voller Chip trägt 72 Shader-Cluster

Performance erreicht 195-225% des Niveaus bisheriger AMD-Hardware (Anmerkung: bedeutet +95-125% auf die Radeon RX 5700 XT)

AMD will "Big Navi" zusammen mit PS5 und/oder XBSX herausbringen, um mit der RDNA2-Architektur ein "Zeichen der Stärke" zu setzen

AMD will mit "Big Navi" den Performance-Thron von nVidia erobern

Launch: November (Richtung Thanksgiving)

Quelle: Moore's Law Is Dead @ YouTube am 19. Juli 2020

In der Summe der Dinge ergeben die getroffenen Performance-Aussagen somit ein ziemliches Kopf-an-Kopf-Rennen zwischen AMDs Navi 21 und nVidias GA102 – mit demzufolge nach wie vor Chancen beider Grafikchip-Entwickler, am Ende vorn zu liegen. Zu vermuten ist jedoch, dass wenn nicht gerade eines der beiden Grafikchip-Projekte deutlich unterhalb der Erwartungen herauskommt, letztendlich beide Enthusiasten-Grafikchips sehr eng beieinander herauskommen dürften – zwischen der Maximal-Prognose für Navi 21 und der aktuellen Prognose für den GA102-Chip liegen schließlich gerade einmal 6% Differenz (350% / 330% = 6,1%). Bei diesen engen Abständen würden dann andere Faktoren wichtiger werden, wie Speicherbestückung, Preis, weitere Features und auch natürlich die Treiber-Qualität. Gleichfalls dürfte ein knapper Ausgang oder gar eine geringfügige nVidia-Niederlage jedoch auch die Chance darauf erhöhen, dass nVidia sein DLSS-Feature tatsächlich per default aktiviert – was das Spiel komplett umkrempeln würde.

| AMD | nVidia |

|---|---|

| "Big Navi" (Navi 21) — ~300-350% | Ampere GA102 — ~330% |

| GeForce RTX 2080 Ti-FE — 236% | |

| GeForce RTX 2080 Super — 198% | |

| Radeon VII — 173% | GeForce RTX 2070 Super — 172% |

| Radeon RX 5700 XT — 156% | GeForce RTX 2070-FE — 151% |

| basierend auf dem 3DC 4K Performance-Index sowie den Performance-Projektionen von MLID | |

Letztlich ist aber noch auf eine gewisse Sollbruchstelle dieser Daten hinzuweisen: Wenn nVidias GA102 und AMDs Navi 21 in der Spitze auf eine gleiche oder wenigstens ähnliche Performance kommen sollten, dann hätte AMD auf Basis der vorgenannten Hardware-Daten den Job mit klar weniger Shader-Clustern (72 vs. 84) erledigt – was arg ungewöhnlich erscheint. Die zwei einzigen Möglichkeiten, dies praktisch zu realisieren, sind dann beidesamt nicht besonders wahrscheinlich: Entweder eine höhere IPC, womit AMD dann nVidia bei der IPC plötzlich sogar bemerkbar überholen würde – oder/und mehr Takt, wofür AMD auch nicht gerade bekannt ist. Sicherlich liegen zwischen 72 und 84 Shader-Clustern auch "nur" +17%, ist das ganze nicht gänzlich unmöglich. Aber dennoch wäre es schon etwas überraschend, wenn AMD ein solch großer Wurf gelingen und man mit nur zwei Architektur-Generationen einfach so an nVidia vorbeziehen würde. Besonders wahrscheinlich ist dies nicht – womit die größere Wahrscheinlichkeit darin liegt, das irgendeine der genannten Hardware-Daten oder Performance-Aussagen letztlich doch nicht zutrifft.

Verwandte News

- Neuer Artikel: Mindfactory Grafikkarten Retail-Verkaufsreport Q1/2020

- Gerüchteküche: Gaming-Ampere wieder nur mit ca. +35% Mehrperformance, dafür aber RTX für alle

- Microsoft stellt "DirectX 12 Ultimate" mit vier verpflichtenden "neuen" Grafik-Features vor

- Neuer Artikel: Mindfactory Grafikkarten-Verkaufsreport Januar 2020

- Neuer Artikel: Das Hardware-Jahr 2020 in der Vorschau

- DirectX 12 wird teilweise für Windows 7 nutzbar

- RayTracing wird zukünftig Teil von DirectX 12

- Die Systemanforderungen für die Spiele-Generation 2017/18

- SLI- und CrossFire-Eignung aktueller Spieletitel auf schwachem Niveau

- AMD & nVidia Grafikchip-Roadmap 2017/18