Hauptlinks

Suchen

Grafik-Features

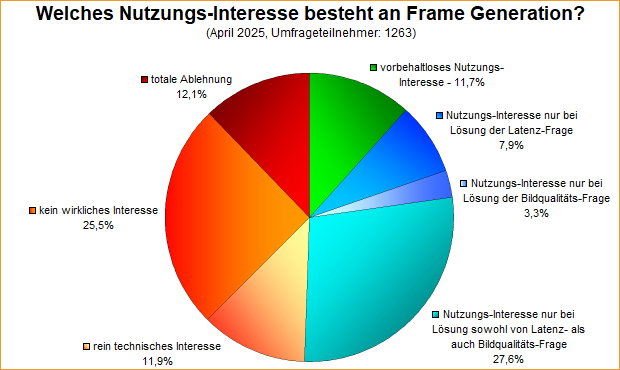

Umfrage-Auswertung: Welches Nutzungs-Interesse besteht an Frame Generation?

Mittels einer Umfrage von diesem April wurde nach dem Nutzungs-Interesse an Frame Generation gefragt, im Zuge der zunehmenden Bedeutung bzw. Anpreisung dieses Features. Die Meinung der Umfrageteilnehmer ist in dieser Frage ziemlich gespalten, gilt es sowohl einige klare Beführworter als auch viele Ablehner – und vor allem wiederum viele, die in der Mitte zwischen diesen beiden Polen stehen. Grundsätzlich kann man hierzu drei Antwortgruppen bilden: Die nicht interessierten Nutzer liegen hierbei mit 49,5% klar in Front. Dahinter kommen diejenigen, welche ein Nutzungsinteresse haben, dies aber an diverse Problemlösungen binden, mit immerhin schon 38,8%. Und letztlich gibt es mit 11,7% noch eine kleinere Gruppe an Umfrageteilnehmer, welche jetzt schon ihr vorbehaltloses Nutzungsinteresse äußern. Für eine vergleichsweise neue Technologie (mit Bindung an neuere Hardware), welche auch jetzt erst vermehrt seitens neuer Spiele unterstützt wird, sind diese Werte nicht einmal übel – da hatte manch andere neue Technologie in der Vergangenheit einen viel schwierigeren Weg zu gehen.

nVidia erteilt DLSS4+MFG auf früherer nVidia-Hardware eine Absage und stellt sich in Zukunft bis zu 16 generierte Frames vor

Die koreanische Quasarzone (maschinelle Übersetzung ins Deutsche) haben auf einem (lokalen) "2025 nVidia RTX AI Day" mit den nVidia-Mitarbeitern Jeff Yen (nVidia APAC Tech Marketing Director), Sean Cleveland (nVidia GeForce Tech Marketing Director) und Seonwook Kim (Technical Marketing Director of nVidia Korea) über verschiedene Dinge bezogen auf die GeForce RTX 50 Serie sprechen können. Hiermit erteilte man Frame Generierung nach DLSS4 auf früheren nVidia-Grafiklösungen eine klare, auch technisch begründete Absage. Gemäß dem konkreten Wortlaut bezieht sich dies nicht nur auf Multi Frame Generation, sondern auch schon auf einfaches Frame Generation (sprich ein generierter pro "echtem" Frame) – was RTX40-Beschleuniger wohl auch weiterhin nur unter DLSS3 ableisten können sollen.

|

nVidia will zukünftig eher bessere Upscaler statt (viel) mehr Rohpower bringen

Die PC Games Hardware weist auf bemerkenswerte nVidia-Aussagen zur zukünftigen Technologie-Ausrichtung hin, welche im Rahmen einer Diskussionsrunde der Digital Foundry @ YouTube gefallen sind. Danach sieht nVidia die Verbesserung der Rohpower nicht mehr als beste Lösung zugunsten einer höheren Grafikqualität an, da "Moore's Law" nicht mehr funktionieren würde. Vielmehr wären laut nVidia verbesserte Upscaler wie DLSS 3.5 ein einfacherer Weg zu höherer Grafikqualität. Dies spielt zum einen auf die mit DLSS 3/3.5 erreichte Grafikqualität an, den Hauptteil liefert hier aber natürlich die Performance-Verbesserung von DLSS, welche die Darstellung dieser Grafikqualität zu spielbaren Frameraten überhaupt erst ermöglicht. Ohne DLSS ist diese Grafikqualität zwar auch schon da, doch die ohne DLSS erreichbaren Frameraten sind oftmals zu niedrig für einen sinnvollen praktischen Einsatz.

If you really internalize the idea that Moore's Law is dead then you fundamentally realize that you have to be more intelligent about the graphics rendering process.

At the same time that traditional ways have just turn the crank to make graphics bigger, they don't work anymore, we have new opportunities to be smarter about how we do graphics and you can look at ray reconstruction as an example.

Quelle: nVidias Bryan Catanzaro in einer Gesprächsrunde der Digital Foundry @ YouTube, veröffentlicht am 19. September 2023

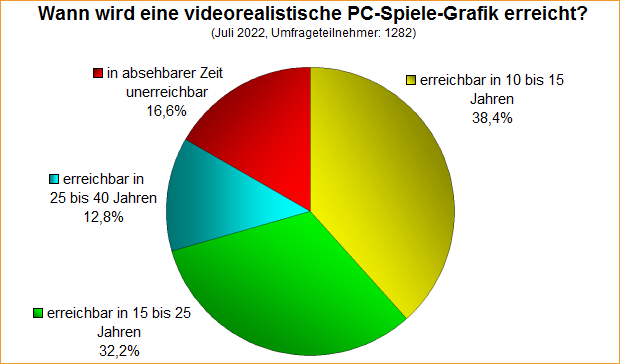

Umfrage-Auswertung: Wann wird eine videorealistische PC-Spiele-Grafik erreicht?

Bei einer Umfrage von Mitte Juli ging es um die Frage, wann eine videorealistische PC-Spiele-Grafik erreicht werden könnte, in Wiederholung einer sinngemäßen Umfrage von anno 2011. Interessanterweise ergeben sich dabei trotz der Zeitdifferenz von über 11 Jahren und trotz dass das Thema der Umfrage eigentlich eine Veränderung über die Zeit nahelegt, nahezu dieselben Ergebnisse – gerade wenn man beide resultierenden Umfrage-Diagramme einfach mal direkt miteinander vergleicht. Im genauen gibt es natürlich Abweichungen: Die beiden Gruppen "10-15 Jahre" sowie "15-25 Jahre" sind jeweils um ein paar Prozentpunkte größer geworden, genauso haben die beiden Gruppen "25-40 Jahre" und "mehr als 40 Jahre" diese paar Prozentpunkte verloren.

Erste Tests geben AMDs temporalem Upscaler "FSR 2.0" gute Wertungen

Von ComputerBase, Hardwareluxx, PC Games Hardware, Digital Trends, Hardware Unboxed, TechPowerUp und Tom's Hardware kommen erste unabhängige Tests und Benchmarks zu AMDs kommenden "FSR 2.0" – der Verbesserung des ursprünglichen AMD-Upscalers "FSR 1.0", welcher nunmehr basierend auf dem Wechsel vom spatialen zum temporalen Ansatz in Konkurrenz mit nVidias DLSS geht. Dabei waren die Testberichte weitaus angetan von AMDs FSR 2.0, die Wertungen reichten von "nahezu DLSS-Niveau" bis hin zu einem faktischen Gleichstand. Ganz genau läßt sich dies sowieso nicht ermitteln, denn beide Upscaler zeigen bei verschiedenen Bildteilen jeweils (leichte) Vor- und Nachteile. Bei AMDs Ansatz entfallen beispielsweise auch echte Grafikfehler durch eine falsche KI-Interpretation, welches bei nVidias Ansatz naturgemäß nicht gänzlich zu verhindern ist.

| AMD RSR | AMD FSR 1.0 | AMD FSR 2.0 | nVidia NIS | nVidia DLSS | |

|---|---|---|---|---|---|

| offiziell unterstützte Grafikkarten | Radeon RX 5000 & 6000 Serien + Ryzen 6000 APUs | Radeon RX 400, 500, Vega, 5000 & 6000 Serien + alle Ryzen APUs + GeForce 10, 16, 20 & 30 Serien | Radeon RX 590, Radeon RX Vega, 5000 & 6000 Serien + nVidia-Karten ab der GeForce GTX 1070 | GeForce 900, 10, 16, 20 & 30 Serien | GeForce 20 & 30 Serien (nicht GeForce 16) |

| inoffiziell unterstützte Grafikkarten | keine | jede DirectX-11-Hardware | derzeit unbekannt | derzeit nicht genau bekannt, aber sehr wahrscheinlich einige | keine |

| Spiel- oder Treiber-Feature | wird rein im AMD-Treiber aktiviert | muß von den Spielen als Option angeboten werden | muß von den Spielen als Option angeboten werden | kann per nVidia-Treiber erzwungen oder von den Spielen als Option angeboten werden | muß von den Spielen als Option angeboten werden |

| technische Ausgestaltung | spatialer Upscaler | spatialer Upscaler | temporaler Upscaler | spatialer Upscaler | ab v1.9: temporaler Upscaler, zusätzlich auf Basis von Deeplearning-Informationen |

| Nachschärfung | regelbar, aber stur für das komplette Bild (inkl. UI) | regelbar, Ausnahmen für UI etc. sind vom Spieleentwickler definierbar | regelbar, Ausnahmen für UI etc. sind vom Spieleentwickler definierbar | regelbar, aber stur für das komplette Bild (inkl. UI) | regelbar, Ausnahmen für UI etc. sind vom Spieleentwickler definierbar |

nVidia bringt mit "nVidia Image Scaling" einen eigenen offenen Upscaler in Konkurrenz zu AMDs FSR

Mit dem neuen GeForce-Treiber 496.76 bietet nVidia nunmehr ein weiteres Upscaling-Feature nach dem eigenen DLSS sowie AMDs FSR an: "nVidia Image Scaling" (NIS). Hierbei kopiert nVidia ein wenig AMDs FSR-Ansatz, denn bei NIS handelt es sich um nichts anderes als die grundsätzlich selbe Lösung mit grünem Anstrich: Ein spatialer Upscaler (sprich Rendering auf intern niedriger Auflösung und dann Hochskalierung auf die Zielauflösung zur Bildausgabe), ohne Verarbeitung von temporärer Komponente oder gar einer KI-Unterstützung. Allerdings peppt nVidia das ganze mittels dem Haus-eigenen Bildschärfungs-Tool "nVidia Image Sharpening" auf, welches bei NIS-Einsatz automatisch mit ins Spiel kommt und der für Upscaler typischen gewissen Weichzeichnung entgegenwirken soll. Da nVidias Schärfungstool bislang für gutklassige Ergebnisse steht und die Nachschärfung bei FSR in der Praxis als suboptimal gilt, wäre nVidias NIS somit AMDs FSR auf dem Papier überlegen – was natürlich besser den Praxisvergleich abzuwarten gilt.

| AMD FSR | nVidia NIS | nVidia DLSS | |

|---|---|---|---|

| offiziell unterstützte Grafikkarten | AMD Radeon RX 400, 500, Vega, 5000 & 6000 Serien + alle AMD Ryzen APUs + nVidia GeForce 10, 16, 20 & 30 Serien | nVidia GeForce 900, 10, 16, 20 & 30 Serien | nVidia GeForce 20 & 30 Serien (nicht GeForce 16) |

| inoffiziell unterstützte Grafikkarten | jede DirectX-11-Hardware | derzeit nicht genau bekannt, aber sehr wahrscheinlich einige | keine anderen |

| Spiel- oder Treiber-Feature | muß von den Spielen als Option angeboten werden | kann per nVidia-Treiber erzwungen oder von den Spielen als Option angeboten werden | muß von den Spielen als Option angeboten werden |

| technische Ausgestaltung | spatialer Upscaler mit Nachschärfung | spatialer Upscaler mit Nachschärfung (letzteres eventuell nur auf offiziell unterstützten nVidia-Karten) | Upscaler auf Basis von Deeplearning-Informationen und zusätzlich temporaler Komponente (ab v1.9) |

| rechtlicher Status | OpenSource | OpenSource | proprietäres nVidia-Feature |

| Release | 22. Juni 2021 | 16. November 2021 | 19. September 2018 (Turing-Launch) |

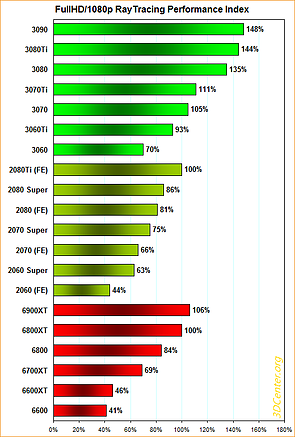

Neuer Artikel: Ein erster Überblick zur RayTracing-Performance

An das Thema der RayTracing-Performance wurde sich lange Zeit eher vorsichtig herangetastet. Zu Zeiten der Turing-Generation gab es generell nur vereinzelne entsprechende Benchmarks, auch derzeit bei den aktuellen Ampere- und RDNA2-Generationen sind die RayTracing-Benchmarks in vielen Hardwaretests immer noch eine Neben-Disziplin. Selbige wird zudem abgetrennt von der hauptsächlichen Performance-Ermittlung unter gewöhnlichen Rasterizer-Benchmarks durchgeführt – wobei sich an dieser Aufteilung in Rasterizer- und RayTracing-Benchmarks prinzipbedingt wohl auch nichts so schnell ändern wird. Allerdings ergeben sich inzwischen ausreichend tiefe Benchmark-Felder unter RayTracing, um den Versuch eines ersten (fehlbaren) Überblicks zur RayTracing-Performance von Turing, Ampere & RDNA2 aufstellen zu können ... zum Artikel.

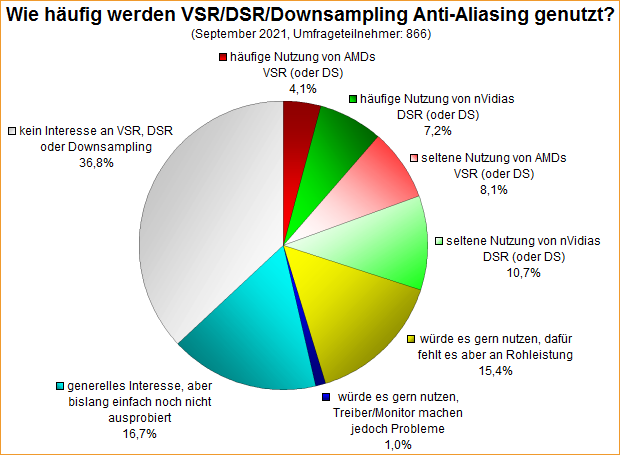

Umfrage-Auswertung: Wie häufig werden VSR/DSR/Downsampling Anti-Aliasing genutzt?

Mit einer Umfrage von Anfang September wurde nach der Nutzung von VSR, DSR und Spiel-eigenem Downsampling Anti-Aliasing gefragt, in Wiederholung einer 2016er Umfrage. Spiel-eigenes Downsampling wurde seinerzeit noch nicht mit abgefragt, aber da es sich sinngemäß um dasselbe wie die beiden Hersteller-eigenen Features VSR & DSR handelt, kann man die Umfrageergebnisse durchaus miteinander vergleichen. Dabei ergibt sich, dass VSR/DSR/Downsampling derzeit an Verbreitung und Beachtung durchaus eingebüßt hat – wenn derzeit nur 30,1% der Umfrageteilnehmer für dessen Nutzung stimmten, anno 2016 hingegen wenigstens 37,3%. Angesichts der immerhin fünf Jahre Zeitspanne zwischen den beiden Umfragen ist dies für VSR/DSR/Downsampling ein schwaches Ergebnis, neue Grafik-Features (mit dieser guten Ausgangslage) können über diesen Zeitraum durchaus eine echte Marktdurchdringung erreichen.

Erste Testberichte zu AMDs "FidelityFX Super Resolution" zeigen Stärken & Schwächen des DLSS-Kontrahenten

Mit dem Radeon-Treiber 21.6.1 hat AMD am 22. Juni seinen DLSS-Kontrahenten "FidelityFX Super Resolution" (FSR) der Allgemeinheit zugänglich gemacht, gleichfalls erschienen eine Reihe von Testberichten hierzu. Dabei sind FSR und DLSS derzeit nur indirekt vergleichbar, da kein Spiel mit gleichzeitiger Unterstützung beider Grafik-Features existiert. Dennoch ist natürlich die mit FSR erzielbare Grafikqualität das große Thema der entsprechenden Testberichte. Jene wird zumeist gelobt und kommt (in den höheren Qualitätsstufen) auch deutlich besser heraus, als die zur FSR-Ankündigung vorliegenden Vergleichsbilder es vermuten lassen haben.

| AMD FSR | nVidia DLSS | |

|---|---|---|

| offiziell unterstützte Grafikkarten | AMD Radeon RX 400, 500, Vega, 5000 & 6000 Serien + alle AMD Ryzen APUs + nVidia GeForce 10, 16, 20 & 30 Serien | nVidia GeForce 20 & 30 Serien (nicht GeForce 16) |

| inoffiziell unterstützte Grafikkarten | jede DirectX-11-Hardware | keine |

| Aktivierungs-Form | Spielentwickler muß es ins Spiel einbauen und dort eine entsprechende Option anbieten | |

| technische Ausgestaltung | Upscaler mit Nachschärfung | Upscaler auf Basis von Deeplearning-Informationen und zusätzlich temporaler Komponente (ab v1.9) |

| rechtlicher Status | OpenSource | proprietäres Feature |

| Release | 22. Juni 2021 | 19. September 2018 (Turing-Launch) |

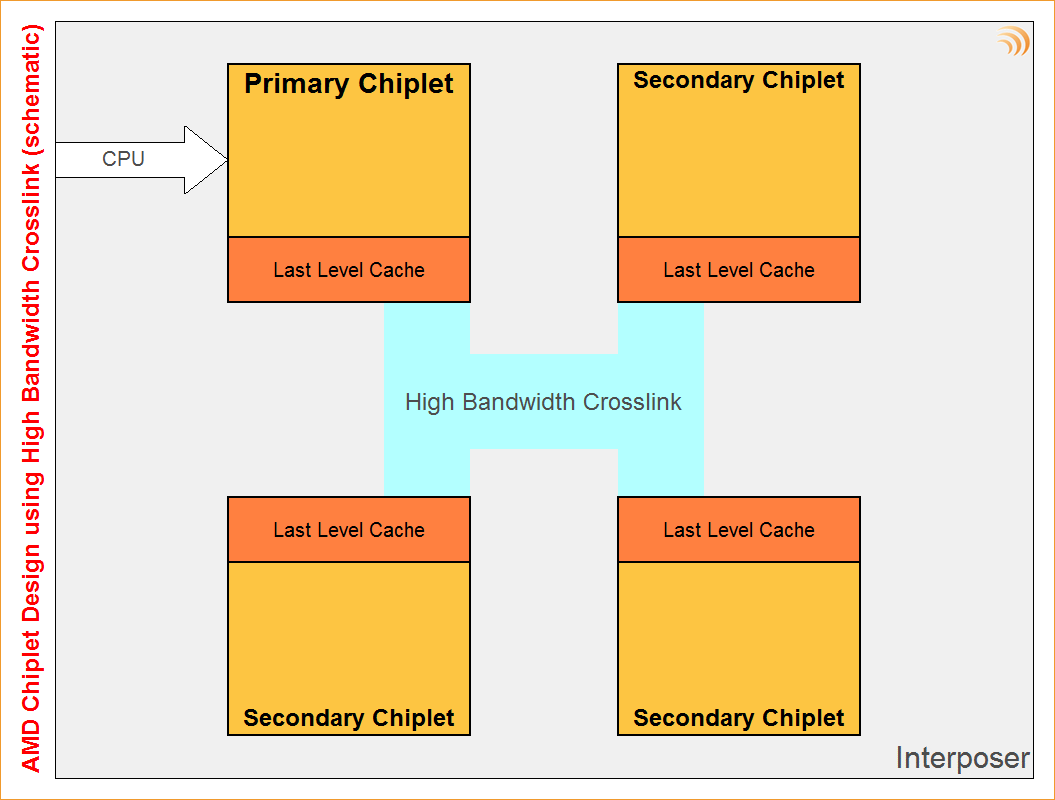

AMD arbeitet am technischen Unterbau von MultiChip-Grafiklösungen

VideoCardz erwähnen ein hochinteressantes, neu eingereichtes AMD-Patent, welches von multiplen GPU-Chiplets spricht – und damit augenscheinlich den technischen Unterbau zu MultiChip-Lösungen im Grafikkarten-Bereich liefern soll. Die Patentschrift selber ist abstrakt genug gehalten, um dies nicht einzelnen Produkten oder Architekturen zuordnen zu können – das ganze ist eher als Grundlagen-Arbeit und kaum als konkretes Chip-Projekt zu verstehen. Dabei hat AMD nicht einfach nur mehrere Chiplets auf ein Blatt Papier gemalt, sondern sich explizit der Frage gewidmet, wie man die Skalierung der Rechenleistung hoch halten bzw. die Datenströme zwischen den Chiplets reglementieren kann. Hierfür verbindet man mittels "High Bandwidth Crosslink" die Level3-Caches aller Chiplets, jene Anbindung wird über AMDs Interposer-Technologie (und damit vergleichsweise stromsparend) realisiert.