Hauptlinks

Suchen

Grafik-Features

AMD streicht den eigenen Treiberpfad für die "Primitive Shaders" von Vega

Aus unserem Forum kommen derzeit eine vielbeachtete Aussage von Marc Sauter von Golem.de, welcher neues über das Vega-Feature der "Primitive Shaders" zu berichten hat. Mittels jener Primitive Shaders soll laut dem Vega-Architektur White Paper (PDF) die Effektivität der Geometrie-Berechnung maßgeblich gesteigert werden – was ein Grund dafür sein dürfte, wieso AMD für den Vega-10-Chip weiterhin (und trotz der hohen Anzahl an Shader-Einheiten) an nur 4 Raster-Engines festgehalten hatte. Die damit verbundenen 4 Geometrie-Engines ergeben nominell einen Output von 4 Primitives per Takt – mittels Primitive Shaders wäre dies jedoch bis auf 17 Primitives per Takt zu steigern gewesen. Ursprünglich wollte AMD hierfür einen extra Treiberpfad anbieten, mittels welchem der Spieleentwickler also entweder den normalen Pipeline-Weg oder aber den "NGG Fast Path" bei Vega-Grafikchips wählen hätte können. Jener extra Treiberpfad hat es bis jetzt aber nicht in die Vega-Treiber geschafft – und wird dies laut einer Planänderung seitens AMD nun auch nicht mehr schaffen:

| AMDs letzte Aussage war, der alternative Treiber-Pfad für Primitive Shaders wurde verworfen, stattdessen halt direkt per API via Entwickler ... was wohl noch keiner (in einem bereits veröffentlichtem Spiel) gemacht hat. Quelle: y33H@ aka Marc Sauter von Golem.de @ 3DCenter-Forum |

Umfrage-Auswertung: G-Sync vs. FreeSync - was ist bereits im Einsatz, was zieht mehr Interesse an (2017)?

Mittels einer Umfrage von Mitte September wurde mal wieder der Stand von "G-Sync vs. FreeSync" abgefragt, gleichlautend zu einer Umfrage vom Januar 2016. Gegenüber dieser hat das Thema der "Sync-Lösungen" einen sehr erfreulichen Zuwachs erfahren: Die Nutzerquote stieg von 12,6% auf nunmehr gleich 31,7% – während die Quote jener Umfrageteilnehmer, welche derzeit und auch in absehbarer Zeit kein G-Sync oder FreeSync benutzen werden, von 43,7% auf nunmehr 33,2% fiel. Zumindest in Enthusiasten-Kreisen gehen G-Sync und FreeSync damit in die Richtung, demnächst vielleicht sogar "normal" bzw. "üblich" zu werden – und es ist schließlich auch kein Grund zu sehen, welcher diesem klaren Aufwärtstrend entgegenspricht.

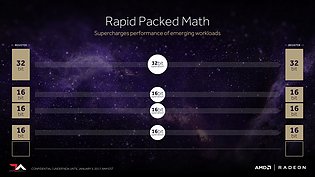

AMDs "Rapid Packed Math" Vega-Feature ermöglicht FP16-Berechnungen mit doppelter Performance

Ein Thread unseres Forums beschäftigt sich mit der Frage, was AMDs Vega-Feature "Rapid Packed Math" genau bedeutet, was es bewirkt, wieviel es bringt und ob andere Grafikbeschleuniger ähnliches aufbieten können. Prinzipell verbirgt sich hinter "Rapid Packed Math" schlicht die Fähigkeit, FP16- und INT16-Berechnung doppelt so schnell ausführen zu können wie die ansonsten üblichen FP32-Berechnungen – sprich in der Zeit einer FP32-Berechnung alternativ auch zwei FP16- oder INT16-Berechnungen erledigen zu können. Eine reine FP16/INT16-Fähigkeit ist dagegen etwas anderes, dies bedeutet nur den grundsätzlichen Support dieser Rechenoperation – ohne aber einen größeren Performancegewinn (anstatt einer FP32-Berechnung kann eine FP16/INT16-Berechnung in exakt derselben Zeit durchgeführt werden). Mittels "Rapid Packed Math" kann man also rein theoretisch doppelt so viele Shader-Operationen durchführen wie gewöhnlich, die nominelle Rechenleistung also glatt verdoppeln. In der Praxis von PC-Spielen kommt es natürlich nirgendwo auch nur annähern zu einer Verdopplung – denn erstens kann FP16/INT16 ohne sichtbare Bildqualitätsverluste immer nur für gewisse Bildteile verwendet werden.

nVidias SLI und AMDs CrossFire sind faktisch Geschichte

Gamers Nexus haben mit AMD über den Umstand gesprochen, das AMD bei der Vega-Vorstellung keinerlei Worte mehr zu "CrossFire" verloren hat – im klaren Gegensatz zur seinerzeitigen Polaris-Vorstellung, als man das ganze sogar noch recht stark betonte. AMD gab auf Nachfrage dann zu, sowohl Marketing-Bemühungen als auch Treiber-Arbeit vom Thema "CrossFire" deutlich weggeschichtet zu haben – platt gesagt läßt man das Thema auf sich beruhen. Der reine Hardware-Support bleibt zwar bestehen, aber man wird daran laut AMD keine Freude haben, wenn der Support seitens der Spieleentwickler und vom Treiberentwickler (AMD) ausbleibt. Im Endeffekt bedeutet dies einen klaren Abgesang auf CrossFire im Spiele-Einsatz, man überläßt das ganze ab sofort schlicht seinem Schicksal. Sicherlich könnte speziell unter DirectX 12 noch etwas passieren, da dort schließlich sowieso die Spieleentwickler den MultiGPU-Support selber übernehmen müssen – aber an dieser Front passiert derzeit in der Praxis leider gar nichts (AotS als Ausnahme, welche die Regel bestätigt), hier könnte also nur noch ein "Wunder" bzw. eine völlig unerwartete Entwicklung etwas ändern.

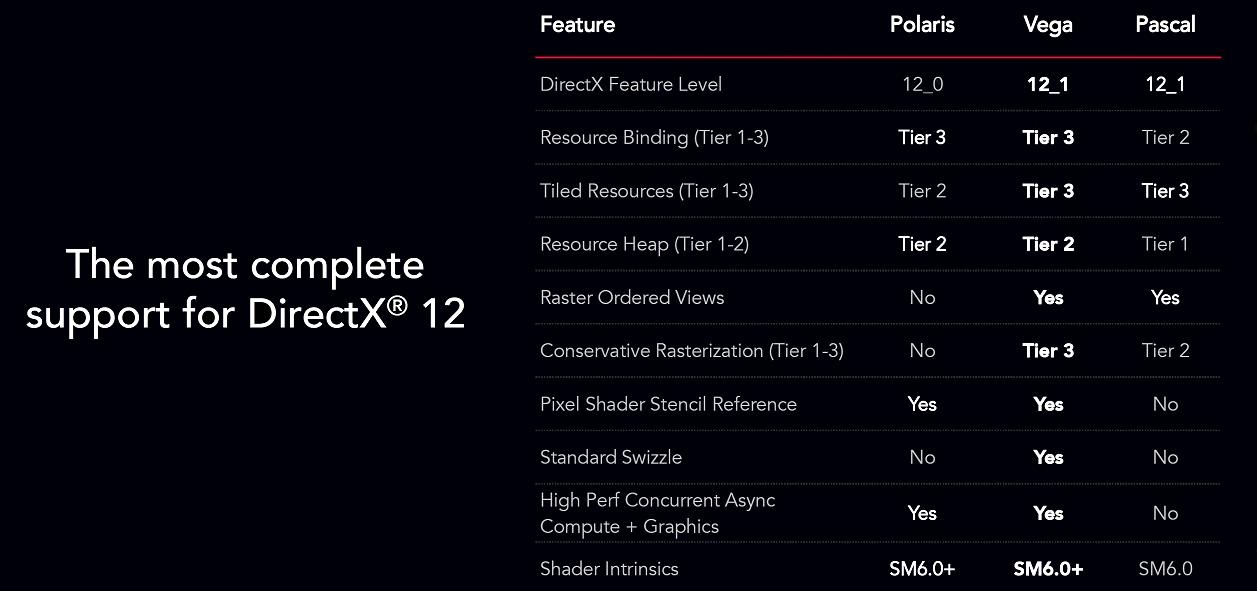

AMDs Polaris & Vega sowie nVidias Pascal unterstützen bereits das Shader Model 6

Im Überblicks-Artikel zur Vega-Architektur bei TechPowerUp befindet sich auch eine Präsentationsfolie zu den von den einzelnen Grafikchip-Architekturen unterstützten DirectX-Features. Neben der Bestätigung des bereits vorab bekannten Punkts, das AMDs Vega-Architektur derzeit den höchsten Feature-Stand unter allen Grafikchip-Architekturen besitzt, respektive den derzeit bestmöglichen Feature-Support für DirectX 12 aufweist, gibt es dabei auch eine Information zum jeweils unterstützen Shader Model von DirectX: Hierbei werden in dieser originalen AMD-Folie für die Grafikchip-Architekturen Polaris, Vega und Pascal jeweils das "Shader Model 6.0" notiert – für die beiden AMD-Architekturen sogar das "Shader Model 6.0+".

SLI- und CrossFire-Eignung aktueller Spieletitel auf schwachem Niveau

Die CPU/GPU-Tests seitens des russischen GameGPU eignen sich neben der primären Funktion der Ermittlung der Grafikkarten-Performance unter neu herausgekommenen Spieletiteln immer auch mit zur Darstellung der MultiChip-Eignung dieser neuen Spiele. Dabei wird durch die Zeitnähe der GameGPU-Artikel zum jeweiligen Spielerelease vor allem ein Urteil über jene MultiChip-Performance gefällt, welche man mit den allerersten optimierten Treibern vorfindet – so, wie es die frühen Spiele-Käufer eben auch wirklich erleben. Im Laufe der Zeit kann sich über weitere neue Treiber und eventuell auch Spielepatches dann durchaus noch einmal ein etwas anderer Stand ergeben – aber dann dürften viele Spieler (gerade bei SinglePlayer-Titeln) das Spiel schon durchgespielt haben, reduziert sich somit die Praxiswirkung von späteren MultiChip-Verbesserungen. Bezüglich den 2017er Spiele-Neuerscheinungen ist das Bild (wie allerdings auch früher schon so) weiterhin arg durchwachsen bis schlecht:

| RX480 CF | Fury X CF | 980 SLI | 1080 SLI | |

|---|---|---|---|---|

| positiver SLI/CrossFire-Effekt | 4 von 21 | 4 von 21 | 7 von 21 | 7 von 21 |

| SLI/CrossFire-Performancegewinn ab +40% | 3 von 21 | 3 von 21 | 5 von 21 | 5 von 21 |

| SLI/CrossFire-Performancegewinn ab +60% | 1 von 21 | 1 von 21 | 4 von 21 | 4 von 21 |

| basierend auf den Spiele-Performanceanalysen seitens GameGPU, Januar bis Juli 2017 | ||||

SLI-Performance der GeForce GTX 1080 Ti wenig überzeugend

Bei Babel Tech Reviews hat man sich eingehend mit der SLI-Performance der GeForce GTX 1080 Ti beschäftigt – und liefert damit gleichzeitig auch gute Daten zum Stand von SLI unter aktuellen Spielen. Von den immerhin 24 getesteten Spielen (Fallout 4 lassen wir aufgrund der Schwierigkeiten der Engine oberhalb von 60 fps mal außen vor) skalierten unter FullHD und WQHD glatt nur die Hälfte überhaupt mit SLI – kein gutes Ergebnis. Nur unter der UltraHD-Auflösung kommen dann noch GTA V sowie Far Cry Primal hinzu – 14 von 24 Spiele-Titel mit Performance-Gewinn sind aber auch dort nicht berauschend, sondern eher denn als ein Argument gegen SLI zu werten. Zugunsten der GeForce GTX 1080 Ti sind wir bei nachfolgender Benchmark-Auswertung immer dann, wenn SLI langsamer war (was unter den nicht skalierenden Spielen durchgehend passiert), von den Benchmarks der einzelnen Grafikkarte ausgegangen – setzen also voraus, daß der Nutzer in diesem Fällen SLI manuell für das jeweilige Spiel deaktiviert.

Welche Beschleunigung erbringen DirectX 12 & Vulkan derzeit gegenüber DirectX 11 & OpenGL?

Die PC Games Hardware hat untersucht, was die LowLevel-APIs DirectX 12 & Vulkan in ihrer Kerndisziplin derzeit leisten können – und dies ist nicht die Beschleunigung der Grafiklösung, sondern natürlich die Entlastung des Prozessors (durch Verringerung des CPU-Overheads), gerade bei weniger leistungsfähigen. Hierzu hat man sich die Performance eines Systems mit FX-8350 samt Radeon R9 Nano unter verschiedenen Benchmarks angesehen, wo sowohl eine der beiden LowLevel-APIs als auch deren "HighLevel"-Vorgänger DirectX 11 & OpenGL angeboten werden. Jener Vergleich ist natürlich nicht perfekt, da manche Spieletitel für unterschiedliche APIs auch (leicht) andere Optikeffekte ansetzen bzw. die APIs von manchen Spieleentwickler nicht gleichwertig behandelt wurden. Ein besonders krasser Fall hierzu ist Doom (2016), wo man mittels der Vulkan-API derart massiv hinzugewinnt (bis zum Dreifachen der Performance), daß dies dann schon eher unrealistische Züge annimmt.

Umfrage-Auswertung: Welche Chance wird MultiChip-Lösungen noch gegeben?

Eine Umfrage von Anfang Dezember ging der Frage nach, welche Chancen MultiChip-Lösungen (im Grafikkarten-Bereich) derzeit noch bekommen. MultiChip-Lösungen waren einstmals zumindest in der Enthusiasten-Gemeinde eine beachtbare Größe, haben zuletzt aber deutlich abgebaut und werden derzeit nur noch selten und teilweise sogar nur zu reinen Benchmark-Zwecken eingesetzt – kein Wunder angesichts des zuletzt regelrecht desaströsen SLI/CrossFire-Supports neuer Spieletitel "out of the box" (sprich mit der initialen Releaseversion). Dem entspricht auch das Ergebnis der Umfrage, welche die Umfrage-Teilnehmer erst einmal in 4,5% aktuelle MultiChip-User, immerhin 18,6% frühere MultiChip-User und satte 76,9% eiserne SingleChip-User unterteilt. Zwar verteilen sich die früheren MultiChip-User sicherlich über viele Grafikchip-Generationen, nichtsdestotrotz liegt die Tendenz nahe, das es früher einen größeren Anteil an aktiven MultiChip-Nutzern gegeben hat – gerade wenn man einrechnet, das diese Umfrage unter Grafikkarten-Enthusiasten stattfand und natürlich weit weg von den Realitäten des Massenmarkts ist.

AMD stellt FreeSync 2 mit verpflichtendem Low Framerate Compensation (LFC) und High Dynamic Range (HDR) vor

Im Vorfeld der CES hat AMD mit "FreeSync 2" eine neue Version seiner vor drei Jahren auf der CES 2014 vorgestellten FreeSync-Technologie vorgestellt. Dabei werden beide FreeSync-Versionen nebeneinander bestehen bleiben, da FreeSync 1 auch weiterhin so etwas wie die Einsteiger-Variante mit möglichst geringen Hardware-Anforderungen darstellt, während man bei FreeSync 2 hingegen klar mehr Technik hineinpackt und daher auch deutlich höhere Hardware-Anforderungen abverlangt. Jene liegen allerdings ausschließlich auch Monitor-Seite – bei den Grafikkarten selber gilt die einfache Regel, das alles, was FreeSync 1 unterstützt, auch FreeSync 2 unterstützen wird (sprich alle AMD-Grafikkarten mit Grafikchips ab der GCN2-Generation).