Hauptlinks

Suchen

nVidia-Grafik

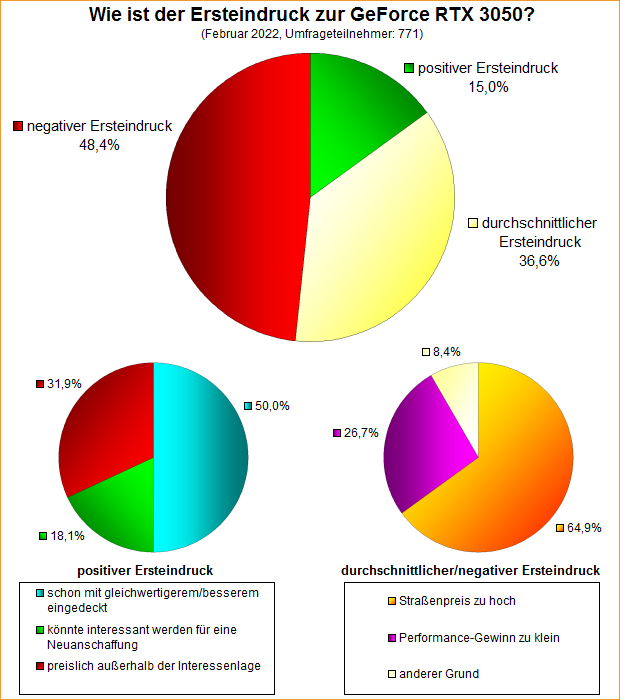

Umfrage-Auswertung: Wie ist der Ersteindruck zu nVidias GeForce RTX 3050?

Für die Ende Januar in den Markt gekommene GeForce RTX 3050 fand Mitte Februar eine Umfrage nach dem Ersteindruck zu eben dieser statt. Gemessen an der Performance-Klasse sowie der zum Launch noch herrschenden (stärkeren) Preisübertreibung für diese Mainstream-Grafikkarte sind keine wirklich guten Umfrage-Ergebnisse zu erwarten, was mit nur 15,0% positiver Ersteindruck zu 36,6% durchschnittlichem Ersteindruck samt 48,4% negativem Ersteindruck auch erfüllt wird. Zumindest schlägt nVidia damit eindeutig die Radeon RX 6500 XT, deren entsprechende Umfrage kurz davor lief – und mit 4,6% positiv, 16,0% durchschnittlich samt 79,4% negativ überaus schlechter ausfiel. Mit einem potentiellen Kaufinteresse von 2,7% (über alle Umfrage-Teilnehmer hinweg) reißt die GeForce RTX 3050 zwar auch in dieser Disziplin keine Bäume aus, doch ist dieser (niedrige) Wert für Mainstream-Karten auch nicht ganz ungewöhnlich.

Neuer Artikel: Launch-Analyse nVidia GeForce RTX 3090 Ti

Zu einem vergleichsweise späten Zeitpunkt innerhalb der "Ampere"-Generation bringt nVidia mit der GeForce RTX 3090 Ti nochmals ein neues Spitzen-Modell – welches auch erstmals den Vollausbau des GA102-Chips ins Gamer-Segment bringt. Die neue Karte ist weniger eine Antwort auf AMDs im Frühjahr zu erwartenden "50er Refresh", da nVidia von diesem eigentlich keine Gefahr zu erwarten hat. Eher handelt es sich um einen gewissen Vorgriff auf die nachfolgende GeForce RTX 40 Serie – mit höheren Stromverbrauchswerten, demzufolge klar aufwendigeren Platinen, denkbarerweise nochmals höheren Listenpreisen. In diese Schiene geht die GeForce RTX 3090 Ti mit einer TDP von 450 Watt sowie Listenpreisen von 1999 Dollar bzw. 2249 Euro bereits jetzt hinein – was dann sicherlich nur noch einem Bruchteil der Grafikkarten-Käufer mundet. Was selbige im Gegenzug an Mehrperformance gemäß der hierzu ausgewerteten Launchreviews zur GeForce RTX 3090 Ti erhalten, soll mit dieser Launch-Analyse dargelegt werden ... zum Artikel.

| RayTracing @ 4K/2160p | 6800XT | 6900XT | 3080-10G | 3080Ti | 3090 | 3090Ti |

|---|---|---|---|---|---|---|

| ComputerBase (10 Tests) | 88,6% | 96,7% | 100% | 120,1% | 127,3% | 134,2% |

| Golem (5 Tests) | - | 82,6% | 100% | 119,8% | - | 137,0% |

| PC Games Hardware (9 Tests) | 66,8% | - | 100% | - | 115,4% | 123,4% |

| TechPowerUp (9 Tests) | 78,7% | 84,2% | 100% | 113,9% | 115,5% | 129,0% |

| werksübertaktete Karten sind in blauer Schrift markiert (angegeben ist jeweils die werksübertaktete Performance) | ||||||

Die aktuellen Grafikkarten-Preisübertreibung aus Sicht realistischer Listenpreise

Die (relative) Nähe der Grafikkarten-Preisübertreibung zum Listenpreis, welche derzeit im Schnitt bei +25% auf den Listenpreis liegt, bringt wiederum das Problem von bei einigen Grafikkarten grundsätzlich überzogenen Listenpreisen ins Licht. Denn schließlich haben AMD & nVidia bereits mit den Frühlings-Releases 2021 (GeForce RTX 3060 & Radeon RX 6700 XT) angefangen, Listenpreise für neu in den Markt kommende Karten hochzuschrauben – mit den Sommer- und Herbst-Releases 2021 wurde dies dann noch deutlicher. Deswegen wurde anfänglich auch die periodisch erstellte Straßenpreis-Preisentwicklung ohne GeForce RTX 3070 Ti & 3080 Ti gezeichnet. Doch langfristig war dies nicht zu halten und daher sind dort inzwischen wieder alle Ampere/RDNA2-Karten erfasst (kleine Ausnahme: GeForce RTX 3080 12GB mangels Listenpreis).

| AMD | 6500XT | 6600 | 6600XT | 6700XT | 6800 | 6800XT | 6900XT |

|---|---|---|---|---|---|---|---|

| US-Listenpreis | $199 | $329 | $379 | $479 | $579 | $649 | $999 |

| aktueller Straßenpreis | ab 218€ | ab 395€ | ab 475€ | ab 689€ | ab 965€ | ab 1039€ | ab 1242€ |

| Preis-Übertreibung vs US-Listenpreis | +1% | +11% | +15% | +32% | +53% | +47% | +14% |

| 3DCenter 4K Performance-Index | - | ~134% | 159% | 221% | 278% | 322% | 348% |

| "realistischer" Listenpreis | $129 | $239 | $299 | $419 | $579 | $649 | $999 |

| Preis-Übertr. vs realistischer Listenpreis | +56% | +52% | +46% | +51% | +53% | +47% | +14% |

| durchschnittliche AMD-Preisübertreibung gegenüber dem (angenommenen) "realistischen" Listenpreis: +46% | |||||||

| gemäß der Straßenpreis-Aufstellung vom 27. März 2022 sowie des seinerzeitigen Dollar/Euro-Wechselkurses | |||||||

Launch der GeForce RTX 3090 Ti: Die Launchreviews gehen online

Mit der GeForce RTX 3090 Ti setzt nVidia vergleichsweise kurz vor Schluß noch einmal einen oben drauf bei der "Ampere"-Architektur: Vollausbau des GA102-Chips und klar höhere Taktraten, nur um aus der bisherigen GeForce RTX 3090 noch einmal ein paar Prozentpunkte herauszukitzeln. Dies geht allerdings auch einher mit einer massiv von 350 auf 450 Watt steigenden Verlustleistung sowie einem neuen Spitzen-Preispunkt für non-Titan-Grafikkarten: 1999 US-Dollar oder 2249 Euro sind es in der nVidia-Liste, was der Grafikkarten-Markt sogar durchaus hergibt. Für ein Spitzenprodukt gab es vergleichsweise wenig Testberichte, in welchen sich derzeit zudem ausschließlich nochmals werksübertaktete Modelle tummeln – was somit gar nicht so einfach gegenüber einer Referenz-mäßigen GeForce RTX 3090 vergleichbar ist. Die Karte fordert sicherlich gleich auf mehreren Ebenen zur Diskussion heraus, die reine Performance-Seite wird mit einer später nachfolgenden Launch-Analyse dann erörtert werden.

| GeForce RTX 3080 Ti | GeForce RTX 3090 | GeForce RTX 3090 Ti | |

|---|---|---|---|

| Grafikchip | GA102-225 | GA102-300 | GA102-350 |

| Technik | 7 Raster-Engines, 80 Shader-Cluster, 10'240 FP32-Einheiten, 112 ROPs, 384 Bit GDDR6X-Interface (Salvage) | 7 Raster-Engines, 82 Shader-Cluster, 10'496 FP32-Einheiten, 112 ROPs, 384 Bit GDDR6X-Interface (Salvage) | 7 Raster-Engines, 84 Shader-Cluster, 10'752 FP32-Einheiten, 112 ROPs, 384 Bit GDDR6X-Interface (Vollausbau) |

| Chiptakt | 1365/1665 MHz | 1400/1700 MHz | 1560/1860 MHz |

| Speicher | 12 GB GDDR6X @ 19 Gbps | 24 GB GDDR6X @ 19,5 Gbps | 24 GB GDDR6X @ 21 Gbps |

| Stromverbrauch | 350W (GCP) | 350W (GCP) | 450W (GCP) |

| Listenpreis | $1199 / 1269€ | $1499 / 1649€ | $1999 / 2249€ |

| Release | 3. Juni 2021 | 24. September 2020 | 29. März 2022 |

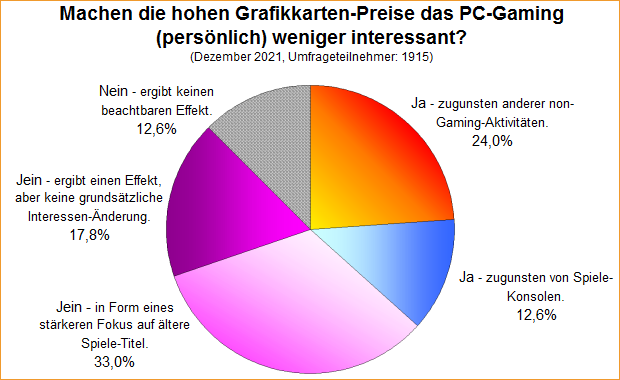

Umfrage-Auswertung: Machen die hohen Grafikkarten-Preise das PC-Gaming persönlich weniger interessant?

Eine noch auszuwertende Umfrage von Ende Dezember 2021 fragte nach einem eventuellen persönlichen Interesse-Rückgang am PC-Gaming in Folge der hohen Grafikkarten-Preise des Jahres 2021. Selbige Umfrage wurde nahezu gleichlautend bereits im Februar 2021 abgehalten – mit teilweise abweichenden und teilweise nahezu identischen Ergebnissen. So ist die Gruppe derjenigen, welche die Fragestellung der Umfrage bejahen (und damit sehr wohl von einer Veränderung der Interessenlage ausgehen), im Dezember 2021 nahezu gleich groß gegenüber dem Februar 2021, selbst die Aufteilung auf die beiden Antwortoptionen dieser Gruppe ist fast gleich. Einschränkenderweise könnte man natürlich annehmen, dass einige, welche sich inzwischen ganz aus dem PC-Gaming zurückgezogen haben, unter Umständen gar nicht mehr bei der neueren Umfrage teilgenommen haben. In dieser Frage muß man durchaus mit einer gewissen Dunkelziffer rechnen.

Die Grafikkarten-Performance unter Elden Ring

Von ComputerBase, GameGPU, PC Games Hardware und TechPowerUp kommen ausführliche Benchmark-Artikel zu "Elden Ring", dem hoch bewerteten und sich derzeit enorm gut verkaufenden OpenWorld-Action-RPG von Entwickler "From Software" und Publisher "Bandai Namco". Das Spiel setzt technisch auf einer Haus-eigenen Engine auf, welche auch schon bei "Dark Souls 3" und "Sekiro: Shadows Die Twice" Verwendung fand, nunmehr allerdings DirectX 12 nebst anderer optischer Verbesserungen bietet – RayTracing soll allerdings erst nachgereicht werden. Das Spiel ist jedoch nicht wirklich als Grafik-Feuerwerk gedacht, womit die Hardware-Anforderungen mittelprächtig sind und beispielsweise die als Minimal-Anforderung genannten GeForce GTX 1060 3GB und Radeon RX 580 4GB selbst auf höchstmöglicher Bildqualität die FullHD-Auflösung noch mit knapp unter 40 fps absolvieren können. Demzufolge kommt unter jener FullHD-Auflösung auch noch jede Menge anderer älterer Hardware ganz anständig mit:

| Elden Ring — FullHD/1080p @ "Maximum" Preset (no RT, no DLSS, no FSR) | ||||||

|---|---|---|---|---|---|---|

| 1080p | Pascal | Polaris+Vega | Turing | RDNA1 | Ampere | RDNA2 |

| 60 fps | 1080Ti → 60 | 2080Ti → 60 2080S → 60 2080 → 60 2070S → 60 2070 → 60 2060S → 60 |

3090 → 60 3080Ti → 60 3080-12G → 60 3080-10G → 60 3070Ti → 60 3070 → 60 3060Ti → 60 3060 → 60 |

6900XT → 60 6800XT → 60 6800 → 60 6700XT → 60 |

||

| 50-59 fps | 1080 → 59 1070Ti → 58 1070 → 54 |

R7 → 57 Vega64 → 56 Vega56 → 51 |

2060-12G → 59 2060-6G → 58 1660Ti → 57 1660S → 56 1660 → 50 |

5700XT → 59 5700 → 57 5600XT-14 → 54 5600XT-12 → 53 |

3050 → 56 | 6600XT → 59 6600 → 59 6500XT → 51 |

| 40-49 fps | 1060-6G → 41 | 590 → 44 580-8G → 40 |

1650S → 44 | 5500XT-8G → 46 5500XT-4G → 44 |

||

| 30-39 fps | 1060-3G → 36 | 480-8G → 38 570 → 35 470 → 33 |

1650-D6 → 35 1650-D5 → 33 |

|||

| ≦29 fps | 1050Ti → 25 | 560 → 20 | ||||

| Durchschnitt der Benchmarks von ComputerBase, GameGPU, PC Games Hardware & TechPowerUp, fehlende Werte interpoliert (±1-2 fps) — "60 fps" = fps-Lock | ||||||

nVidia stellt den "GH100"-Chip der Hopper-Generation mit 18'432 FP32-Einheiten in 144 Shader-Clustern vor

Chipentwickler nVidia hat mit seiner GTC-Keynote die nächste Grafikchip-Generation rund um die 5nm-Fertigung eingeläutet – durch die Vorstellung des "GH100" GPGPU/HPC-Chips auf Basis der "Hopper"-Architektur. Hierbei handelt es sich um den nächsten reinen HPC-Chip von nVidia, sprich in Fortführung des mit der "Pascal"-Architektur begonnenen Wegs reiner HPC-Chips an der Angebots-Spitze: Zuerst GP100 von "Pascal", dann GV100 von "Volta" und GA100 von "Ampere" (trotz gleichen Architektur-Namens deutlich abweichend von den Gaming-Chips dieser Architektur) – und nun eben GH100 von "Hopper". Dabei ist spätetens ab dem GA100-Chip die Zweitverwendung im Gaming-Segment effektiv verbaut, denn GA100 und nun auch GH100 verfügen über keine RayTracing-Einheiten in Hardware – womit entsprechende Gaming-Auskopplungen auf dieser Chip-Basis heutzutage nicht mehr verkaufbar wären.

|

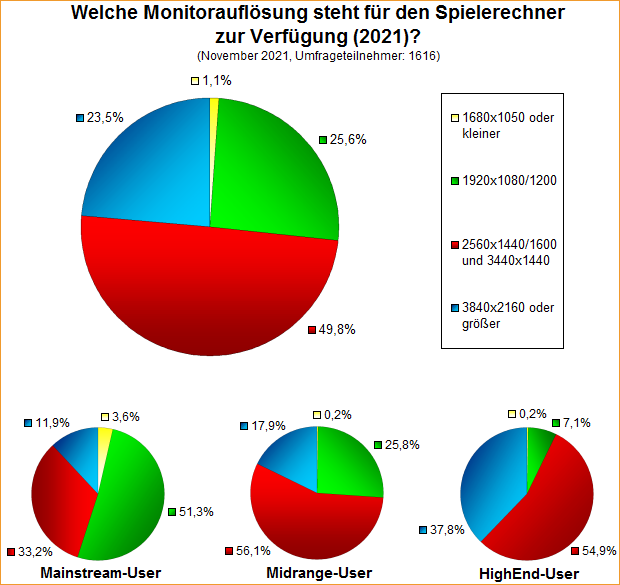

Umfrage-Auswertung: Welche Monitorauflösung steht für den Spielerechner zur Verfügung (2021)?

Bedauerlicherweise liegengeblieben ist letztes Jahr noch eine Umfrage-Auswertung zur Frage der aktuellen Monitorauflösung für den Spielerechner – was hiermit nachträglich erledigt werden soll. Die Umfrage von November 2021 kann dabei auf eine Reihe an gleichlautenden Umfragen von 2008 bis 2019 zurückblicken, aus deren Werten sich somit auch eine gewisse "historische" Entwicklung ableiten läßt. Die Umfrage von letztem Winter sah dabei erstmals die WQHD-Auflösung kurz vor der absoluten Mehrheit über alle Umfrage-Teilnehmer hinweg stehen, während FullHD und UltraHD/4K sich fast paritätisch den Rest teilen und kleinere Auflösungen inzwischen weitgehend verschwunden sind. Logischerweise zeigt sich hier der langjährige Trend zu immer höheren Auflösungen – gleichzeitig aber auch, dass im Rahmen des 3DCenters die Monitor-Auflösungen jederzeit weit über dem allgemeinen Standard liegen, denn in Steam sind nach wie vor über 80% auf FullHD oder kleiner unterwegs.

Neuer Artikel: Chip-Spezifikation zu AMD RDNA3 und nVidia Ada im Vergleich

Die Diskussion über die kommenden 5nm-Grafikchips läuft schon seit letztem Sommer, seinerzeit waren immerhin schon die Spezifikationen der jeweiligen Top-Chips von AMDs RDNA3-Generation und nVidias Ada-Generation (vormals "Lovelace"-Generation) bekannt. In der Zwischenzeit hat sich das Bild hierzu weiter verdichtet und ist nun erstmals mit dem Vorliegen der Chip-Spezifikationen der weiteren Ada-Grafikchips ein vollständiger Vergleich zwischen diesen beiden 5nm-Generationen möglich. Zwar liegt es derzeit noch im Feld der Spekulationen, welche konkreten Grafikkarten AMD & nVidia aus der vorhandenen Hardware ableiten, doch die grundsätzliche Hardware auf Chip-Ebene dürfte feststehen bzw. über das Design-Ende hinaus sein. Damit ist eine grobe Beurteilung dessen, was zu erwarten ist, durchaus schon möglich und soll nachfolgend auf Basis der derzeit vorliegenden Informationen angetreten werden ... zum Artikel.

Gerüchteküche: Korrigierte Hardware-Daten zu nVidias Ada-Lovelace-Generation, inkl. GPC, TPC und L2-Größen

Innerhalb von weniger als einem Tag haben sich neue, korrigierte und sogar deutlich umfangreicher Hardware-Spezifikationen zu den Grafikchips von nVidias Ada-Lovelace-Generation eingefunden. Augenscheinlich basierten die gestern offerierten Daten auf einem früheren Design-Entwurf nVidias, wohingegen die neuen Hardware-Daten Teil des Leaks von nVidia-Dokumenten im Zuge des nVidia-Hacks sind. Im Zuge dessen sprudelten die Informationen nur so: Zuerst hatte La Frite David @ Twitter eine Gegenüberstellung der Shader-Cluster von Turing, Ampere & Ada gepostet, No one @ Twitter ergänzte dies um Angaben zum Speicherinterface sowie Kopite7kimi @ Twitter um Angaben zu GPCs und TPCs der Ada-Chips. Und während Harukaze5719 @ Twitter ein User-erstelltes Block-Diagramm zum AD102-Chip basierend auf diesen Hardware-Daten zeigte, kam von Xino Assassin @ Twitter der Hinweis auf deutlich größere Level2-Caches bei der Ada-Generation und letztlich von HXL @ Twitter eine Aufstellung zu den Cache-Größen der einzelnen Ada-Chips.

| Hardware | FP32 | Interface | L2-Cache | Speicher | Vorgänger | |

|---|---|---|---|---|---|---|

| AD102 | 12 GPC, 72 TPC, 144 SM | 18'432 | 384 Bit | 96 MB | 24 GB | GA102: 7 GPC, 84 SM @ 384 Bit, 6 MB L2 |

| AD103 | 7 GPC, 42 TPC, 84 SM | 10'752 | 256 Bit | 64 MB | 16 GB | GA103: 6 GPC, 60 SM @ 320 Bit, 4 MB L2 |

| AD104 | 5 GPC, 30 TPC, 60 SM | 7680 | 192 Bit | 48 MB | 12 GB | GA104: 6 GPC, 48 SM @ 256 Bit, 4 MB L2 |

| AD106 | 3 GPC, 18 TPC, 36 SM | 4608 | 128 Bit | 32 MB | 8 GB | GA106: 3 GPC, 30 SM @ 192 Bit, 3 MB L2 |

| AD107 | 3 GPC, 12 TPC, 24 SM | 3072 | 128 Bit | 32 MB | 8 GB | GA107: 2 GPC, 20 SM @ 128 Bit, 2 MB L2 |

| Anmerkung: Angaben zu noch nicht vorgestellter Hardware basieren auf Gerüchten & Annahmen | ||||||