Hauptlinks

Suchen

Aktuelle Treiber

- 595.71

- 26.2.2

- 32.0.101.8531

News des 14./15. Februar 2026

Laut VideoCardz könnte der HEDT-light-Ansatz von Intels "Nova Lake" zur Wiederauflage eines älteren Verkaufsnamens führen: Core X – als jene Modelle von Nova Lake, welche mit doppeltem Compute-Die antreten. Diese Prozessoren würde es dann nur innerhalb der Core-9-Serie geben, der komplette Verkaufsname würde auf "Core Ultra X9 400X" lauten – im Gegensatz zum "Core Ultra 9 400K", was die Spitzenmodelle mit nur einem Compute-Die markiert. Die neue Core-X-Serie soll dann generell mit bLLC ausgestattet sein, sprich keine Modelle ohne erweiterten Cache besitzen. Ob hier auch non-K-Modelle mit dieser Technik geplant sind, bleibt offen, denkbar wäre dies durchaus – jene ermöglichen Intel regelmäßig auch weniger gut taktende Chips absetzen zu können, haben also auch für Intel ihren Sinn. Gänzlich sicher sein kann man sich bei dieser vorläufigen Portfolio-Gestaltung natürlich noch überhaupt nicht, denn Intel befindet sich derzeit gerade einmal in der Validierungsphase von Nova Lake und dürfte erst Richtung Jahresmitte dazu schreiten, das eigentliche Verkaufsportfolio auszugestalten.

| Compute-Dies | bLLC | Kerne | |

|---|---|---|---|

| Core Ultra X9 400X | 2 | immer | 42-52 (14+24+4 & 16+32+4) |

| Core Ultra 9 400K | 1 | optional | 28 (8+16+4) |

| Core Ultra 7 400K | 1 | optional | 24 (8+12+4) |

| Core Ultra 5 400K | 1 | niemals | 12-18 (4+4+4, 4+8+4 & 6+8+4) |

| Portfolio der reinen K/X-Modelle von Intels "Nova Lake", gemäß den Ausführungen von VideCardz | |||

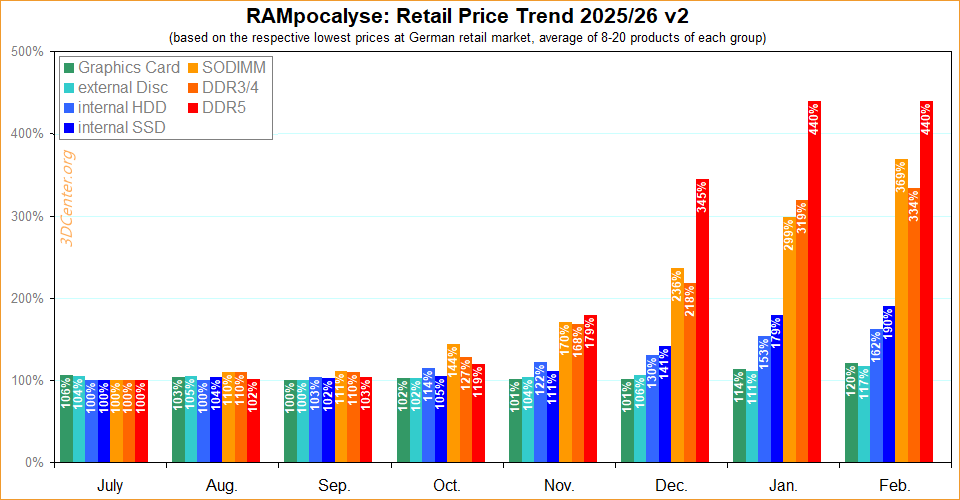

Neuer Artikel: Speicherkrise Preisindex Februar 2026

In Aktualisierung des Speicherkrisen-Preisindex von diesem Januar soll nachfolgend wieder betrachtet wie auch dokumentiert werden, wie sich die Preise von DDR5, DDR3/4, SODIMM, internen SSDs, internen HDDs, externen Festplatten und Grafikkarten im deutschen Einzelhandel über den letzten Monat entwickelt haben. Zielsetzung ist es, zu klaren Zahlenwerten zu kommen, welche die hierbei auftretenden Preisübertreibungen für alle genannten Produktgruppen quantifizieren. Zugleich werden monatliche Steigerungsraten für jede Produktgruppe ermittelt, womit sich Anziehen und Abflauen von Preissteigerungen (sowie hoffentlich eines Tages auch wieder Preissenkungen) belegen lassen. Abschließend wird auf Basis all dieser Daten der gesamte Verlauf der Preisveränderungen aller Produktgruppen noch zusammengefasst in Diagramm-Form dargeboten ... zum Artikel.

Umfrage: Welche Monitorauflösung steht für den Spielerechner zur Verfügung (2026)?

Mittels dieser Umfrage wird eine bereits als Serie existierende frühere Umfrage wiederholt, deren Ergebnisse bis ins Jahr 2008 zurückreichen. Wie üblich gilt hierbei, sich zuerst anhand der benutzten Grafikkarte einem der drei vorgegebenen Performance-Segmente zuzuordnen, um nachfolgend den benutzten Monitor (bzw. die nächstliegende Option) auszuwählen. Bei Ungewißheit über die persönliche Performance-Einordnung kann man sich an den 3DCenter Performance-Index halten. Nutzer von Multimonitor-Setups sollten (nur sofern das Multimonitoring auch im Gaming-Einsatz benutzt wird) die addierte Pixelanzahl ihres Monitor-Setups als Grundlage ansetzen. DualMonitoring unter FullHD ergibt exakt so viele Pixel wie bei WQHD, TripleMonitoring unter FullHD kommt in der Mitte zwischen WQHD und UltraHD heraus und darf daher gern der größeren Option (4K) zugeschlagen werden.

PS: Diskussion zur Umfrage und zum Umfrageergebnis in unserem Forum.

| Mainstream-User | Midrange-User | HighEnd-User | |

|---|---|---|---|

| Radeon RX 5000 Serie (und älter) | alle Karten | – | – |

| Radeon RX 6000 Serie | bis Radeon RX 6750 XT | ab Radeon RX 6800 | ab Radeon RX 6950 XT |

| Radeon RX 7000 Serie | bis Radeon RX 7600 XT | Radeon RX 7700 XT bis 7900 GRE | ab Radeon RX 7900 XT |

| Radeon RX 9000 Serie | bis Radeon RX 9060 | Radeon RX 9060 XT bis 9070 GRE | ab Radeon RX 9070 |

| GeForce 50 Serie | bis GeForce RTX 5060 | GeForce RTX 5060 Ti | ab GeForce RTX 5070 |

| GeForce 40 Serie | bis GeForce RTX 4060 Ti | GeForce RTX 4070 | ab GeForce RTX 4070 Super |

| GeForce 30 Serie | bis GeForce RTX 3070 | GeForce RTX 3070 Ti bis 3080 | ab GeForce RTX 3080 Ti |

| GeForce 20 Serie (und älter) | alle Karten | – | – |

Neuer Artikel: Launch-Analyse AMD Ryzen 7 9850X3D

Mit dem Ryzen 7 9850X3D schickt AMD den ersten Hardware-Launch des Jahres 2026 vor, wobei jener Anfang gemächlich ist – es handelt sich um eine rein taktratenstärkere Ausführung des bekannten Ryzen 7 9800X3D. Letzterer dominiert bekannterweise die Verkaufscharts des DIY-Segments (fast) rund um den Globus, ergo handelt es sich somit wenigstens um ein Update zum klaren Nummer-1-Prozessor der letzten Zeit. Jenes kommt zudem mit vergleichsweise geringem Preisaufschlag von nur +20 Dollar beim Listenpreis daher, wobei die Realität der Straßenpreise dann schon wieder etwas anders aussieht. Wie sich der Ryzen 7 9850X3D im Vergleich zu aktuellen wie älteren X3D-Modellen sowie aktuellen Intel-Spitzenmodellen unter Anwendungs-Performance, Spiele-Performance, Stromverbrauch sowie beim Preis/Leistungs-Verhältnis einordnen kann, soll die nachfolgende Ausarbeitung auf Basis der erschienenen Launchreviews aufzeigen ... zum Artikel.

News des 12./13. Februar 2026

Von Jon Peddie Research kommen eigene Ausarbeitungen zu den Prozessoren-Marktanteilen, welche vor allem auch Angaben zur Stückzahlen-Entwicklung im CPU-Geschäft enthalten. Danach zog im weltweiten Markt das Cient-Segment (Desktop + Mobile) im vierten Quartal 2025 zum direkten Vorquartal zwar um +2,7% an, verlor allerdings gegenüber dem Vorjahreszeitraum recht deutlich mit –7%. Besser lief es hingegen im Server-Segment, wo es quartalsweise um +6,5% nach oben ging und gegenüber dem Vorjahreszeitraum um gleich +13,6% (an anderer Stelle geben JPR hierzu +14,1% an). Letzteres dürfte den Verlust im Consumer-Segment wohl ausgleichen, da Server-Prozessoren schließlich auch noch (viel) höhere Preise auf die Waage bringen. Obwohl die Stimmung im sichtbaren Teil des Marktes also eher gedrückt ist (insbesondere nach den ersten Marktzahlen zum laufenden Jahr), dürfte dies für die CPU-Hersteller eher keine Rolle spielen, da man den Rückgang im Consumer-Geschäft durch den Aufschwung im Server-Geschäft auffangen kann.

| Q4/2025 | Stückzahlen Q/Q | Stückzahlen J/J |

|---|---|---|

| Client-Prozessoren | +2,7% | –7% |

| Server-Prozessoren | +6,5% | +13,6% |

| gemäß der Angaben von Jon Peddie Research zum weltweiten Prozessoren-Markt | ||

Die Marktanteile für x86-Prozessoren im vierten Quartal 2025

WCCF Tech liefern die Marktanteilszahlen für den (weltweiten) x86-Prozessorenmarkt im vierten Quartal 2025, welche ursprünglich immer von Mercury Research erhoben werden. Angegeben werden dabei wie üblich nur die AMD-Werte, aber da es in westlichen Gestaden keine anderen x86-Anbieter mehr gibt bzw. die Marktbedeutung von diversen AMD-Nachbauten in China schwer ermittelbar sowie gering sein dürfte, sollte der "Restwert" immer Intels Marktanteil ergeben. Wegen der Beschränkung auf x86-Prozessoren entfällt hierbei natürlich der Vergleich zu den ARM-basierten Prozessoren von Apple, Qualcomm und zukünftig MediaTek/nVidia. Im abgelaufenen Quartal hat sich AMD bei den Stückzahlen- wie Umsatz-Marktanteilen im x86-Prozessorenmarkt wiederum gut gemacht und Intel an allen Fronten ein paar Prozentpunkte abgenommen. Aber natürlich bewegt sich dieser Markt langsam voran und so sollte man eher schauen, wieviel AMD im Laufe eines ganzen Jahres gutgemacht hat – dies ergibt dann wenigstens beachtbare Veränderungen.

| Absatz (Stück) | Q4/2024 | Q1/2025 | Q2/2025 | Q3/2025 | Q4/2025 |

|---|---|---|---|---|---|

| x86 Desktop | 27,1% vs 72,9% | 28,0% vs 72,0% | 32,2% vs 67,8% | 33,6% vs 66,4% | 36,4% vs 63,6% |

| x86 Mobile | 23,7% vs 76,3% | 22,5% vs 77,5% | 20,6% vs 79,4% | 21,9% vs 78,1% | 26,0% vs 74,0% |

| x86 Client | 24,6% vs 75,4% | 24,1% vs 75,9% | 23,9% vs 76,1% | 25,4% vs 74,6% | 29,2% vs 70,8% |

| x86 Server | 25,1% vs 74,9% | 27,2% vs 72,8% | 27,3% vs 72,7% | 27,8% vs 72,2% | 28,8% vs 71,2% |

| x86 Overall (exkl.) | 24,7% vs 75,3% | 24,4% vs 75,6% | 24,2% vs 75,8% | 25,6% vs 74,4% | 29,2% vs 70,8% |

| x86 Overall (inkl.) | 25,6% vs 74,4% | 27,1% vs 72,9% | 29,4% vs 70,6% | 30,9% vs 69,1% | 31,3% vs 68,7% |

| Stückzahlen-Marktanteile! AMD-Marktanteil in rot, Intel-Marktanteil in blau Quelle aller Zahlen: Mercury Research (±0,1PP) | |||||

News des 11. Februar 2026

Laut HXL @ X beträgt die Chipfläche des kleinen Nova-Lake-Compute-Tiles nunmehr ~110mm² (vorher als 94mm² berichtet), während diejenige des großen Nova-Lake-Compute-Tiles mit dem bLLC ("big Last Level Cache") bei ~150mm² liegen soll. Mit ersterem Wert liegt Nova Lake somit auf Augenhöhe zu Arrow Lake, dort war dasselbe Compute-Tile mit 8P+16E immerhin 117mm² groß. Wirklich dick wird es erst unter Einrechnung aller weiteren Tiles: Bei Arrow Lake belegen die drei weiteren Tiles für GPU, I/O und SoC immerhin 134mm², was (angenommen ähnlicher Größenordnungen bei Nova Lake) folgende Hochrechnungen für den gesamten Prozessor erlaubt: Die 1-Compute-Tile-Modelle mit normalem Cache bei ~240mm², mit vergrößertem Cache bei ~290mm². Die 2-Compute-Tile-Modelle mit normalem Cache bei ~350mm², mit vergrößertem Cache bei ~430mm². Letzteres geht in der Tat dann schon in den Bereich von Server- bzw. HEDT-Prozessoren hinein, womit auch klar ist, dass insbesondere die 2-Compute-Tile-Modelle von Nova Lake keine billige Angelegenheit sein können. Intel nutzt hierbei zudem TSMCs N2-Prozeß sowie teilweise das eigene 18A, dies wird dann auch nicht günstig kommen.

NVL 8+16 Die TSMC N2 ~110+mm2

NVL 8+16 bLLC Die TSMC N2 ~150+mm2

Quelle: HXL @ X am 11. Februar 2026

News des 10. Februar 2026

Bezüglich der hohen Stromverbrauchsangaben zu "Nova Lake" gibt es nun vielerorts ein gewisses Rätselraten, wie jene einzuordnen sind – teilweise in die Richtung hin, ob hiermit vielleicht ein PL4 gemeint sein könnte (extrem kurzfristiger Spitzen-Stromverbrauch, welcher auch beim Core Ultra 9 285K schon auf 425W liegt). Dabei war die gestrige Aussage eigentlich bereits klar genug: Die mehr als 400W sind das reguläre PL2 der Dual-Compute-Die-Spitzenmodelle von Nova Lake (sprich jene mit 52 CPU-Kernen), die mehr als 700W hingegen ein realer Stromverbrauch (kein Limit somit) unter wirklich stromfressenden Workloads in einem komplett ungelockten Zustand (ohne Limits betrieben). Dass diese Auslegung korrekt ist, hat Kopite7kimi @ X nunmehr sogar explizit gegenüber 3DCenter bestätigt. Zugleich hat sich mit Jaykihn @ X eine weitere Quelle hierfür eingefunden, welcher exakt das gleiche berichtet. Mittels dieser zweiten Quelle erhärtet sich im übrigen die gestern schon erwähnte Vermutung, dass der Hintergrund dieser Leaks allesamt interne Intel-Verlautbarungen sein dürften, wahrscheinlich getroffen gegenüber den üblichen Intel-Geschäftspartnern aus der PC- und Mainboard-Branche.

Thank you, this interpretation is completely correct.

I'm afraid the 400W PL2 is just a conservative lower limit.

Quelle: Kopite7kimi @ X am 11. Februar 2026, gegenüber einer Leak-Zusammenfassung von 3DCenter @ X

Well, the preliminary non-extreme, non-baseline, performance PL2 for 52C is 400W+.

This corresponds to an unlocked power draw that reach 700W+ in some workloads, similar to how RPL-S reached 400W+ in some workloads (although rare at unlocked stock).

Quelle: Jaykihn @ X am 10. Februar 2026

News des 9. Februar 2026

Leaker Kopite7kimi @ X weckt die Hardware-Gemeinde aus dem Winterschlaf mit Hinweisen zum Stromverbrauch von Intels "Nova Lake": Der voll ausgefahrene Prozessor mit zwei Compute-Dies und somit 52 CPU-Kernen soll mit abgeschalteten Powerlimits über 700 Watt verbrauchen können – natürlich nicht im Regelbetrieb, sondern nur bei voller Auslastung. Auf diese Werte kann man sicherlich nur im Extrem-Overclocking-Betrieb kommen, aber auch dafür muß es dann entsprechende Mainboards geben. Interessanterweise und sogar wichtiger als das deutet sich nämlich auch ein sehr hoher Spitzenverbrauch unter unübertakteten Bedingungen an. Das PL2, sprich das Powerlimit für kurze Zeiträume (meist 56 Sekunden) soll nämlich bei oberhalb 400 Watt liegen – und dass wäre dann der wirkliche Schocker, immerhin gilt dies für eine nominelle Consumer-CPU. Bei den K-Modellen darf jenes PL2 zumindest bislang auch als dauerhafte Grenze gesetzt werden – ob dies bei Nova Lake noch derart gilt, bleibt allerdings abzuwarten bzw. ist noch nicht bekannt.

The power consumption of a full-load NVL-K is over 700 watts.

Quelle: Kopite7kimi @ X am 10. Februar 2026

Please tell me this is with power limits removed, right?

Quelle: Volta @ X am 10. Februar 2026

Yes, but you can't expect a low PL2.

Quelle: Kopite7kimi @ X am 10. Februar 2026

I can expect 350-400W PL2

Quelle: Game.Keeps.Loading @ X am 10. Februar 2026

totally not enough

Quelle: Kopite7kimi @ X am 10. Februar 2026

News des 7./8. Februar 2026

Overclocking (via VideoCardz) berichten von ernstzunehmenden Hinweise auf eine neue HighEnd-Grafikkarte innerhalb der RTX50-Serie von nVidia für den Sommer 2025 – welche allerdings außerhalb des einstmals geplanten GeForce RTX 50 "SUPER"-Refreshs stehen soll. Das, was einem dazu natürlich einfällt, wäre eine (hypothetische) "GeForce RTX 5090 Ti" oder "Titan Blackwell", dieser Gedanke wurde auch von Overclocking derart genannt. Sicher sein kann man sich diesbezüglich natürlich noch nicht, denn mehr als diese Grundinformation existiert derzeit nicht. Jene soll allerdings laut Overclocking von mehreren ernsthaften Quellen bestätigt und somit vergleichsweise sicher sein. Leider endet diese "Sicherheit" natürlich an der Möglichkeit zur simplen Planänderung, welche nVidia jederzeit innehat – und gerade in jüngerer Vergangenheit doch häufig genutzt hat bzw. wegen der Auswirkungen der Speicherkrise auch nutzen musste.

Eine HighEnd-Grafikkarte der RTX50-Serie befindet sich demnach in Entwicklung und soll sogar zur Back-to-School-Season (Anfang des 3. Quartals dieses Jahres) erscheinen. Der Produktionsprozess (Design und andere Aspekte) hat offenbar bereits begonnen. Die Veröffentlichung dieser Karte soll angeblich nichts mit der „SUPER“-Serie zu tun haben (die nicht mehr im Zeitplan für 2026 enthalten ist).

Quelle: Overclocking am 6. Februar 2026, maschinell übersetzt ins Deutsche