25 Jahre 3DCenter - 25 Jahre IT-Geschichte

Hauptlinks

Suchen

25 Jahre 3DCenter - Seite 2 (2005-2009)

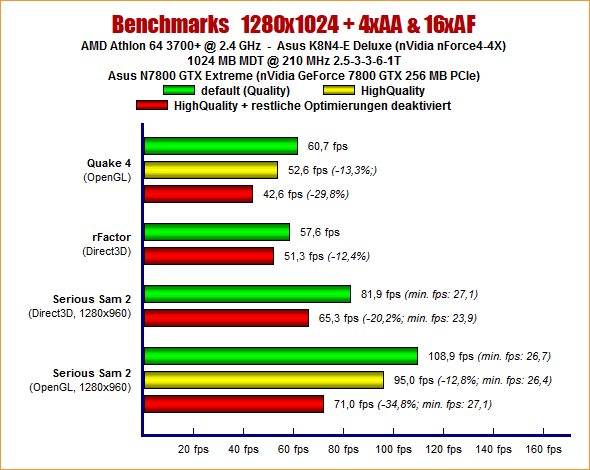

Das Jahr 2005 sah die Launches von GeForce 7800 GTX, GeForce 7800 GT und ATI Radeon X1000. Mehr oder letztmalig wurden mittels S3 DeltaChrome vs. XGI Volari andere Grafikchip-Anbieter als ATI/AMD & nVidia betrachtet, die anderen Anbieter spielten ab diesem Zeitpunkt dann (leider) keine Rolle mehr. ATI brachte hingegen mittels CrossFire einen eigenen SLI-Kontrahenten, beide MultiGrafikkarten-Technologien liefen für mehr als zehn Jahre mit, ehe jene durch neue Rendering-Konzepte nicht mehr durchgehend nutzbar wurden. Als neue "Optimierungs"-Möglichkeit bei der Spiele-Grafik hatte sich nVidia zudem ein Texturenflimmern beim G70-Chip einfallen lassen, welche (mittels einer späteren Treiber-Verbesserung) nur beim nicht default-mäßigen "HighQuality"-Modus entschwand.

Das Jahr 2006 sah zwei langjährig wichtige Hardware-Neuentwicklungen. Zum einen den Launch des Intel Core 2 Duo, womit Intel endgültig AMD wieder auf den zweiten Platz verwies, welche zu dieser Zeit zu lange am K8-Design festgehalten hatten. Bemerkenswert war, wie Intel mit Taktraten von anfänglich nur um die 2 GHz herum den Pentium 4 mit fast 4 GHz ausbootet – dank einer drastisch höheren IPC. Der Core 2 Duo sowie dessen Vierkern-Variante "Core 2 Quad" sollte für einige Jahre verbaut werden, hielt sich im Einsteiger-Bereich als umgelabelter "Pentium" sogar noch über das Jahr 2010 hinaus. Und zum anderen den Release des ersten DirectX10-Grafikchips "G80" im Form der nVidia GeForce 8800 GTS/GTX Grafikkarten. Hiermit begann nVidias zweiter Siegeszug nach der originalen GeForce 256, denn ATI konnte ab diesem Zeitpunkt nVidia oftmals technologisch wie Performance-mäßig nichts gleichwertiges entgegensetzen. Der G80 markierte mit 484mm² Chipfläche zugleich auch den ersten Riesen-Chip von nVidia, vorherige Grafikchips waren zumeist deutlich kleiner.

Ein anderes markantes Ereignis des Jahres 2006 war die Übernahme von ATI durch AMD, welche wie bekannt bis heute Bestand hat. Die Marke "ATI" wurde nachfolgend noch für einige Jahre verwendet, inzwischen ist aber schon lange alles "AMD". Wirklich gebracht hat es AMD durchaus etwas, beispielsweise über die Konsolen-Deals, welche AMDs Bestand in den dürren Zeiten der Bulldozer-Ära gesichert haben. Die ganze großen Fantasien der Synergien zwischen CPU- und GPU-Geschäft haben sich allerdings nie wirklich materialisiert, teilweise mussten sich die beiden AMD-Sparten (geschäftlich) gegenseitig retten, teilweise bremsten sie sich auch aus. Erst in jüngerer Zeit ist AMD endgültig geschäftlich derart solide geworden, dass diese Überlegungen kein Thema mehr sind. Aus heutiger Sicht von Mobile-APUs mit leistungsfähiger iGPU sowie auch der Entwicklung im HPC/AI-Bereich geht es natürlich nicht ohne GPU-Geschäft, langfristig war dies für AMD dann doch die richtige Entscheidung.

Anno 2006 baute ATI zuerst einmal die "Radeon X1000" Serie u.a. mit der Radeon X1900 XT/XTX weiter aus, hatte aber wie gesagt keine (technologisch) neue Antwort auf nVidias G80-Chip. Daneben gab es mittels der BFG Tech Ageia PhysX den Versuch, extra Karten zur Beschleunigung von physikalischen Effekten zu etablieren – was sich jedoch nicht durchsetzte, diese Funktionalität wird inzwischen in Software gelöst. Abseits der Hardware wurde in zwei Artikeln – Teil 2 & Teil 2 die Frage gestellt, ob (die damals zum Benchmarken verwendeten) Timedemos das Maß aller Dinge sein können. Diese Frage wurde in der Moderne über den inzwischen gänzlichen Verzicht auf Timedemos und das Benchmarken mittels Savegame sicherlich eindeutig beantwortet. Und am Ende ging es auch für dieses Jahr nicht ganz ohne neue und alte Filtertricks bei nVidia ab:

Das Jahr 2007 sah zum einen ATIs DirectX10-Konter Radeon HD 2900 XT, welcher jedoch eher den Anfang einer Dürreperiode von ATIs Grafikkarten-Geschäft darstellte. Seinerzeit ging die Marktanteils-Verteilung erstmals auf 35% vs 65% zurück – und sollte nur noch selten besser, jedoch langfristig immer schlechter für ATI/AMD werden. Daran änderten auch die im selben Jahr noch erscheinenden Nachfolger Radeon HD 3850/3870 nichts. Etwas besser kam der AMD K10 (Phenom) weg, womit sich AMD wieder etwas größere Marktanteile gegenüber Intel sichern konnte. Die nachfolgende Entwicklung bei Intel war dann allerdings zu schnell für AMD, welche zuerst ewig an K10 & K11 festhielten und nachfolgend wie bekannt auf das Bulldozer-Fisko zusteuerten.

Noch unter anderen Namen, aber im bekannten Schema wurde im November 2007 der allererste Grafikkarten-Marktüberblick auf 3DCenter aufgelegt. Seinerzeit war das Angebot augenscheinlich überschaubar, seinerzeit waren gerade einmal Modelle von drei Grafikkarten-Generationen gleichzeitig im Markt vertreten: nVidia mit einer voll ausgebauten GeForce 8800 Serie und AMD mit den ersten Modellen der Radeon HD 3000 Serie, welche durch die LowCost- und Einsteiger-Modelle der Radeon HD 2000 Serie ergänzt wurden. Die Preislagen damals: Das teuerste Modell gab es mit der GeForce 8800 Ultra für 540-560 Euro, die günstigsten als Gaming-Grafikkarten durchgehenden Modelle waren GeForce 8500 GT oder Radeon HD 2600 Pro für spottbillige 60-70 Euro.

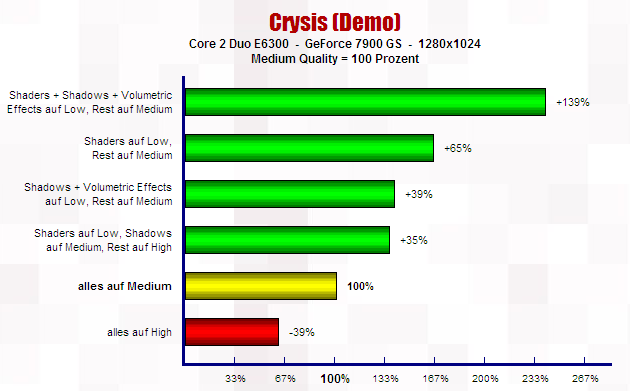

Daneben wurden zudem die Mobile-Beschleuniger beider Grafikchip-Entwickler ernsthaft betrachtet, da seinerzeit erstmals fast so viele Notebooks als Desktop-PCs verkauft wurden (inzwischen beim Verhältnis von ca. 3:1 zugunsten Mobile angelangt). Zudem wurde erstmals das Thema "RayTracing" aufgetan, seinerzeit noch als eher theoretische Zukunfts-Möglichkeit. Wie schwierig jene zu erreichen ist, sieht man heutzutage, wo moderne Grafik RayTracing nur teilweise einsetzt und wir wohl noch einige Quantensprünge davon entfernt sind, halbwegs reine RayTracing-Grafik zu sehen. Und dann war 2007 natürlich auch das Jahr, in welchem Crysis (mit seinen alles sprengenden Hardware-Anforderungen) herauskam, an dieser Stelle begleitet durch einen Crysis (Demo) Tweak-Guide.

Das Jahr 2008 startete mit Refresh-Modellen von nVidia in Form von GeForce 9800 GTX und GeForce 9600 GT, ehe man zur Jahresmitte mittels GeForce GTX 260/280 wieder zu neuen Grafikkarten auf tatsächlich neuen Grafikchips schritt. Seinerzeit sollte allerdings noch auf einige Zeit eine Dual-Generation bei nVidia existieren: Auf den höheren Preispositionen die GeForce 200 Serie, darunter die Refreshs der GeForce 9 Serie (welche technologisch zur GeForce 8 Serie gehörten). ATI konterte mit Radeon HD 4850/4870, welche zwar nicht die Spitzen-Leistungen der GeForce GTX 280 bot, allerdings beim Preis/Leistungs-Verhältnis mit allen darunter befindlichen nVidia-Karten gründlich aufräumte. Hiermit begann eine Zeit, wo die ATI/AMD-Grafikkarten fast konstant die klar besseren Preis/Leistungs-Verhältnisse aufboten – mit einigen Markterfolgen verbunden, aber dennoch ohne den großen Marktumschwung zugunsten von ATI/AMD erzwingen zu können.

Eine gewisse optische Performance-Linderung für ATI ergaben die expliziten DualChip-Grafikkarten Radeon HD 3870 X2 und später Radeon HD 4870 X2 – wenngleich man die nVidia-Modelle natürlich genauso auch zu zweit im SLI-Modus betreiben konnte. Intel hingegen brachte mit dem Nehalem seinen ersten Prozessor der nachfolgend (sehr) langjährigen "Core i" Serie heraus, was wie bekannt erst diese Tage durch ein neues Namensschema bei Intel abgelöst werden wird. Nehalem legte auf den Core 2 noch einmal wirklich viel oben drauf, bot auch wieder HyperThreading (fehlte beim Core 2 noch) und bot auch erstmals Sechskern-Modelle mit dem normalen Portfolio (wurde bei Intel in den Folge-Generationen ins extra HEDT-Segment abgeschoben). Jene Sechskern-Prozessoren von Nehalem hielten sich nachfolgend sehr lange bzw. konnten noch einige Jahre gut mitlaufen, bedingt auch durch exzellente Übertaktungseigenschaften, welche Intel damals auch noch nicht den speziellen K-Modellen vorbehielt (dies geschah mit der nachfolgenden Sandy-Bridge-Generation).

Daneben schnitt nVidia das Thema HybridPower für Mobile-Grafiklösungen an – etwas, was seinerzeit vollkommen neu und heutzutage absolut selbstverständlich ist. Es war zu berichten über den Trend zum Billig-Computer, ausgelöst durch die seinerzeit grassierende EeePC-Manie – eines Mini-Notebooks von Asus zum günstigen Preis, welches nachfolgend eine Flut an "Netbook" genannten Mini-Notebooks mit sich brachte. Und letztlich hatten sich die Grafikkarten-Hersteller nach dem (vorläufigen) Abflauten der "Optimierungs"-Tricks eine neue Scharade ausgedacht: (in den Spezifikationen) beschnittene Grafikkarten – thematisiert und dargestellt in Bericht #1 und Bericht #2. Seinerzeit war dies für die Hersteller einfacher, da Spezifikationen oftmals noch nicht ausreichend exakt wie transparent notiert wurden – eine Handlungsweise, welcher sich erst als Lehre aus dieser Episode ergab.

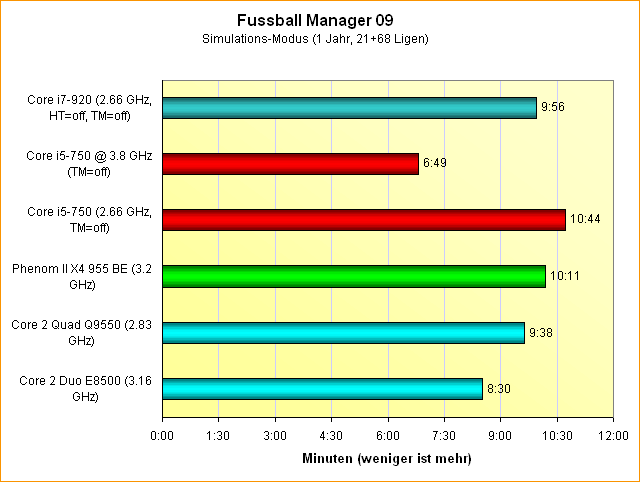

Das Jahr 2009 widmete nVidia einem GeForce-200-Refresh in Form von GeForce GTX 295, GeForce GTX 285 und GeForce GTX 275, während ATI mit Radeon HD 5850/5870 eine richtige neue Grafikkarten-Generation herausbrachte. Hiermit konnte ATI nicht nur nVidias GeForce 200 Serie überrunden, sondern übernahm sogar für kurze Zeit die technologische Führerschaft, da die Radeon HD 5000 Serie die erste DirectX11-Generation darstellte. Zu sehen war dies auch an den Marktanteilen, welche innerhalb dieser Generation letztmals den Sprung über die 40%-Marke für ATI/AMD zeigten. Daneben brachte Intel den ersten Core i5 heraus, womit Nehalem-Technik dann auch für mittlere Preislagen verfügbar und nachfolgend der Core 2 aus dem vielen Marktsegmenten gedrängt wurde. Interessant aus dem seinerzeitigen Review ein CPU-Benchmark, welcher die Simulationszeit im "Fußball Manager 09" ausgemessen hat – eine auch heutzutage leider noch zu selten zu sehende Performance-Kategorie:

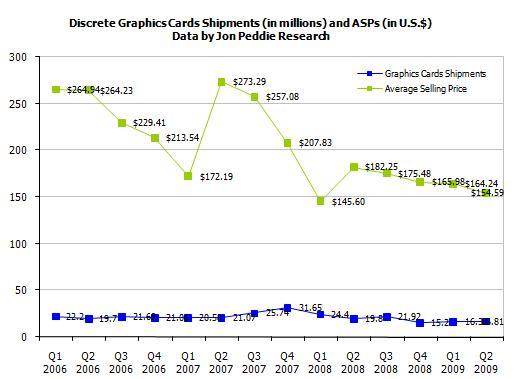

Erstmals breit wurde seinerzeit der hohe Stromdurst von Grafikkarten thematisiert, insbesondere die seinerzeitigen DualChip-Modelle konnten durchaus schon Verbrauchsregionen von fast 300 Watt erreichen. Dies führte nachfolgend zu einem schärferen Blick auf diese Thematik bzw. einer genaueren Protokollierung aller ermittelten Stromverbrauchs-Meßwerte, welche damit bis selbst zur Radeon HD 5000 Serie auch heute noch gut dokumentiert sind (und von dort teilweise bis in die deutsche Wikipedia reichten). Sehr interessant waren auch die Einblicke in die Herstellungspreise aktueller Grafikkarten sowie eine Aufstellung von durchschnittlichen Grafikkarten-Verkaufspreisen aus jener Zeit. Damals war wohl ein Durchschnitts-Preis über den gesamten Markt von 150-250 Dollar normal, zudem wurden pro Quartal auch oftmals mehr als 20 Mio. Grafikchips für Desktop-Grafikkarten abgesetzt. Heuer dürften wir locker beim Doppelten dieses Durchschnittspreises liegen, bei allerdings halbierten Absatzzahlen.