25 Jahre 3DCenter - 25 Jahre IT-Geschichte

Hauptlinks

Suchen

25 Jahre 3DCenter - Seite 4 (2015-2019)

Das Jahr 2015 sah von nVidia den breiten Ausbau der GeForce 900 Serie mit u.a. GeForce GTX 960 und GeForce GTX 980 Ti. Zuerst aber sorgte nVidia für einen Riesenärger mit der GeForce GTX 970, als deren 3,5-GB-Problem zuerst mühsam entdeckt und letztlich von nVidia eingeräumt werden musste. Dies passierte dann ausgerechnet der GeForce GTX 970, welche vorher die beste jemals bewerte Karte bei den Ersteindrucks-Umfragen war (der Zweit-Eindruck war dann nicht mehr so gut). Auch der weitere Jahresverlauf ergab einige Kritikpunkte an nVidia: Zuerst fehlten die Asynchronous Shader bzw. stellten sich als Software-Lösung heraus, dann wollte nVidia die Grafikkarten-Nutzer zu nVidias Glück zwingen und verbundelte "GeForce Experience" mit dem eigenen Grafikkarten-Treiber sowie forderte dafür eine Mail-Registrierung ein. Beides konnte sich natürlich nicht durchsetzen: Asynchronous Shader wurde später zum Standard-Feature neuer Grafikchips, während die Verbundlung von nVidia-Treiber und "GeForce Experience" nach großen Protesten nie durchsetzt wurde.

AMD brachte mittels der Radeon R300 Serie eine neue Refresh-Generation, welche wiederum mit einem wirklich neuen Spitzen-Chip abgerundet wurde: Die Radeon R9 Fury X basierte auf dem Fiji-Chip, welcher erstmals HBM-Speicher ins Consumer-Segment brachte. Dies war zugleich Fluch & Segen, denn unter hohen Auflösungen konnte jene Radeon R9 Fury tatsächlich mit einer GeForce GTX 980 Ti mithalten. Allerdings begrenzte die damalige HBM-Technik den Speicherausbau fest auf 4 GB, was für Spitzenlösungen schon seinerzeit in Kritik stand, sich zumindest nicht als langfristig haltbar erwies. AMD hat den HBM-Speicher nachfolgend noch für seine Vega-Grafikkarten übernommen, danach diese Entwicklungsschiene jedoch nicht weiterbetrieben. Heuer nun wird HBM-Speicher primär für HPC/AI-Beschleuniger verwendet, ist dementsprechend teuer und wird alsbald keinen neuen Versuch im Consumer-Segment geben.

Intel setzte hingegen gleich zwei neue Prozessoren-Generationen an: Broadwell war allerdings nur eine halbe Generation, primär eher für das Mobile-Segment gedacht, wenngleich mittels des extra Level4-Caches gar nicht einmal so uninteressant im Gaming-Einsatz. Skylake war hingegen eine reguläre und dann auch recht erfolgreiche Intel-Generation, deren Architektur prinzipiell bis zum Ende dieses Architektur-Zweigs mit dem 2020er "Comet Lake" weiterverwendet wurde. Daneben übergab AMD seine Arbeit an der Mantle-APU an den OpenGL-Macher "Khronos", welcher daraus die freie Grafik-API "Vulkan" weiterentwickeln sollte – welche auch heute noch ein Kontrahent zu DirectX ist. Zu erwähnen letztlich noch die Radeon R9 Nano, eine sehr spezielle AMD-Grafikkarte auf Fiji-Basis, welche Spitzenleistung in nur 15,3cm Grafikkartenlänge packte:

Das Jahr 2016 sah den Launch der "Pascal" Grafikkarten-Generation von nVidia, u.a. mit GeForce GTX 1080, GeForce GTX 1070 sowie der immens populären GeForce GTX 1060. AMD hingegen gab das HighEnd-Segment für eine gewisse Zeit auf und konzentrierte sich mit der Radeon RX 480 auf Mittelklasse-Beschleuniger, welche ebenfalls eine hohe Popularität erreichten und zugleich inklusive deren Refreshs vergleichsweise lange verkauft wurden (rein praktisch gab es noch im zweiten Quartal 2024 einzelne Verkäufe der Radeon RX 580 bei der Mindfactory). Die Vergleichspaarung "GeForce GTX 1060 vs Radeon RX 480" bestimmte für einige Jahre hinweg den Diskurs zu den beiden Grafikchip-Entwicklern, wobei sich früh andeutet, dass das AMD-Modell die größeren Reserven hat und somit unter neueren Spielen immer besser laufen würde. Seinerzeit lag das nVidia-Modell leicht vorn, aber im Laufe der Zeit hat sich dies verschoben und heutzutage ergibt sich vielleicht eher ein Gleichstand zwischen beiden Karten. Aber auch beim bei früheren AMD-Grafikkarten konnte der Effekt nachgewiesen, dass jene mit der Zeit leicht stärker wurden gegenüber ihren nVidia-Pendants.

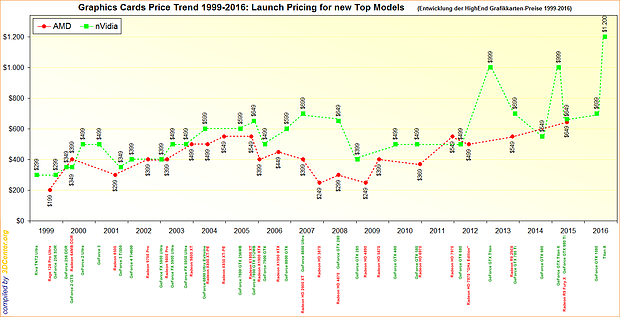

Intel hingegen verabschiedete sich offiziell vom Tick-Tock-Schema, mittels welchem man zuvor jahrelang gut gefahren war, was aber auch nicht mehr in die Zeit passte und heutzutage wohl gar nicht mehr durchzuhalten wäre. Gleichfalls brachte Intel mittels Broadwell-E eine HEDT-Generation mit einigem Erfolg heraus, vorher waren die extra E-Modelle von Intel kaum wirklich beachtet worden. Allerdings deutete sich mit der offiziellen Zen-Präsentation bereits AMDs Morgendämmerung am Horizont an. Asus & MSI wurden hingegen bei Benchmark-Schummelei erwischt, welche jahrelang Pressesamples mit modifiziertem BIOS an die Hardwaretester herausgegeben hatten und sich somit den einen oder anderen Prozentpunkt Performance zusätzlich ergaunerten. Und letztlich lohnt der Blick zu einer Aufstellung über historische Launch-Preise von Grafikkarten in den Jahren 1999 bis 2016 – und damit noch vor dem völligen Durchdrehen der Grafikkarten-Preise in den nachfolgenden Jahren:

Das Jahr 2017 sah Grafikkarten-seitig von nVidia das Pascal-Spitzenmodell GeForce GTX 1080 Ti mit erstmals (und auch heute noch gutklassigen) 11 GB Grafikkartenspeicher, sowie von AMD die Refresh-Modelle Radeon RX 570 & 580 samt den neuen Modellen der Radeon RX Vega Generation. Jene hatten allerdings einen suboptimalen Start durch fehlende Performance und fehlende Features (Tile-based Rasterizer, weitere fehlende Features), welche teilweise sogar nie mehr von AMD nachgereicht wurden. Prozessoren-seitig kamen von Intel mit dem Core X eine neue HEDT-Generation sowie natürlich Coffee Lake, welche schon als Reaktion auf AMDs Ryzen-Prozessoren erstmals seit Nehalem bis zu sechs CPU-Kerne im Consumer-Segment bei Intel boten.

Denn natürlich war 2017 ansonsten das Jahr von Ryzen, erst in Form des Ryzen 7, gefolgt vom Ryzen 5 und später im Jahr der HEDT-Auskopplung Ryzen Threadripper. AMD konnte dabei nicht einmal in jeder Disziplin mit Intel mithalten, relevant für den (sich vor allem langfristig einstellenden) Erfolg waren vor allem zwei Dinge: Erstens der von AMD erzielte überdimensionalen Performancegewinn gegenüber der Bulldozer-Architektur, womit man Intel im groben einholen konnte – und zweitens das Aufbrechen des ewigen gleichen Vierkern-Angebots-Portfolios bei Intel durch leistungsfähige Sechs- und Achtkern-Modelle zu vernünftigen Preislagen. Das seinerzeitige Launch-Review zu Ryzen 7 war auch eines der ersten mit den bekannten größeren Benchmark-Auswertungen samt Index-Erstellung. Für AMD die Sahne auf der Kirsche war jedoch sicherlich die Performance-Überraschung "Threadripper" – ein Projekt mit ungewöhnlicher Entstehungsgeschichte – was seinerzeit sogar nVidia zu einem Glückwunsch an AMD veranlasste:

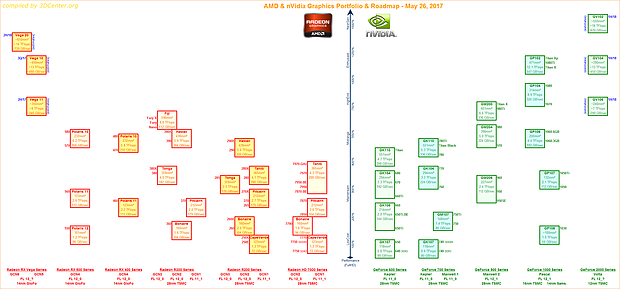

Intel hingegen ging den anderen Weg und schoß scharf gegenüber AMDs Server-Variante Epyc – was im Rückblick natürlich nichts gebracht hat. Erstmals thematisiert wurde das Problem von sich automatisch übertaktenden Intel-Mainboards – was erst jetzt mittels der Stabilitäts-Probleme von Raptor Lake in dieser Form gelöst werden konnte, dass Intel nun endlich ein Machtwort gesprochen hat. Ebenfalls angesprochen wurde der Performance-Abschlag von Mobile-Prozessoren unter Dauerlast, was sich durch die immer stärker genutzten Boost-Modi samt mehreren Powerlimits ergab. Daneben konnte nur noch eine schwache praktische Unterstützung von SLI & CrossFire seitens der damaligen Spiele-Landschaft ermittelt werden, was wenig später das klare Urteil nach sich zog, dass nVidias SLI und AMDs CrossFire faktisch Geschichte sind. Erwähnenswert zudem eine weitere eigenerstellte Grafikchip- & Grafikkarten-Roadmaps jener Zeit, welche eine (wenig akkurate) Vorschau auf Vega- und Volta-Generationen wagte:

Das Jahr 2018 sah zuerst AMDs Ryzen 2000 und Ryzen Threadripper 2000 sowie nachfolgend Intels Coffee Lake Refresh – eigentlich allesamt Refresh-Generationen, aber dennoch recht erfolgreich. Grafikkarten-seitig startete nVidia die Turing-Generation mittels GeForce RTX 2080 & 2080 Ti sowie GeForce RTX 2070. Jene beinhaltete erstmals auch unterschiedliche Spezifikationen für nVidias eigene Modelle sowie die Hersteller-Modelle, was sogar zu extra Werten im Performance-Index für Grafikkarten führte – ein System, was nVidia nachfolgend (glücklicherweise) bei keiner weiteren Grafikkarten-Generation mehr benutzte. Mit dabei bei "Turing" waren zwei Innovationen, welche mit nachfolgenden Grafikkarten-Generationen immer bedeutsamer werden sollten: Das seinerzeit eher beachtete RayTracing sowie das seinerzeit nicht ausreichend gewürdigte DLSS, welches seinen großen Durchbruch allerdings auch erst mit dem späteren DLSS2 (2020) haben sollte.

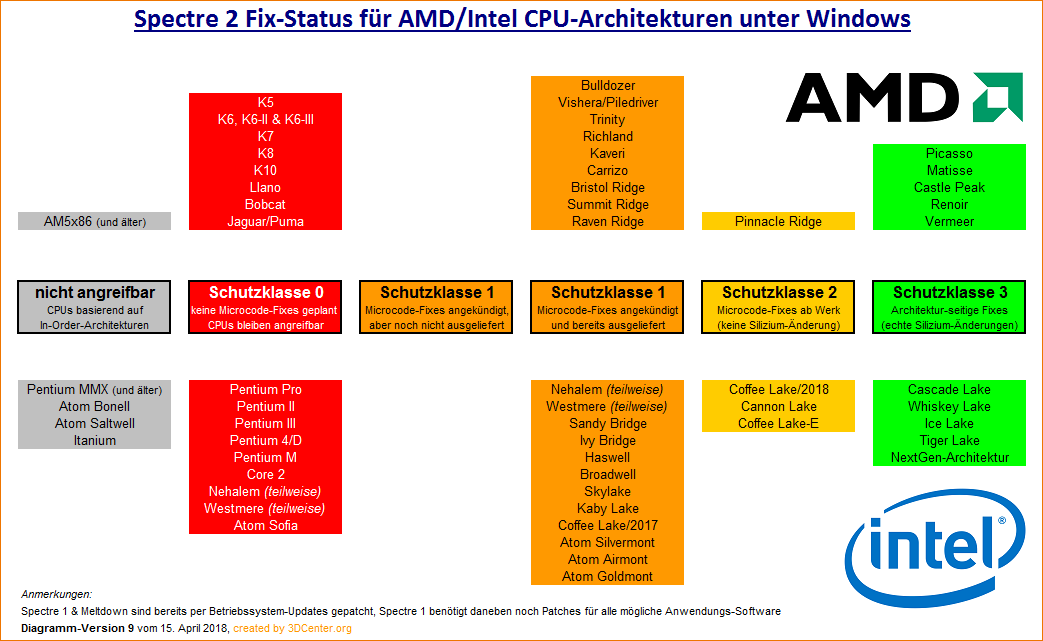

Den trommelwirbelnden Jahrestart gab hingegen kein direktes Hardware-Ereignis, sondern die Sicherheitslücken "Meltdown & Spectre", welche bei allen CPU-Herstellern zu hektischer Betriebsamkeit führten. In der Folge wurde gepatcht und neue CPU-Generationen vorsorglich mit Fixes versorgt, alles auch unter dem Blickpunkt des eventuellen Performance-Verlusts. Aus heutiger Sicht war die Aufregung zumindest aus Endanwender-Sicht vielleicht ein wenig übertrieben, denn in der Praxis führt niemand an Endanwendern komplizierte Seitenkanal-Angriffe durch, dies ist eher nur für Computer in Unternehmen, Behörden und bei Server-Hostern relevant. Allerdings rückte mittels Meltdown & Spectre die Anfälligkeit der reinen Hardware für Cyber-Attacken ins Blickfeld, was bis zu diesem Zeitpunkt eher als reines Thema der Software gesehen wurde. Insofern ist dies dann doch ein markantes Datum, gerade im Zuge der jüngeren Entwicklung, wieder verstärkt auf Sicherheits-Aspekte bei der Software- und Hardware-Entwicklung zu achten.

Daneben war 2018 sicherlich das Jahr der nVidia-"Vorfälle": Zum einen drängte das "GeForce Partner Program" (GPP) die Grafikkarten-Hersteller zur nVidia-Exklusivität, in der Folge dessen labelten Asus und MSI sogar ihre AMD-Grafikkarten (kurzzeitig) um. Nach zu viel Druck beendete nVidia das GPP zwar schon zwei Monate später, der schale Eindruck des Versuchs der totalen Marktbeherrschung blieb allerdings. Und zum anderen legte man nur wenig später eine neue nVidia-NDA auf, welche an Teststellungen von Referenz-Exemplaren interessierte Redaktionen unterzeichnen mussten und welche nVidia weitgehende Rechte einräumte. Ob jene Bedingungen zu weit gehen, ist immer noch nicht entschieden, allerdings ist jene neue nVidia-NDA wohl auch heute noch gültig bzw. verpflichtend.

Ein anderer Schocker des Jahre war sicherlich die Aufgabe der 7nm-Fertigung bei GlobalFoundries und damit der Rückzug des einstmaligen AMD-Stammfertigers aus dem Kreis der technologisch führenden Halbleiterhersteller. Danach sind es mit Intel, Samsung und TSMC letztlich nur noch drei Anbieter, welcher mit führender Technologie arbeiten, die anderen sind teilweise um mehrere Generationen zurück und damit für leistungsfähige PC-Chips keine Überlegung wert. Seinerzeit sah diese Entwicklungs-Einstellung nach großen Problemen für AMD aus, in der Praxis hat sich dies dann durch den Wechsel zu TSMC eher als Glück für AMD erwiesen, da TSMC nachfolgend technologisch davonzugaloppieren begann. Gleichfalls war dieses Jahr erstmals ein Thema die enormen Kostensteigerungen neuer Halbleiterverfahren, seinerzeit am Beispiel der 7nm-Fertigung demonstriert und in den nachfolgenden Jahre dann zum Dauerthema und auch Auslöser einiger Preissteigerungen bei PC-Produkten werdend.

Das Jahr 2019 sah den Launch von nVidias ersten "Super"-Grafikkarten in Form von GeForce RTX 2060 Super & 2070 Super sowie GeForce RTX 2080 Super, während AMD recht erfolgreich rein im Midrange-Segment mittels Radeon RX 5700 & 5700 XT kontert. Intel läßt selbiges Jahr weitgehend aus, während AMD mit Ryzen 3000 die Zen-Prozessoren zum nächsten zum großen Erfolg führt. Jener Launch lief allerdings nicht ganz störungsfrei ab, anfänglich hatte AMD mit nicht ganz erreichten Boost-Taktraten zu kämpfen. Dennoch kann Intel den AMD-Erfolg nicht auf sich sitzen lassen und wettert primär gegen die Benchmark-Methotik der Hardware-Tester: Zuerst fordert man mehr realitätsnahe CPU-Benchmarks, was in erster Linie auf den von Intel favoritisierten SYSMark hinauslaufen soll, danach zweifelt man die realen Benchmark-Ergebnisse zwischen Ryzen 9 3900X sowie Core i7-9700K & i9-9900K an – was jedoch genauso wenig aufgeht. Am Ende kann auch der CPU-Entwickler nicht darüber entscheiden, wie die Hardwaretester gerne testen, selbst wenn manches von Intel gesagtes zumindest in der Theorie nicht falsch ist.

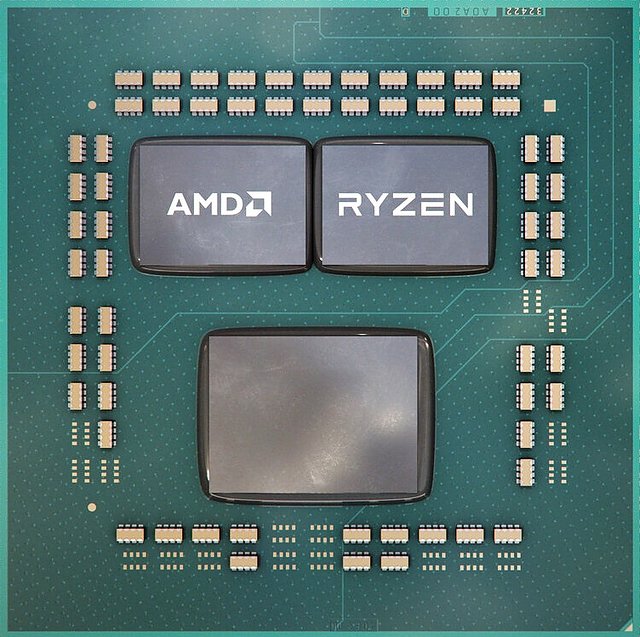

Daneben brachte Intel aber auch richtige Innovationen, welche den CPU-Entwickler (in modernerer Form) noch lange begleiten werden: Denn mittels "Lakefield" wurde ein Prozessoren-Design vorgestellt, welches erstmals kleine und große CPU-Kerne im selben Prozessor kombiniert, der aus dem Mobile-Bereich bekannte "big.LITTLE"-Ansatz. Zugleich basierte Lakefield aber auch auf Intels "Foveros" Packaging, welches mit verschiedenen Chips auf demselben Package und zugleich auch gestappelt umgehen kann. Jener Ansatz wird für die Zukunft genauso bedeutsam sein, in neuerer Zeit wendet sich Intel wie bekannt verstärkt Prozessoren mit mehreren Kern-Arten und unterteilt in einzelne Chiplets ("Tiles") zu, was dann eben nur mittels besserem Packaging zusammenzubringen ist. Selbst AMDs Ryzen 3000 geht einen ersten Schritt in diese Richtung durch die Aufteilung des Prozessors in 1-2 Prozessoren-Dies samt einem extra I/O-Die (was seinerzeit aufgrund des großen Erfolgs auch weit mehr als "Lakefield" mehr beachtet wird).