25 Jahre 3DCenter - 25 Jahre IT-Geschichte

Hauptlinks

Suchen

25 Jahre 3DCenter - Seite 3 (2010-2014)

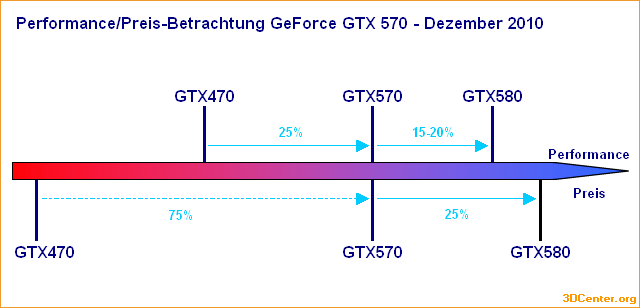

Das Jahr 2010 sah eine breite Aktivität an der Launch-Front, zu nennen die Ausweitung von ATIs Radeon HD 5000 Serie über alle Marktsegmente, den Konter von nVidia mittels GeForce GTX 470 & 480, welche allerdings noch innerhalb desselben Jahres vom Fermi-Refresh GeForce GTX 580 abgelöst wurde und letztlich AMDs neue Grafikkarten-Generation in Form von Radeon HD 6950 & 6970. Innerhalb dieses Jahres gab AMD damit auch den Markennamen "ATI" endgültig auf und alles firmierte künftig nur noch unter "AMD". Bemerkbar aus den Launch-Reports jener Zeit sind die Ansätze einer ersten Benchmark-Auswertung, welche bereits zu ersten Performance-Indizierungen führte – und daneben auch zu dieserart Performance/Preis-Diagrammen:

Erneut waren beschnittene Grafikkarten ein Thema, seinerzeit dann in Form anderer Speicherausstattungen – was selbst heutzutage noch eine "beliebte" Methode der Hersteller ist. AMDs (erst 2011 kommende) Bulldozer-Architektur mit der Modul-Bauweise der Kerne wurde erstmals thematisiert und leider kam das Thema der Bildqualitäts-Optimierungen zurück: So bei Radeon HD 5000 mit neuen Schwächen bei der Filterqualität als auch mittels Radeon HD 5800/5900/6800 mit Rückschritten bei der Filterqualität. Thematisiert wurde zudem das neue Supersampling Anti-Aliasing auf GeForce GTX 470/480 (welches sich auch heutzutage noch nutzvoll erweist) sowie als Supersampling Anti-Aliasing auf ATI & nVidia unter DirectX 10/11. Aus letzterem Artikel stammt auch folgender Screenshot (von Battlefield: Bad Company 2) mit Mouseover-Funktion, welches dann dasselbe Bild mit 2x2 SSAA anzeigt:

MouseOut: no AA (Originalbild), Mouseover: 2x2 SSAA (Originalbild)

Das Jahr 2011 zeigte erneut eine breite Launch-Aktivität, vom Ausbau der Radeon HD 6000 und GeForce 500 Serien über neue DualChip-Modelle von AMD & nVidia in Form von Radeon HD 6990 & GeForce GTX 590 zu den Prozessoren-Launches von Intels Sandy Bridge, AMDs Llano als der ersten Mainstream-APU und AMDs Bulldozer, welches wie bekannt AMDs geschäftliche Dürre-Jahre begründete, bis letztlich kurz vor dem Jahresschluß mit der Radeon HD 7970 noch die Grafikkarte von AMDs nachfolgend langjährig genutzter GCN-Architektur herauskam. Seinerzeit wurden zu den DualChip-Modellen sowie SLI/CrossFire-Kombinationen bereits die Problematik der "Mikroruckler" thematisiert, was dann auch zu einem stark zurückgehenden Interesse an SLI & CrossFire führte.

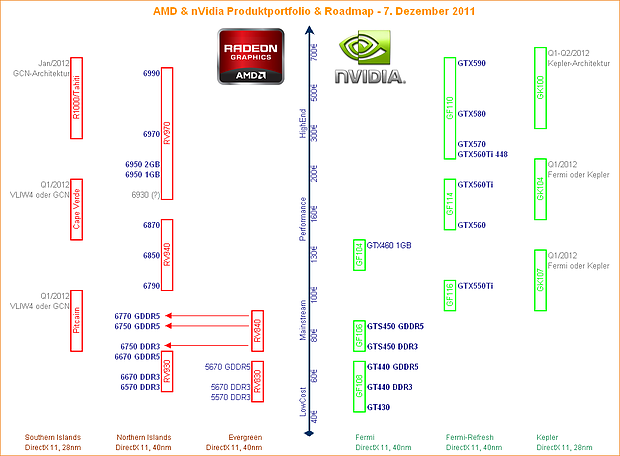

Daneben musste sich wiederum mit dem Thema von beschnittenen Grafikkarten beschäftigt werden, seinerzeit "üblich" waren andere Speichersorten und abgesenkte Speichertaktraten bei vielen Karten des (damals augenscheinlich noch sehr lebendigen) Einsteiger- und Mainstream-Bereichs. Eine andere Betrachtung widmete sich der Frage, ob Bitcoin-Mining per Grafikkarte gewinnbringend sein sein kann – ausgearbeitet im übrigen auf einem Bitcoin-Kurs von seinerzeit 11 Dollar ;) Und letztlich wurde vor Jahresende noch die Frage gestellt, wann videorealistischer Grafik erreicht sein kann (und somit u.a. keine bessere Hardware mehr notwendig wäre), gemäß dem Durchschnitt der seinerzeitigen Umfrage sollte dies grob im Jahr 2030 zu erreichen sein. Aber in dieser Frage verschätzt man sich wohl regelmäßig, die persönliche Erwartung zu Zeiten der Gründung von 3DCenter lag bei etwa 15 Jahren, ergo grob dem Jahr 2015. Daneben erwähnenswert eine der selbsterstellten Grafikchip-Roadmaps aus jener Zeit:

Das Jahr 2012 brachte Launch-seitig den Ausbau der Radeon HD 7000 Serie mittels u.a. Radeon HD 7850 & 7870 sowie nVidias Konter in Form der GeForce GTX 680 samt dem nachfolgenden Ausbau der damit neuen GeForce 600 Serie. CPU-seitig legte Intel Ivy Bridge vor, während AMD mit dem Bulldozer-Refresh Vishera nur eine schwache Antwort hatte, allerdings mittels Trinity eine durchaus griffige APU lieferte. Nichtsdestotrotz sollte AMD noch ganze Ewigkeiten brauchen, um das Thema "APU" wirklich durchzusetzen, die Intel-iGPUs aus dieser Zeit sollte man schließlich besser nicht unter diesem Begriff einordnen. Zu dieser Zeit hatte AMD auch CPU-seitig mit einem eher schlechten Image nach dem verbockten Bulldozer zu kämpfen, war Intel nach Jahren des Erfolgs mit Core 2 & Nehalem oben auf und schickte sich an, fortlaufend neue Core-i-Generationen mit zumeist geringem Vorteil, dafür aber ohne Unterlaß jährlich neu in den Markt zu bringen.

Das Jahr startete im übrigen mit einer neuen Tradition auf 3DCenter in Form des ersten Vorschau-Artikels zum Hardware-Jahr 2012. Desweiteren wurde die Betrachtung zum Grafikkarten-Stromverbrauch professionalisiert, nachdem mehr Meßwerte zu den einzelnen Grafikkarten vorlagen und gleichzeitig mit den DualChip-Modellen die 300W-Marke gefallen war. Seinerzeit schon ein Thema war (am Beispiel der GeForce GTX 660 Ti) die Unsitte vieler Hardware-Tester, Launches von Grafikkarten ohne Referenz-Modell mittels Werksübertaktungen derselben zu begehen – und somit die exakte Performance-Ermittlung zu jener Grafikkarte (auf Referenz-Niveau) zu erschweren. Die hierbei sich ergebenden Unterschiede mögen gering sein, aber dies sind auch Fehler, die man mitschleppt und die sich mit der Zeit addieren können. Heuer ist diese Situation möglicherweise leicht besser, aber immer noch nicht zufriedenstellend.

Auch gab es mal wieder einen Überblick zu den jeweiligen Mobile-Grafiklösungen, wobei in Vorgriff auf heutige Zeiten die jeweiligen Spitzen-Grafikchips nicht verbaut wurden, die Hersteller aber dennoch "kreative" Namenssetzung betrieben. Interessanterweise wurden zu diesen Mobile-Lösungen auch Performance-Index-Werte zum 3DCenter Performance-Index genannt, welcher somit seinerzeit bereits in der einen oder anderen Form aktiv gewesen sein muß. Im Prozessoren-Bereich gab AMD hingegen den Performance-Wettstreit mit Intel (vorerst) auf, während man zu diesen Zeiten im Grafik-Bereich deutlich aggressiver wie frecher auftrat – und den Hardware-Testern vor dem Launch von "Cape Verde" (Radeon HD 7750 & 7770) eine Packung "Verdetrol 1GHz" Performance-Pillen anbot, was sich mit "grüner Troll" übersetzen läßt.

Das Jahr 2013 sah zuerst einmal den Launch eines Unicorns in Form der nVidia GeForce GTX Titan – einer alles dominierenden Grafikkarte auf Basis eines völlig überlegenen Grafikchips (GK110), welche dann auch ewig durchhalten sollte (auch wegen gleich 6 GB VRAM). nVidia baute nachfolgend einen Kepler-Refresh u.a. mit GeForce GTX 780, GeForce GTX 770 & GeForce GTX 760 auf, ehe es kurz vor Jahresschluß mittels der GeForce GTX 780 Ti dann noch Titan-Performance in (halbwegs) günstig gab. Denn die originale GeForce GTX Titan markierte auch den Beginn der vierstelligen Grafikkarten-Preise, was nVidia wie bekannt nachfolgend immer weiter getrieben hat. AMD startet hingegen die "Refresh-Festspiele" – Grafikkarten-Generationen besteht primär nur aus Refreshes, mit allein neuen Top-Chips an der Spitze. Den Anfang gaben die vielfältigen Refresh-Lösungen der Radeon R200 Serie, ergänzt um den neuen Top-Chip "Hawaii" in Form der Radeon R9 290X. CPU-seitig brachte Intel hingegen Haswell in den Markt.

Während man sich seinerzeit mit verschiedenen Hardware-Leveln von DirectX 11 herumärgerte, kündigte AMD die Mantle-API als freie LowLevel-Alternative an. Jene API sollte für einige Jahre aktiv sein, sich aber nie wirklich durchsetzen und letztlich in der inzwischen doch recht erfolgreichen Vulkan-API aufgehen. nVidia stellte hingegen G-Sync vor, eine langfristig sehr bedeutsame und heutzutage nicht mehr wegzudenkende Entwicklung. Ebenfalls mit dabei im Jahr der markanten Ankündigungen waren Futuremark mit ihrem auch jetzt noch gepflegtem 3DMark13. Und letztlich wurden die Zahlen des vorher wohl eher wild herumschwirrenden 3DCenter Performance-Index erstmals in eine saubere Form gebracht, alte und neue Grafikkarten zusammen, geordnet nach Performance, schon ähnlich der heutigen (weiterhin inperfekten) Form.

Das Jahr 2014 sah eine Ausnahme in Intels stetiger Releaseabfolge, da es für dieses Jahr nur einen Haswell-Refresh gab. nVidia brachte hingegen mit GeForce GTX 750 & 750 Ti die ersten Maxwell-basierten Grafikkarten heraus, wenngleich jene noch unter dem Verkaufsnamen der eigentlich Kepler-basierten GeForce 700 Serie liefen. Die "richtigen" Maxwell-Modelle folgten dann später im Jahr mittels GeForce GTX 970 & 980 – wobei es sich zugleich um die ältesten Grafikkarten handelt, welche derzeit noch mit voll aktualisierten Treibern bedacht werden. AMD brachte hingegen mit der Radeon R9 295X2 eine letzte DualChip-Grafikkarte heraus, danach erledigte sich das Thema für die Hersteller allerdings. Dabei kam das (spätere) Ende nicht einmal durch das leidige Thema der Mikroruckler, sondern vielmehr durch neuere Spiele-Engines, welche nicht mehr kompatibel zu SLI und CrossFire zu bekommen waren.

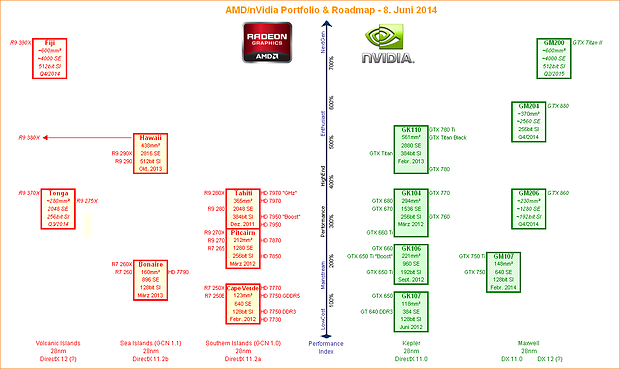

Dies ist auch der Grund, wieso SLI & CrossFire nicht zurückkommen werden – zukünftige MultiChip-Konstruktionen wird man vielmehr derart gestalten müssen, dass jene vom Spiel her als "ein" Grafikchip betrachtet werden können. Im Jahr 2014 ging das ganze aber augenscheinlich noch in Ordnung, wie Performance-Werte zu Quad-SLI mit der GeForce GTX 980 zeigen. Gleichfalls produzierten sich AMD und nVidia in der Disziplin "Marketing-Anspruch & Benchmark-Wirklichkeit": AMD mit nicht wirklich stimmenden Performance-Werten zur Radeon R9 285, nVidia mit nicht korrekten Aussagen zur Energieeffienz der GeForce GTX 980. Sicherlich viel eher positiv dagegen die AMD-Ankündigung von FreeSync als freiem G-Sync-Kontrahenten, welches sich insbesondere in neuer Zeit dann doch durchgesetzt hat. Zu erwähnen daneben eine der vielen eigenerstellten Grafikchip- & Grafikkarten-Roadmaps jener Zeit, welche mal mehr und mal weniger akkurat die kommende Entwicklung vorzuzeichnen versuchte: