Hauptlinks

Suchen

nVidia-Grafik

Neuer Artikel: Wie nVidias Turing-Generation aussehen könnte

Mit den Gerüchten bezüglich der konkreten Ausformung von nVidias Turing-Generation ist es in letzter Zeit ein bißchen durcheinander gegangen: Zuerst gab es angebliche Hardware-Daten, welche allgemein als zu niedrig angesetzt erschienen, zuletzt wieder neue Hardware-Daten, welche doch eher eine Spur zu optimistisch waren – und zu den vorliegenden konkreten Daten zu den vermutlichen Turing-Chips GT104 (HighEnd) bzw. GT102 (Enthusiast) haben beide wenig gepasst. Jetzt könnten beide früheren Gerüchte natürlich auch gänzlich aus der Luft gegriffen gewesen sein – oder aber es ist das passiert, was ziemlich häufig vorkommt: Eine Information geht durch mehrere Personen, welche die eigentlich gegebene Information nur in ihrer jeweils eigenen Auslegungsweise weitergeben und damit dann letztlich für eine gewisse Verfälschung sorgen. Damit können durchaus unsinnig erscheinende Angaben herauskommen, welche nicht zu bekannten Fakten passen wollen – obwohl die Sache weiterhin einen wahren Kern trägt. Und selbigen wollen wir mal versuchen herauszuarbeiten – basierend auf den bekannten Hardware-Daten und dann unter Einarbeitung der vorliegenden Gerüchte, sofern dies möglich ist bzw. zu einem stimmigen Ergebnis führt ... zum Artikel.

| Grafikkarten | Speicher | TDP | Performance | Listenpreis |

|---|---|---|---|---|

| Titan Xp ➔ Titan XT | 12 GB ➔ 24 GB | 250W ➔ 300W | ~187% ➔ ~260-280% | 1200$ ➔ 1500$ |

| GeForce GTX 1080 Ti ➔ GeForce GTX 1180 Ti | 11 GB ➔ 12 GB | 250W ➔ 300W | 175% ➔ ~250-260% | 699$ ➔ 899-999$ |

| GeForce GTX 1080 ➔ GeForce GTX 1185 | 8 GB ➔ 16 GB | 180W ➔ 230W | 132% ➔ ~180-200% | 499$ ➔ 699-749$ |

| GeForce GTX 1070 Ti ➔ GeForce GTX 1180 | 8 GB ➔ 8 GB | 180W ➔ 210W | 122% ➔ ~160-170% | 449$ ➔ 599$ |

| GeForce GTX 1070 ➔ GeForce GTX 1170 | 8 GB ➔ 8 GB | 150W ➔ 180W | 107% ➔ ~130-140% | 379$ ➔ 499$ |

| Performance-Werte gemäß des 4K Performance-Index, alle Angaben zu Turing-Karten sind zumeist rein spekulativ. | ||||

Platinen-Layout der GeForce GTX 1180 spricht für mittelgroßen Grafikchip mit 256-Bit-Interface samt 8/16 GB Speicher

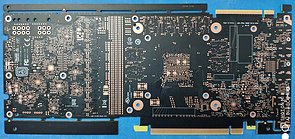

Im chinesischen Baidu-Forum (maschinelle Übersetzung ins Deutsche, via Videocardz) sind Fotos einer neuen nVidia-Grafikkarte bzw. von deren unbestückter Platine (PCB) aufgetaucht, welche für die kommende GeForce GTX 1180 aus der Turing-Generation gedacht sein soll. Die Platine gehört augenscheinlich zu einer neuen Grafikkarten-Generation, da DVI-Ausgänge und SLI-Konnektoren fehlen, für letzteres ist dagegen ein NVLink-Anschluß mit dabei. Da die Beschriftung auf nVidia selber hindeutet, dürfte es sich hierbei um eine Referenzplatine handeln, ergo kein Eigendesign eines der Grafikkarten-Hersteller. Die zu sehenden Zertifikationslogos weisen zudem auf den finalen Status dieser Platinen hin:

nVidia GeForce GTX 1180 PCB-Rückseite

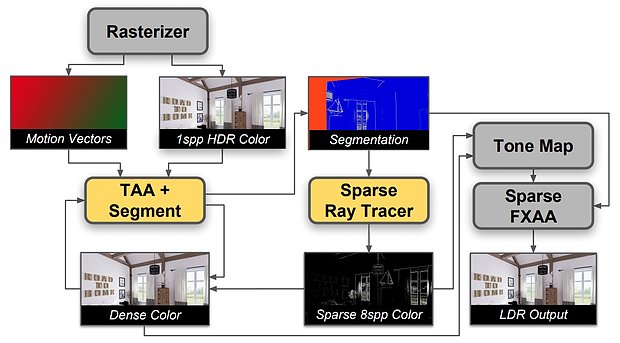

nVidia stellt "Adaptive Temporal Antialiasing" als erste RayTracing-Anwendung vor

Grafikchip-Entwickler nVidia hat mittels "Adaptive Temporal Antialiasing" (ATAA) eine neue Art von Kantenglättung vorgestellt, welche für ihr Wirken unter anderem Hardware-basiertes RayTracing benutzt. Grundsätzlich handelt es sich bei "Adaptive Temporal Antialiasing" um eine Erweiterung des bekannten "Temporal Antialiasing" (TAA, nicht zu verwechseln mit "Temporal Approximate Anti Aliasing" aka TXAA), welches den Postprocessing-Weichzeichner FXAA mit einer zeitlichen (temporalen) Komponente vermischt, um besonders in Bewegung gute Ergebnisse erzielen zu können. Nichtsdestotrotz ist bei TAA weiterhin aufgrund der FXAA-Basis ein nicht unerheblicher Weichzeichner-Effekt zu sehen, welcher zudem besonders feine Details dann auch gleich ganz verschwinden lassen kann. Mittels ATAA will man nunmehr basierend auf TAA gewisse Bildteile durch ein adaptives RayTracing-Verfahren besonders exakt glätten, um gerade dieser Problematik der Vernichtung besonders feiner Details entgegenzuwirken.

Gerüchteküche: Völlig abweichende Angaben zu Performance & Stromverbrauch der Turing-Grafikkarten

Die kürzliche Meldung mit ersten Performance-Angaben zur Turing-Generation hat für reichlich Kommentare gesorgt – in vielen Fällen sah man dabei unrealistische, weil als zu niedrig empfundene Werte. Das die Werte niedriger sind als zuletzt allgemein erwartet, läßt sich nicht abstreiten – andererseits sieht die Quelle vergleichsweise seriös aus und ist es durchaus nicht verkehrt, auch mal etwas auf die Bremse zu treten, ehe die Erwartungen wieder in den Himmel wachsen. Allerdings gibt es inzwischen auch noch andere Performance-Angaben zur Turing-Generation, welche in die komplett gegensätzliche Richtung gehen. Laut WCCF Tech (wie üblich ohne Quellenangabe) kommen allesamt im September gleich drei Turing-basierte Grafiklösungen, zu welchen derzeit aber nur TDPs und Listenpreise genannt wurden. Zusammen mit einer gleichzeitig zum Turing-Launch in Kraft tretenden Preissenkung bei GeForce GTX 1080 (von 499$ auf 449$) und GeForce 1080 Ti (von 699$ auf 599$) läßt sich allerdings trotzdem schon ganz gut hochrechnen, auf welche Performance-Höhen die Turing-Grafikkarten gemäß dieses Gerüchts ungefähr kommen sollten:

| Listenpreis | TDP | Performance | Releasetermin | |

|---|---|---|---|---|

| 180W-Turing-Lösung | 699-749$ | 180W | eigene Schätzung: 190-220% | erste September-Woche 2018 |

| 150W-Turing-Lösung | 599$ | 150W | eigene Schätzung: 160-180% | zweite September-Woche 2018 |

| GeForce GTX 1080 Ti | 599$ (alt: 699$) | 250W | 175% | 10. März 2017 |

| 120W-Turing-Lösung | 499$ | 120W | eigene Schätzung: 140-150% | Ende September 2018 |

| GeForce GTX 1080 | 449$ (alt: 499$) | 180W | 132% | 17. Mai 2016 |

| Performance-Werte gemäß des 4K Performance-Index, alle Angaben zu Turing-Karten sind derzeit natürlich ungesichert | ||||

Gerüchteküche: Erste Angaben zu Performance & Stromverbrauch von GeForce GTX 1170 & 1180

Aus dem chinesischen Chiphell-Forum (via Videocardz) kommen erste, durchaus seriös aussehende Details zur Performance-Klasse und zum Stromverbrauch von GeForce GTX 1170 und GeForce GTX 1180. Die Herkunft der Information deutet auf Kreise von Komponenten- oder Grafikkarten-Hersteller hin, kann aber (natürlich) nicht sicher bestätigt werden – man kann allenfalls anhand der dargebrachten Daten einschätzen, ob das ganze realistisch ist oder nicht. Bei Chiphell-Informationen schwingt das Pendel vorerst in Richtung "wahrscheinlich", da alle Angaben in einem unaufgeregtem Stil dargebracht wurden und zudem inhaltlich sowohl realistisch erscheinen als auch teilweise sich mit anderen Vorab-Informationen decken. So kann man die GeForce GTX 1180 grob als Grafikkarte knapp unterhalb des Performance-Levels der GeForce GTX 1080 Ti mit einer TDP von 210 Watt einordnen, die GeForce GTX 1170 dagegen grob als Grafikkarte exakt auf dem Performance-Level der GeForce GTX 1080 mit einer TDP von 180 Watt:

1: Das PCB wurde gestern fertig, das komplette Produkt wurde jedoch noch nicht fertiggestellt.

2: GeForce GTX 1180 (Referenzdesign): 210 Watt Stromverbrauch, Performance ist sehr nahe an der GeForce GTX 1080 Ti.

3: GeForce GTX 1170 (Referenzdesign): 180 Watt Stromverbrauch, Performance entspricht der GeForce GTX 1080.

4: Die gesamte Serie kommt ohne die DVI-Schnittstelle daher, dagegen wird es eine Type-C-Schnittstelle geben.

Quelle: User "airforce18" im Chiphell-Forum am 21. Juli 2018 (übersetzt ins Deutsche)

Angebliche Launchtermine zu GeForce GTX 1160, 1170 & 1180 aufgetaucht

Das Video-Magazin Gamer Meld (Screenshots bei Videocardz) hat ein (angebliches) Schreiben eines Grafikkarten-Herstellers an vermutlich einen Distrutionspartner vorliegen, in welchem zum einen über hohe Lagerbestände an Grafikkarten der Pascal-Generation berichtet wird, welche dann auch eine gewisse Verzögerung des Turing-Launches zur vorherigen Lagerbereinigung begründen. Zum anderen werden konkrete Turing-Grafikkarten samt deren (neuer) Launchtermine genannt – womit es erstmals eine konkrete Terminaussage zur Turing-Generation gibt. Gleichfalls wird über die Nennung der Grafikkarten-Namen bestätigt, das nVidia die Turing-Generation als "GeForce 11" (oder auch "GeForce 1100") Serie laufen läßt, sich damit also zugunsten einer ziemlich althergebrachten Grafikkarten-Benennung entschieden hat. Das Schreiben selber sieht authentisch aus, könnte nichtsdestrotz natürlich trotzdem ein Troll- oder Fake-Versuch sein – letztlich kann nur die Zukunft erweisen, ob diese Angaben korrekt sind.

| angeblicher Launchtermin | Grafikkarte | vmtl. Chip-Basis | ersetzt Pascal-Lösung |

|---|---|---|---|

| 30. August 2018 (Donnerstag) | GeForce GTX 1180 | nVidia GT104 | GeForce GTX 1080 Ti |

| 30. September 2018 (Sonntag) | GeForce GTX 1170 | nVidia GT104 | GeForce GTX 1080 |

| 30. September 2018 (Sonntag) | GeForce GTX "1180+" | ? | ? |

| 30. Oktober 2018 (Dienstag) | GeForce GTX 1160 | nVidia GT106 | GeForce GTX 1070 & 1070 Ti |

| Quelle der Launchtermine: Gamer Meld @ YouTube | |||

Erster (angeblicher) 3DMark13-Wert zur Turing-basierten GeForce GTX 1170 aufgetaucht

Im Spekulations-Thread des 3DCenter-Forums zu nVidias Turing-Generation ist ein Screenshot mit einem angeblichen Benchmarkwert der GeForce GTX 1170 unter dem 3DMark13 "FireStrike" aufgetaucht. Jener Screenshot kommt aus dem Overclockers UK Forum, stammt jedoch original aus dem polnischen Forum von FrazPC, ist dort aber leider nicht wirklich zu finden gewesen. Angeblich ist hierbei der Wert einer EVGA-Grafikkarte zu sehen, welche ein Performance-Level sogar knapp oberhalb der GeForce GTX 1080 Ti erreicht. Die Karte selber soll dabei mit gleich 16 GB Grafikkartenspeicher ausgerüstet sein, die angegebenen Taktraten sehen allerdings mit 2512/2552 MHz etwas seltsam aus. Der sehr hohe Chiptakt von 2512 MHz könnte aus generell höheren Taktraten, einem geänderten Boost-Verhalten oder einfach nur Übertaktung resultieren, der ebenfalls hohe Speichertakt von 2552 MHz ist dagegen schwer einzuordnen: Für GDDR5X oder GDDR6 würde dies ganze 20 Gbps ergeben – eine Übertaktung, welche derzeit kaum erreichbar scheint. Nur im Sinne von der Verwendung von GDDR5-Speicher ergäbe diese Taktrate Sinn – dies wären dann 5000 MHz DDR, was sowohl mittels Übertaktung erreichbar ist, also auch von einige Speicherchip-Herstellern inzwischen schon als default-Taktrate angeboten wird.

| Technik | 3DM13 FS Score | 3DM13 FS GPU | Quelle(n) | |

|---|---|---|---|---|

| GeForce GTX 1170 | nVidia GT104 (Turing), 2512/2552 MHz (OC?), 16 GB | 22989 | 29752 | Leak aus dem FrazPC-Forum |

| GeForce GTX 1080 Ti | nVidia GP102 (Pascal), 1480/1582/2750 MHz, 11 GB GDDR5X | 22808 | 28391 | Guru3D & KitGuru |

| Radeon RX Vega 64 | AMD Vega 10, 1247/1546/945 MHz, 8 GB HBM2 | 19200 | 22931 | Guru3D & KitGuru |

| GeForce GTX 1080 | nVidia GP104 (Pascal), 1607/1733/2500 MHz, 8 GB GDDR5X | 19370 | 21478 | Guru3D & KitGuru |

| Radeon RX Vega 56 | AMD Vega 10, 1156/1471/800 MHz, 8 GB HBM2 | 16842 | 20463 | Guru3D & KitGuru |

| GeForce GTX 1070 Ti | nVidia GP104 (Pascal), 1607/1683/4000 MHz, 8 GB GDDR5 | 17145 | 19915 | Guru3D & KitGuru |

| GeForce GTX 1070 | nVidia GP104 (Pascal), 1506/1683/4000 MHz, 8 GB GDDR5 | 16229 | 18016 | Guru3D & KitGuru |

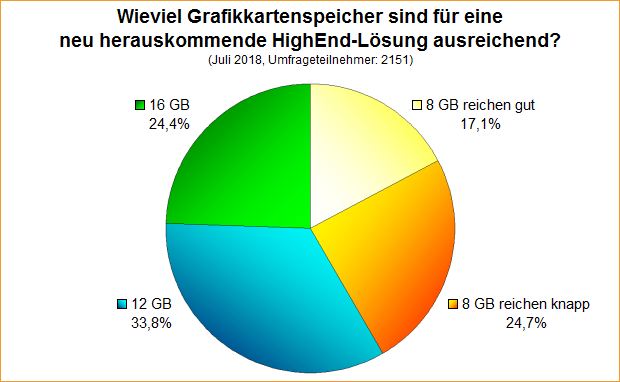

Umfrage-Auswertung: Wieviel Grafikkartenspeicher sind für eine neu herauskommende HighEnd-Lösung ausreichend?

Bei der Umfrage von letzter Woche ging es um die Frage, wieviel Grafikkartenspeicher für eine jetzt neu herauskommende HighEnd-Lösung als ausreichend angesehen wird. Hierbei ging es eher um die unterste Menge an Grafikkartenspeicher, welcher diese Grafikkarte noch sinnvoll verwendbar macht – und weniger um die Frage, was man am liebsten als Speichermenge sehen würde. Schließlich können auch die Grafikchip-Entwickler hierbei nur einen Mittelweg aus Sinnhaftigkeit und steigender Kostenlage wählen, ein bedingungsloses "Immer Mehr!" ist schon allein aus betriebswirtschaftlicher Sicht nicht realisierbar. Zu beachten war bei dieser Umfrage zudem der Punkt, das explizit im Sinne einer HighEnd-Lösung gefragt wurde, sprich einem sinngemäßen Nachfolger der GeForce GTX 1080 (wahrscheinlich "GeForce GTX 1180" genannt), welche in Form einer nachfolgenden Enthusiasten-Lösung (wahrscheinlich "GeForce GTX 1180 Ti" genannt) letztlich nicht die Speerspitze des kommenden Grafikkarten-Portfolios auf Basis von nVidias Turing-Generation darstellen wird, sondern "nur" die zweitbeste aufgebotene Lösung.

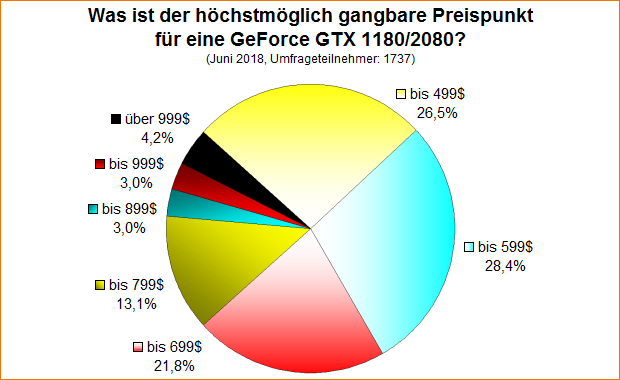

Umfrage-Auswertung: Was ist der höchstmöglich gangbare Preispunkt für eine GeForce GTX 1180/2080?

Zum kommenden Turing-Launch darf man sicherlich auf eine gute Mehrperformance hoffen – und muß genauso befürchten, das nVidia seine dann unangefochtene Stellung an der Leistungsspitze zu vielleicht sogar erheblichen Preissteigerungen ausnutzt. Bis zu einem gewissen Grad kann man dies meistens noch irgendwie mitgehen, aber irgendwann ist dann sicherlich genug, gerade sofern nVidia die Turing-Generation wirklich nicht mit der Enthusiasten-Lösung "GeForce GTX 1180 Ti", sondern der HighEnd-Lösung "GeForce GTX 1180" eröffnen sollte. Eine Umfrage von Mitte Juni ging somit der Frage nach, was der höchstmögliche noch gangbare Preis für eben diese HighEnd-Lösung in Form von "GeForce GTX 1180" oder "GeForce GTX 2080" sein darf – immer eingerechnet den Umstand, das dies langfristig nur die zweitschnellste Turing-Lösung sein wird, später da also noch einmal eine "Ti"-Lösung oben drauf gesetzt werden dürfte.

Weiterer Test zur GeForce GTX 1050 3GB aufgetaucht

Mittels eines Artikels seitens Tom's Hardware hat sich ein weiterer Test zur GeForce GTX 1050 3GB eingefunden – welcher sogar noch vor dem schon besprochenen Test von Guru3D herauskam, was uns allerdings (leider) entgangen war. Beide Tests bestätigen sich von der grundsätzlichen Performance der GeForce GTX 1050 3GB her nunmehr gegenseitig: Die 3-GB-Karte kommt grob in der Mitte zwischen regulärer GeForce GTX 1050 2GB und der größeren GeForce GTX 1050 Ti heraus, allerdings mit leichter Tendenz zu letztgenannter (größerer) Karte. Insofern kann die bisherige Einstufung im 3DCenter FullHD Performance-Index von ~340% weiterhin aufrecht gehalten werden. Aufgrund der sowieso geringen Abstände dieser Karten untereinander dürften sich hier auch keine Verschiebungen mehr ergeben – und kommagenau ist der Performance-Index sowieso nicht gedacht, hierbei geht es eher um grobe Angaben zum Aufbau eines umfassenden Gesamtbilds.

| GeForce GTX 1050 2GB | GeForce GTX 1050 3GB | GeForce GTX 1050 Ti | |

|---|---|---|---|

| Testmuster bei Tom's | MSI-Modell, Werks-OC auf 1404/1518/3500 MHz (+4% Chiptakt) | unspezifiziertes Modell, wahrscheinlich auf Referenz-Taktung | MSI Gaming X, Werks-OC auf 1354/1468/3500 MHz (+5% Chiptakt) |

| FullHD-Performance lt. Tom's | 86,9% (-13,1%) | 93,0% (-7,0%) | 100% |

| Testmuster beim Guru3D | MSI Gaming X, Werks-OC auf 1417/1531/3500 MHz (+5% Chiptakt) | MSI-Modell, 1392/1518/3500 MHz (Referenz-Taktung) | MSI Gaming X, Werks-OC auf 1354/1468/3500 MHz (+5% Chiptakt) |

| FullHD-Performance lt. Guru3D | 84,5% (-15,5%) | 92,4% (-7,6%) | 100% |

| WQHD-Performance lt. Guru3D | 81,3% (-18,7%) | 89,9% (-10,1%) | 100% |

| 3DCenter FullHD Perf.Index | 310% | ~340% | 360% |