Hauptlinks

Suchen

nVidia-Grafik

nVidia verspricht +47% Mehrperformance zwischen GeForce GTX 1080 und GeForce RTX 2080

Auf einem "Editor's Day" am Mittwoch hat nVidia die Fachpresse noch etwas genauer bezüglich der kommenden Turing-Generation gebrieft. Hierbei sind dann endlich auch einmal ein paar Balken abgefallen – oft geschmäht und dennoch grundsätzlich benötigt, selbst wenn es sich nur um nVidia-eigene Performancemessungen handelt. nVidia hat hierbei auf 10 Spieletiteln unter der UltraHD-Auflösung zwischen Pascal-basierter GeForce GTX 1080 sowie Turing-basierter GeForce RTX 2080 die erreichten Frameraten verglichen, in 6 von 10 Spieletiteln kam zusätzlich noch eine Messung unter dem Turing-eigenem "Deep Learning Super-Sampling" (DLSS) hinzu. Bei selbiger ist natürlich nicht klar, welches andere Anti-Aliasing-Verfahren im jeweiligen Spiel hierfür deaktiviert wurde bzw. ob die Bild- und Aliasing-Qualität dann wirklich gleichwertig zu DLSS ist. Aber es liegt hiermit nun jedenfalls ein vernünftig breites Benchmark-Set unter ganz gewöhnlichen Spielen vor, welche ohne RayTracing liefen und somit die Normalperformance der GeForce RTX 2080 wiedergeben sollte.

| UltraHD | UltraHD mit DLSS | |

|---|---|---|

| GeForce RTX 2080 vs. GeForce GTX 1080 | +47% | +103% |

| Wertequelle | Schnitt aus 10 Spieletiteln | Schnitt aus 6 Spieletiteln |

| niedrigste/höchste Werte | minimal +34%, maximal +59% | minimal +82%, maximal +124% |

nVidia stellt GeForce RTX 2070, 2080 & 2080 Ti für eine Auslieferung ab dem 20. September vor

Mit einem Live-Event auf der beginnenden Gamescom (Replay) hat nVidia seine lange erwarteten ersten Turing-basierten Gaming-Grafikkarten in Form von GeForce RTX 2070, GeForce RTX 2080 und GeForce RTX 2080 Ti offiziell vorgestellt. Die beiden letztgenannten Grafikkarten gehen dabei (in exakt einem Monat) am 20. September 2018 in den Handel, wobei die Herstellerdesigns am selben Tag verfügbar sein werden – die kleinere GeForce RTX 2070 folgt dann zu einem noch nicht genauer genannten Termin im Oktober 2018 nach. Dabei basieren GeForce RTX 2070 & 2080 zusammen auf dem kleineren Turing-Chip TU104, zu welchem es nach wie vor nur inoffizielle Angaben gibt, die GeForce RTX 2080 Ti dagegen auf dem größeren Turing-Chip TU102, welchen nVidia bei der Vorstellung der Quadro-RTX-Karten bereits eingehend beleuchtet hatte. Die Hardware-Daten der beiden größeren RTX-Karten entsprechen dabei den zuletzt gerüchteweise verbreiteten Daten: 4352 Shader-Einheiten an einem 352 Bit GDDR6-Interface bei der GeForce RTX 2080 Ti sowie 2944 Shader-Einheiten an einem 256 Bit GDDR6-Interface bei der GeForce RTX 2080, die kleinere GeForce RTX 2070 wird dann 2304 Shader-Einheiten an einem 256 Bit GDDR6-Interface erhalten.

| GeForce RTX 2070 | GeForce RTX 2080 | GeForce RTX 2080 Ti | |

|---|---|---|---|

| Chipbasis | nVidia TU104, in 12nm bei TSMC (?) | nVidia TU104, in 12nm bei TSMC | nVidia TU102, 18,6 Mrd. Transistoren auf 754mm² Chipfläche in 12nm bei TSMC |

| Technik | 2304 Shader-Einheiten @ 256 Bit GDDR6-Interface | 2944 Shader-Einheiten @ 256 Bit GDDR6-Interface | 4352 Shader-Einheiten @ 352 Bit GDDR6-Interface |

| Takt (Referenz) | 1410/1620/3500 MHz | 1515/1710/3500 MHz | 1350/1545/3500 MHz |

| Takt (Founders Edition) | 1410/1710/3500 MHz | 1515/1800/3500 MHz | 1350/1635/3500 MHz |

| Speicherausbau | 8 GB GDDR6 | 8 GB GDDR6 | 11 GB GDDR6 |

| Stromstecker | 1x 8pol. | 1x 6pol. + 1x 8pol. | 2x 8pol. |

| GCP | 175W (Ref.) / 185W (FE) | 215W (Ref.) / 225W (FE) | 250W (Ref.) / 260W (FE) |

| Ausgänge | DisplayPort 1.4, HDMI 2.0b, USB Type-C | DisplayPort 1.4, HDMI 2.0b, USB Type-C | DisplayPort 1.4, HDMI 2.0b, USB Type-C |

| Listenpreis (Referenz) | 499$ | 699$ | 999$ |

| Preis (Founders Edition) | 599$ bzw. 639€ | 799$ bzw. 849€ | 1199$ bzw. 1259€ |

| Release | Oktober 2018 | 20. September 2018 | 20. September 2018 |

| Die Angaben dieser Tabelle basieren ausschließlich auf offiziellen Hersteller-Aussagen (Ausnahme: Chipbasis der GeForce RTX 2070). | |||

PNY leakt ausgesprochen handzahme Taktraten zu GeForce RTX 2080 & 2080 Ti

Seitens des Grafikkarten-Hersteller PNY gab es einen sicherlich unbeabsichtigen Leak, als diverse im Hintergrund bereits vorbereitete Produkt-Webseiten zur "PNY GeForce RTX 2080 8GB XLR8 Gaming Overclocked Edition" sowie zur "PNY GeForce RTX 2080 Ti 11GB XLR8 Gaming Overclocked Edition" kurzzeitig bereits online sichtbar waren. Das hiervon umgehend Kopien angefertigt werden (so in unserem Forum: No.1 & No.2), ist vollkommen unvermeidlich – womit nun ernstmals offizielle Daten zu diesen beiden Turing-basierten Grafikkarten vorliegen. Nachteiligerweise müssen noch nicht alle der einzelnen Angaben korrekt sein, sind sogar augenscheinliche Fehler zu finden und besteht immer auch die Chance auf eventuelle Platzhalter-Daten. Andere Angaben sind dann jedoch ausreichend abweichend von der vorhergehenden Pascal-Generation, das man sich diesbezüglich ziemlich sicher sein kann – wie die TDP der GeForce GTX 2080 Ti von 285 Watt (für die werksübertaktete PNY-Ausführung). Bei der GeForce GTX 2080 wurde hingegen der gleiche Wert eingetragen, was dann offensichtlich einen Copy&Paste-Fehler darstellt – wie gesagt sind die PNY-Datenblätter nicht fehlerfrei.

| Chip | Hardware | Taktraten | Speicher | TDP | Stromstecker | |

|---|---|---|---|---|---|---|

| PNY GeForce RTX 2080 Ti 11GB XLR8 Gaming Overclocked Edition |

TU102 | 4352 Shader-Einheiten (34 von 36 CU) 352 Bit GDDR6-Speicherinterface |

1350/1545/3500 MHz | 11 GB GDDR6 | 285W | 2x 8pol. |

| PNY GeForce RTX 2080 8GB XLR8 Gaming Overclocked Edition |

TU104 | 2944 Shader-Einheiten (23 von 24 CU) 256 Bit GDDR6-Speicherinterface |

?/1710/3500 MHz | 8 GB GDDR6 | ? | 1x 6pol. + 1x 8pol. |

| Alle Angaben basieren auf PNY-Datenblättern, abzüglich offensichtlicher Fehler. | ||||||

Referenzplatine zur GeForce RTX 2080 zeigt ~540mm² großen TU104-Chip

Aus dem Baidu-Forum kommt nun auch noch das Bild einer zur GeForce RTX 2080 gehörenden nVidia-Referenzplatine, welche einige offenen Fragen zu den Gaming-Lösungen der Turing-Generation beantwortet. So wurde die Platine mit verbautem Grafikchip, aber ohne Kühlkörper aufgenommen – womit sich darunter ein "nVidia Turing TU104-400-A1" zeigt, sprich der TU104-Chip in der 400er-Ausführung (gewöhnlich die größte im Gaming-Segment benutzte) im A1-Stepping, welches üblicherweise nur für Sammpling-Zwecke benutzt wird. nVidia hat dem ganzen also doch noch neue Grafikchip-Codenamen gegeben und die kürzlich bei diversen Hardwareinfo-Tools aufgetauchten Einträge zugunsten von GV102 & GV104 sind somit noch auf einem alten Stand. Seinen Ausgang wird der TU104-Chip sicherlich im GV104-Chip genommen haben, aber nVidia hat beim Wechsel von der Volta- auf die Turing-Architektur nun eben noch die RayTracing-Funktionalität hinzugetan, was dann letztlich sowohl die neue Chip-Generation als auch neue Codenamen rechtfertigt.

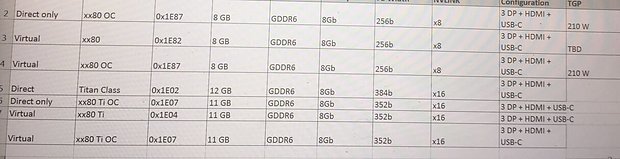

Erste wahrscheinlich authentische Spezifikationen zur GeForce 20 Serie sehen unveränderte Speichermengen

Ausgehend vom chinesischen Baidu-Forum (via Videocardz) macht derzeit eine Spezifikations-Tabelle zu den Gaming-Lösungen der kommenden Turing-Generation die Runde, welche wahrscheinlich authentisch ist und wohl von einem der Grafikkarten-Hersteller stammt. Alternativ verbreitete Karten-Spezifikationen, welche auf den Einträgen in der TechPowerUp-Datenbank basieren, sind dagegen unserer Meinung nach nicht ernst zu nehmen, da vor Release üblicherweise mit Platzhalter-Daten bzw. bestenfalls reinen Annahmen erstellt, nicht jedoch auf Basis von irgendwie bekanntem Wissen. Bei Baidu gibt es hingegen noch keine kompletten Hardware-Spezifikationen, dagegen sind dort andere wichtige Daten abzulesen. Die Grundlage stellt zwar "nur" die Fotographie einer Excel-Auflistung dar, aber jene listet an anderer Stelle genannte Device-Nummern, die korrekte Art an Monitor-Anschlüssen, die korrekte nVidia-Bezeichnung für Stromverbrauchswerte (TGP anstatt TDP) und letztlich "NVLink" als die bei der Turing-Generation eingesetzte Verbindungs-Technologie auf, scheint damit also ziemlich wahrscheinlich "echt" zu sein.

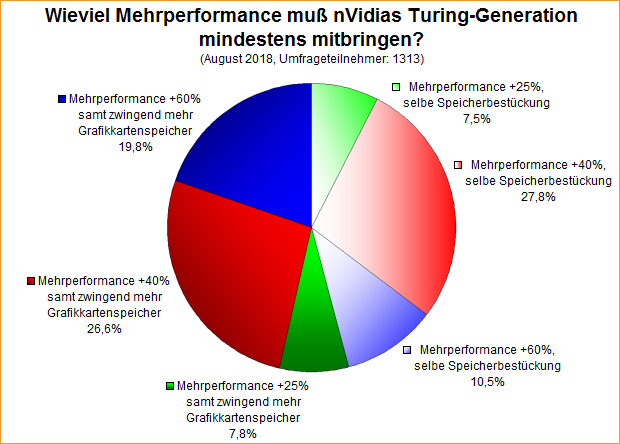

Umfrage-Auswertung: Wieviel Mehrperformance muß nVidias Turing-Generation mindestens mitbringen?

Bei einer Umfrage vom Monatsanfang ging es darum, herauszufinden, mit wieviel Mehrperformance samt eventuellem Mehrspeicher nVidia bei der sich nun inzwischen entblätternden Turing-Generation mindestens ankommen muß, um für die Grafikkarten-Käufer ausreichend interessant zu sein. Teilweise gibt es nunmehr inzwischen eine gewisse Vorstellung zu diesen Fragen, aber zum Umfrage-Zeitpunkt war dies noch komplett offen, konnte frei von der Leber weg abgestimmt werden. Dabei bekam jede der Antwortoptionen ihre Stimmen – aber sicherlich die Antwortoption mit einer nur 25%igen Mehrperformance den geringsten Stimmenanteil mit nur 15,3%, während die Antwortoption einer 40%igen Mehrperformance mit 54,4% Stimmenanteil die absolute Mehrheit holte und selbst die Antwortoption einer 60%igen Mehrperformance mit einem Stimmenanteil von 30,3% noch bedeutsam groß ausfiel.

nVidia teasert die Turing-basierte "GeForce RTX 2080" für eine Vorstellung zur Gamescom an

Mittels eines Videos hinterläßt nVidia reihenweise Anspielungen auf die kommenden Turing-basierten Gaming-Lösungen. Videocardz haben alle zu sehenden Teaser zusammengetragen, wonach sich klar der Verkaufsname der nächsten Gaming-Grafikkarte als "GeForce RTX 2080" ergibt – und zudem ein Datum wie eine Location, welches auf die Gamescom in Köln am 20. August 2018 hinausläuft. Zu diesem Zeitpunkt dürfte nVidia die Turing-basierten Gaming-Lösungen also vorstellen oder wenigstens offiziell ankündigen, ab 18 Uhr an diesem Tag wird nVidia den Livestream zu einer "GeForce Gaming Celebration" senden. Ob es zu diesem Zeitpunkt bereits Launchreviews und nachfolgend eine Marktverfügbarkeit gibt, bleibt noch abzuwarten, ist aber nicht unbedingt wahrscheinlich – üblicherweise teilt man dies heutzutage etwas auf, auf eine Ankündigung folgt wenig später der echte Launch, und auch der eigentliche Markteintritt könnte dann noch um ein paar Tage zeitversetzt erfolgen. Das ganze dürfte somit eine Angelegenheit von Ende August bis Anfang September werden.

| Chip | Hardware | 4K Perf. | Release | |

|---|---|---|---|---|

| Titan XT | Turing GV102 | vermtl. 4608 Shader-Einheiten @ 384 Bit Interface | geschätzt ~230-260% | Herbst 2018 |

| GeForce RTX 2080 Ti | Turing GV102 | vermtl. 4352-4480 Shader-Einheiten @ 352-384 Bit Interface | geschätzt ~210-240% | Herbst 2018 (?) |

| GeForce RTX 2080 | Turing GV104 | vermtl. 3072 Shader-Einheiten @ 256 Bit Interface | geschätzt ~160-180% | August/Sept. 2018 |

| GeForce RTX 2070 | Turing GV104 | vermtl. 2432-2560 Shader-Einheiten @ 256 Bit Interface | geschätzt ~130-150% | Herbst 2018 |

| Die Angaben dieser Tabelle stellen primär ungesicherte Annahmen dar, Performance-Werte gemäß des 4K Performance-Index. | ||||

nVidia stellt mit Quadro RTX 5000, 6000 & 8000 die ersten Teile der Turing-Generation vor

Der nVidia-Event auf der Siggraph 2018 letzte Nacht (Replay) brachte die Vorstellung neuer Quadro-Karten mit sich – welche ganz offiziell auf der Turing-Architektur basieren und damit deren Startschuß geben. Konkret wurden Quadro RTX 5000, 6000 & 8000 mit einige technischen Daten für eine Auslieferung in diesem Herbst vorgestellt, woraus sich auch schon gute Rückschlüsse auf die zugrundeliegenden Grafikchips und sowie die späteren darauf basierenden Gaming-Lösungen ziehen lassen. Zwar nannte nVidia keine Grafikchip-Codenamen, aber in jedem Fall basieren Quadro RTX 6000 & 8000 auf dem größeren Turing-Chip, welcher immerhin 18,6 Mrd. Transistoren in einer Chipfläche von satten 754mm² unterbringt – während die Quadro RTX 5000 auf dem kleineren Turing-Chip basiert, zu welchem noch keine derartig detaillierten Informationen vorliegen. Da aber die Speicherinterfaces der beiden Turing-Chips mit 384 bzw. 256 Bit GDDR6 bekannt sind, dürfte klar sein, das sich hierunter jenes verbirgt, was man bisher als GV102/GT102 bzw. GV104/GT104 bezeichnet hatte.

| GV104 | GV102 | GV100 | |

|---|---|---|---|

| Chip | geschätzt ~11,5 Mrd. Transistoren auf ~500mm² Chipfläche in der 12nm-Fertigung von TSMC | 18,6 Mrd. Transistoren auf 754mm² Chipfläche in der 12nm-Fertigung von TSMC | 21,1 Mrd. Transistoren auf 815mm² Chipfläche in der 12nm-Fertigung von TSMC |

| Raster-Engines | whrschl. 4 | whrschl. 6 | 6 |

| Shader-Einheiten | 3072 Shader-Einheiten | 4608 Shader-Einheiten | 5376 Shader-Einheiten |

| FP32-Rechenleistung | geschätzt ~11 TFlops | 16 TFlops | 14,8 TFlops |

| TMUs | whrschl. 192 | whrschl. 288 | 336 |

| ROPs | whrschl. 64 | whrschl. 96 | 128 |

| Tensor-Cores | 384 | 576 | 640 |

| RT-Core | 6 GigaRays/sec | 10 GigaRays/sec | - |

| Speicherinterface | 256 Bit GDDR6 | 384 Bit GDDR6 | 4096 Bit HBM2 |

| Speicherausbau | 8/16/32 GB GDDR6 | 12/24/48 GB GDDR6 | 16/32 GB HBM2 |

| Grafikkarten | Quadro RTX 5000 | Quadro RTX 6000 & 8000 | Titan XV, Quadro GV100 & Tesla V100 |

| Release | Herbst 2018 | Herbst 2018 | Q3/2017 |

| Pascal-Vorgänger | GP104: 2560 Shader-Einheiten @ 256 Bit GDDR5X, 8.9 TFlops | GP102: 3840 Shader-Einheiten @ 384 Bit GDDR5X, 12.1 TFlops | GP100: 3840 Shader-Einheiten @ 4096 Bit HBM2, 10.9 TFlops |

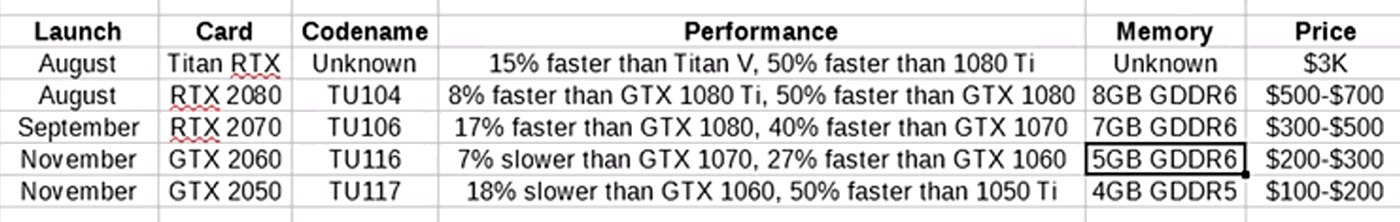

Gerüchteküche: Eine komplette GeForce-20-Serie tritt angeblich zwischen August und November 2018 an

Vielbeachtet werden derzeit die Aussagen von AdoredTV auf YouTube (via Videocardz), welche (angeblich) ziemlich viel Turing-Informationsmaterial haben wollen, dies sogar (angeblich) von einer Quelle direkt bei nVidia. Danach kommt es wohl tatsächlich zu einer "GeForce 20" Serie auf Basis von "Turing", ein Teil der Grafikkarten soll sich dann "GeForce RTX" anstatt "GeForce GTX" (als Hinweis auf deren RayTracing-Eignung) nennen. Die vorgelegten Codenamen der einzelnen Grafikchips klingen mit "TU104", "TU106", "TU116" und "TU117" allerdings schon etwas seltsam – noch dazu, wo GeForce RTX 2070 & 2080 auf (angeblich) unterschiedlichen Grafikchip basieren sollen. Dies ist bei nVidia in den letzten Jahren jedoch niemals derart passiert und ergibt auch ziemlich wenig Sinn. Als weitgehend unrealistisch sehen aus unserer Warte dann vor allem die (angeblichen) Speicherbestückungen aus, denn 5 GB und 7 GB sind vergleichsweise schwer zu realisieren, wenn man nur 1GByte-Speicherchips zur Verfügung hat.

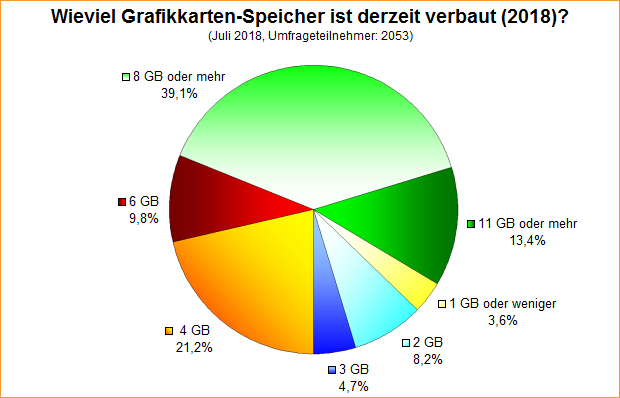

Umfrage-Auswertung: Wieviel Grafikkarten-Speicher ist derzeit verbaut (2018)?

Mittels einer Umfrage von Mitte Juli wurde die derzeitig verbaute Menge an Grafikkartenspeicher abgefragt – in Wiederholung einer 2014er Umfrage, wobei sich seitdem bekannterweise einiges auf diesem Gebiet getan hat. So gibt es Grafikkartenspeichergrößen unterhalb 2 GB gar nicht mehr im aktuellen Grafikkarten-Portfolio sowie haben die kleinen Grafikkartenspeichergrößen generell stark abgenommen, während es an der Spitze eine neue Maximalgröße bei 11 bzw. 12 GB Grafikkartenspeicher gibt. Dies führt dazu, das während im Jahr 2014 Grafikkartenspeichergrößen von 1-3 GB dominierten, derzeit in der Mehrheit eher 6-11 GB Grafikkartenspeicher benutzt werden, mit zudem einer klaren Häufung bei gleich 8 GB Grafikkartenspeicher – eine geradezu extreme Entwicklung innerhalb von nur vier Jahren.