Hauptlinks

Suchen

Grafik-Features

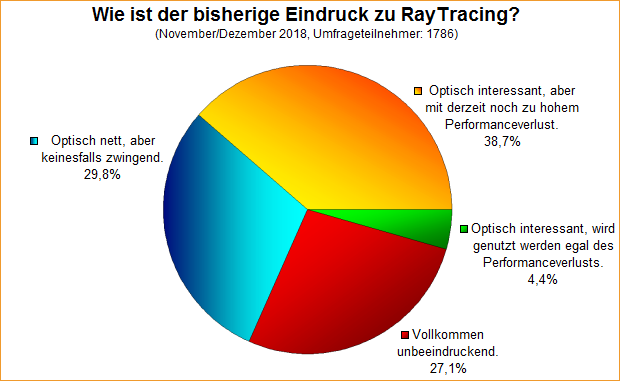

Umfrage-Auswertung: Wie ist der bisherige Eindruck zu RayTracing?

Mit einer Umfrage von Ende November wurde nach dem ersten Eindruck zu RayTracing gefragt, was sich primär auf das erste öffentlich einsichtbare Beispiel in Form von Battlefield V bezieht. Der Umfrage-Zeitpunkt war dabei noch vor dem letzten Patch zu Battlefield V, welcher die RayTracing-Performance sehr erheblich steigerte – insofern könnte derzeit die Bewertung auch schon wieder leicht besser ausfallen. Dies gilt insbesondere für die mit 38,7% größte Stimmengruppe, welche den Optik-Effekt von RayTracing durchaus anerkennen, den hiermit einhergehenden Performance-Verlust allerdings (auf derzeitiger Hardware) noch für zu groß halten. In dieser Gruppe dürfte es sicherlich angesichts der neuen Benchmark-Ergebnisse einige inzwischen positiver gegenüber RayTracing gestimmte Nutzer geben.

RayTracing unter Battlefield V: Aller Anfang ist schwer

Wie angekündigt und auch im Sinne der (noch) aktuellen Umfrage, wollen wir hiermit noch einmal zurückkommen zum (hervorragenden) RayTracing-Blindtest, welcher mittels des YouTube-Videos von Optimum Tech (ab Video-Zeitpunkt 1:17) absolviert werden kann (und sollte). Hiermit bietet sich eine gute Gelegenheit, den Stand des allerersten RayTracing-Versuchs sowohl für die Nachwelt zu dokumentieren, als auch natürlich als aktuelle Diskussions-Grundlage zu verwenden. Schließlich muß man anhand dieser Bilder klar sagen, das RayTracing im realen Gameplay von Battlefield V kaum einen beachtbaren Effekt hervorruft – im Gegensatz zu den Werbebildern seitens des Spielepublishers und von nVidia. Dies zeigt sich schon allein daran, das gemäß der Kommentare zum YouTube-Video sehr viele Anwender die RayTracing-Funktionalität regelrecht im falschen Bildteil vermutet haben: Aktives RayTracing ist jeweils links zu sehen auf (allen) diesen Vergleichsbildern unter Battlefield V (allesamt mit Copyright allein von Optimum Tech).

AMD wird definitiv auf RayTracing reagieren

Das japanische 4Gamer (via TechPowerUp) konnte in einem Artikel zu Vega 20 aus AMDs David Wang auch eine Aussage zu RayTracing auf AMD-Hardware herauslocken: Danach wird es (logischerweise) eine Antwort bzw. vergleichbare Technologie auch von AMD geben – wobei AMD ja letztlich nichts anderes als DXR in DirectX 12 unterstützen muß, dafür muß das Rad nicht neu erfunden werden. Die Frage ist eher, wann entsprechende AMD-Grafikchips mit RayTracing-Funktionalität (in Hardware) erscheinen – Software-Lösungen sind zwar denkbar (laufend über die Shader-Einheiten), reichen aber maximal zu Demonstrationszwecken und kaum für die Spielepraxis. Hierzu gab AMD die indirekte Angabe ab, das man eine größere Verbreitung von RayTracing-Spielen erst zu einem Zeitpunkt erwartet, wo RayTracing in Hardware von Grafikkarten aller Preisbereiche beherrscht wird – sprich von LowCost-Lösungen bis zu Enthusiasten-Boliden.

AMD wird definitiv auf DirectX RayTracing reagieren.

Es wird keine große Verbreitung von RayTracing-Spielen stattfinden, bevor nicht RayTracing-GPUs für alle Segmente vorhanden sind – vom LowEnd zum HighEnd.

Quelle: AMDs David Wang gegenüber 4Gamers vom 6. November 2018 (freie Übersetzung anhand der automatisierten Übersetzungen ins Englische und ins Deutsche)

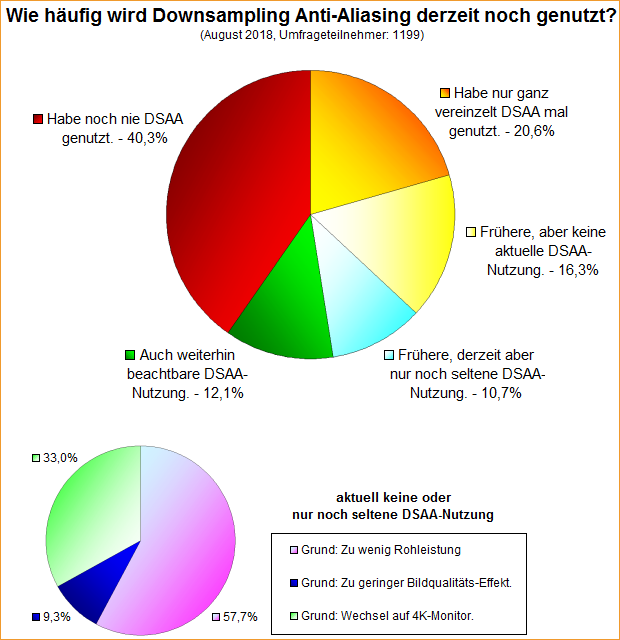

Umfrage-Auswertung: Wie häufig wird Downsampling Anti-Aliasing derzeit noch genutzt?

Eine Umfrage von Mitte August ging der Frage nach, wie breit Downsampling Anti-Aliasing derzeit überhaupt noch genutzt wird. Vor einigen Jahren waren AMDs VSR bzw. nVidias DSR Anti-Aliasing noch heiße Eisen, heuer aber hört man kaum noch etwas neues hierzu, wird auch kaum noch in diese Richtung hin getestet. Dies bestätigt sich allerdings durch die aktuelle Nutzer-Anzahl, welche mit 12,1% beachtbaren und 10,7% seltenen Nutzern (zusammengezählt 22,8%) nicht gerade hoch ausfällt – in jedem Fall weniger als vor zwei Jahren, wo die Nutzer-Anzahl kumulativ schon 37,3% erreichte. Letztlich sind somit im Laufe der Zeit sogar beachtbar Nutzer von dieser Kantenglättungs-Variante abgewandert, anstatt vielmehr neue Nutzer hinzugekommen wären.

Erste Detail-Berichte zu nVidias Turing-Architektur erschienen

Wir erwartet, sind Freitag Nachmittag die Architektur-Artikel zu nVidia Turing-Architektur erschienen (untenstehend verlinkt). Selbige erklären die Feinheiten jener neuen Grafikchip-Architektur, welche sich eben nicht nur auf das Thema RayTracing beschränken, sondern vor allem auch beim konventionellen Grafikrendering erhebliche Vorteile bieten – siehe schon die neuen Shader-Cluster bei Turing. Zu selbigen klären sich nun auch einige noch offene Fragen: So lassen sich die extra Integer-Einheiten zeitgleich mit den konventionellen FP32-Einheiten nutzen, was für einen erheblichen Performance-Boost sorgen soll. Denn laut nVidia kommen in modernen Spielen auf 100 FP32-Berechnungen auch schon ca. 36 Integer-Berechnungen (bei Battlefield 1 dagegen sogar 100:50) – welche bisher in den FP32-Einheiten früherer Grafikchip-Architekturen mit ausgeführt wurden, dafür aber die jeweiligen Shader-Einheiten für andere FP32-Berechnungen blockiert haben. Nun kann alles nebeneinanderher ausgeführt werden, blockieren die verschiedenen Rechenoperationen sich also nicht mehr gegenseitig. So gesehen haben die Shader-Cluster von Turing dann also doch wieder 128 Ausführungseinheiten – die stärker genutzten 64x FP32- sowie die etwas weniger genutzten 64x INT32-Einheiten (Nutzungsverhältnis grob 74:26%).

Die neue Kantenglättung von nVidias Turing: Deep Learning Super Sample (DLSS)

Bei der Turing-Generation bringt nVidia mittels "Deep Learning Super Sample" (DLSS) eine neue Kantenglättung daher, welche im Gegensatz zum früher schon erwähnten "Adaptive Temporal Antialiasing" bereits spruchreif ist und seiten nVidia massiv bei den Turing-Grafikkarten promoted wird. Als Post-Processing-Verfahren kann DLSS grundsätzlich von jedem Spiel benutzt werden, das Spiel muß aber dennoch darauf vorbereitet sein, es handelt sich also nicht um ein Treiber-seitig aktivierbares Kantenglättungs-Verfahren. Zwar wird es tiefergehende Details samt Bildqualitäts-Vergleichen zu DLSS sicherlich erst mit dem kommenden Turing-Launch (14. September 2018) geben, aber dennoch kann man auf Basis der bisherigen nVidia-Informationen sowie Berichten der Gamescom-Fachbesucher dennoch schon ein gewisses Bild zu DLSS zeichnen: Hierunter verbirgt sich eine adaptive Kantenglättung in einem bislang noch nicht genauer erläuterten technischen Verfahren, deren Clou primär in einem vorhergehenden Mustererkennungs-Training der zu glättenden Kanten liegt. DLSS weiss also vor der eigentlichen Kantenglättung bereits, was Kante und was nur Farbübergang ist – und ist demzufolge in der Lage, seine Kantenglättung gezielt nur auf den reinen Kanten anzusetzen.

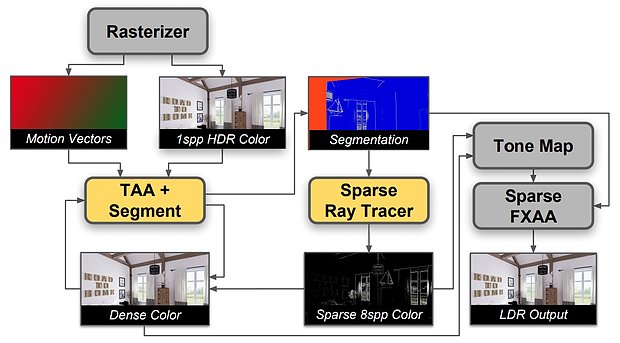

nVidia stellt "Adaptive Temporal Antialiasing" als erste RayTracing-Anwendung vor

Grafikchip-Entwickler nVidia hat mittels "Adaptive Temporal Antialiasing" (ATAA) eine neue Art von Kantenglättung vorgestellt, welche für ihr Wirken unter anderem Hardware-basiertes RayTracing benutzt. Grundsätzlich handelt es sich bei "Adaptive Temporal Antialiasing" um eine Erweiterung des bekannten "Temporal Antialiasing" (TAA, nicht zu verwechseln mit "Temporal Approximate Anti Aliasing" aka TXAA), welches den Postprocessing-Weichzeichner FXAA mit einer zeitlichen (temporalen) Komponente vermischt, um besonders in Bewegung gute Ergebnisse erzielen zu können. Nichtsdestotrotz ist bei TAA weiterhin aufgrund der FXAA-Basis ein nicht unerheblicher Weichzeichner-Effekt zu sehen, welcher zudem besonders feine Details dann auch gleich ganz verschwinden lassen kann. Mittels ATAA will man nunmehr basierend auf TAA gewisse Bildteile durch ein adaptives RayTracing-Verfahren besonders exakt glätten, um gerade dieser Problematik der Vernichtung besonders feiner Details entgegenzuwirken.

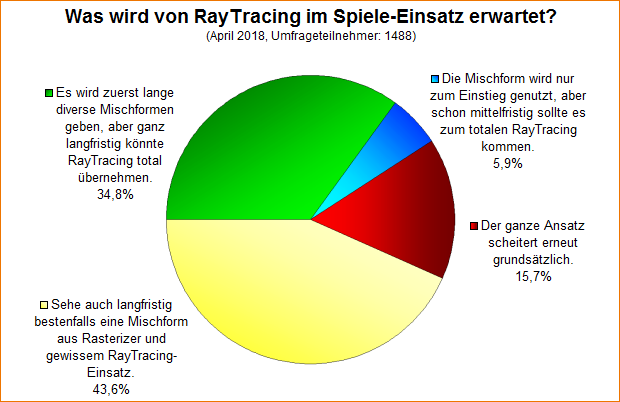

Umfrage-Auswertung: Was wird von RayTracing im Spiele-Einsatz erwartet?

Bei einer Umfrage von Anfang April ging es um die Frage, was man von RayTracing im Spiele-Einsatz erwartet – ein Scheitern, einen Durchmarsch oder aber Mischformen aus Rasterizer- und RayTracing-Grafik. Das herausgekommende Umfrageergebnis ist dabei vergleichsweise eindeutig: Die Mischformen erreichten mit 78,4% Stimmenanteil die klare Mehrheit, während ein Scheitern nur von 15,7% der Umfrageteilnehmer gesehen wird, ein Durchmarsch hin zu totaler RayTracing-Dominanz schon in mittelfristiger Zukunft dagegen sogar nur von 5,9% der Umfrageteilnehmer. Keine dieser Antwort-Optionen ist natürlich in irgendeiner Form "falsch" – es ging bei der Umfrage einfach nur darum, die aktuelle Gefühlslage zu diesem Thema abzubilden.

AMDs HBCC-Feature kann (in der richtigen Situation) bis zu 70% Mehrperformance bringen

In unserem Forum hat man sich in zwei (schon etwas zurückliegenden) Postings (No.1 & No.2) mit den Performance-Auswirkungen von AMDs HBCC-Feature der Vega-Grafikkarten in Extremfällen beschäftigt. Das Feature wurde von AMD vor und während des Vega-Launches einigermaßen in den Vordergrund gestellt, hat sich allerdings bislang als bei weitem nicht so praxiswirksam erwiesen, wie gedacht – teilweise aber auch nur, weil die passenden Testszenen fehlten bzw. nicht offensichtlich vor der Nase lagen. Selbige wurden nun aber unter Wolfenstein II: The New Colossus gefunden: In zwei Szenen kann das HBCC-Feature seine erhebliche Schlagkraft mit Performancezugewinnen von 68-70% sehr eindrucksvoll unter Beweis stellen. In beiden Fällen halfen allerdings auch extreme Auflösungen samt extremer Settings der ganzen Sache auf der Sprünge – sprich, die Vega-Grafikkarte musste vorsätzlich in eine Situation gebracht werden, wo deren 8 GB Grafikkartenspeicher wirklich nicht mehr ausreicht.

| HBCC=off | HBCC=on (12 GB) | Differenz | |

|---|---|---|---|

| Wolfenstein II @ 4K (Streaming=Extreme), Szene 1 | 41 fps | 69 fps | +68% |

| Wolfenstein II @ 5K (Streaming=Extreme), Szene 2 | 30 fps | 51 fps | +70% |

| basierend auf Benchmarks aus dem 3DCenter-Forum: No.1 & No.2; mit Dank an Foren-User 'dargo' | |||

RayTracing wird zukünftig Teil von DirectX 12

Golem, Heise und PC Games Hardware berichten über die neuen Microsoft-Schnittstelle "DirectX Raytracing" (DXR), welche Microsoft auf der GDC 2018 in San Francisco angekündigt hat und demnächst in DirectX 12 integrieren will. Hierbei handelt es sich um eine Möglichkeit, einzelne Grafikelemente wie Beleuchtung, Schatten und Umgebungsverdeckung mittels RayTracing zu lösen, am allgemeinen Rasterizer-Ansatz heutiger 3D-Grafik wird also (vorerst) noch nicht gerüttelt. Allerdings erfordern wohl auch nur einzelne RayTracing-Elemente schon eine diesbezügliche Beachtung bzw. Vorsichtnahme bei der zugrundeliegenden Rasterizer-Grafik, kann selbiges also nicht einfach so bei bestehenden Spieletitel übergestülpt werden. Erreicht werden soll letztendlich eine realistischer Beleuchtung, welche dann eben nicht mehr auf einzelnen Lichtquellen, sondern "echten" Lichtstrahlen basiert – mit allerdings dementsprechendem Rechenaufwand.

RayTracing-Demo mittels der Northlight-Engine von Remedy |

RayTracing-Demo "Pica Pica" mittels der Halcyon-Engine von EA |