Hauptlinks

Suchen

RayTracing

Neuer Artikel: Launch-Analyse nVidia GeForce RTX 4060

Mit der GeForce RTX 4060 bringt nVidia seine eigentliche Mainstream-Lösung innerhalb der Ada-Lovelace-Generation an den Start. Jene Grafikkarte verwendet erstmals im Desktop-Segment den AD107-Chip, den kleinsten Grafikchip jener Hardware-Generation – was allerdings nicht gerade große Performance-Sprünge verheißt. Mit zudem wiederum nur 8 GB Grafikkartenspeicher ausgestattet, geht die GeForce RTX 4060 zudem in dieselbe VRAM-Problematik wie zuvor schon GeForce RTX 4060 Ti & Radeon RX 7600. Nichtsdestotrotz müssen natürlich die Launchreviews ausgewertet werden, um auf Basis von deren kumulierten Ergebnissen eine solide begründbare Performance-Einordnung der GeForce RTX 4060 im großen Performance-Bild vornehmen zu können ... zum Artikel.

| Gen. & Speicher | FHD-Perf. | Real-Verbr. | Listenpreis | Straßenpreis | |

|---|---|---|---|---|---|

| GeForce RTX 3060 Ti GDDR6 | Ampere, 8 GB | 109,5% | 202W | $399 / 439€ | 319-350 Euro |

| GeForce RTX 4060 | Ada Lovelace, 8GB | 100% | 124W | $299 / 329€ | 305-340 Euro |

| Radeon RX 7600 | RDNA3, 8 GB | 97,8% | 160W | $269 / 299€ | 276-320 Euro |

| Radeon RX 6650 XT | RDNA2, 8 GB | 93,6% | 177W | $399 / 449€ | 241-280 Euro |

| GeForce RTX 3060 12GB | Ampere, 12 GB | 83,5% | 172W | $329 / 329€ | 289-340 Euro |

| A750 | Alchemist, 8 GB | 82,9% | 208W | $249 | 249-270 Euro |

Neuer Artikel: Launch-Analyse GeForce RTX 4060 Ti & Radeon RX 7600

Mittels Radeon RX 7600 und GeForce RTX 4060 Ti dehnen AMD & nVidia die aktuelle Ada/RDNA3-Generation erstmals auf das Mainstream-Segment aus. Die jeweiligen Ansätze sind hierbei grundverschieden: Die GeForce RTX 4060 Ti will fast ins Midrange-Segment hineingehen, ist zumindest die klar schnellste Mainstream-Lösung mit dementsprechend hohen Preispunkt. Die Radeon RX 7600 stellt eher den absoluten Gegenentwurf dar, hierbei ging es zuerst um einen günstigstmöglichen Preispunkt, welcher dann auch deutlich niedriger als bei der nVidia-Karte ausfällt. Trotzdem werden nachfolgend beide Grafikkarten zusammen betrachtet: Zum einen kamen jene nur einen Tag voneinander getrennt heraus, herrscht somit zwischen den entsprechenden Testberichten durchgehend Benchmark-Kontinuität. Zum anderen sind es eben beiderseits "nur" 8-GB-Grafikkarten, und demzufolge (heutzutage) in ihren Wirkmöglichkeiten beschränkt. Was beide neuen Mainstream-Grafikkarten eint wie trennt und wie sich jene im großen Performance-Bild einordnen lassen, soll die nachfolgende Launch-Analyse beleuchten ... zum Artikel.

| 6650XT | 7600 | 3060Ti | 3070 | 4060Ti | |

|---|---|---|---|---|---|

| gemittelte FHD Raster-Perf. | 75,6% | 79,9% | 89,6% | 101,1% | 100% |

| gemittelte RT-Perf. (FHD) | 55,0% | 60,1% | 88,2% | 100,3% | 100% |

| Straßenpreis (ab) | 252€ | 288€ | 329€ | 439€ | 428€ |

| Perf/Preis: Raster @ FHD | 128% | 119% | 117% | 99% | 100% |

| Perf/Preis: RT @ FHD | 93% | 89% | 115% | 98% | 100% |

Neuer Artikel: Launch-Analyse nVidia GeForce RTX 4070

Mit der vierten Grafikkarte der RTX40-Serie bringt nVidia erstmals eine Midrange-Lösung innerhalb der Ada/RDNA3-Generation heraus. Die GeForce RTX 4070 basiert auf einer starken Abspeckung des AD104-Chips der GeForce RTX 4070 Ti, behält aber – durchaus in die Zeit passend – die Speichermenge von 12 GB VRAM bei. Laut nVidia soll mit der GeForce RTX 4070 non-Ti die Performance-Klasse der früheren GeForce RTX 3080 10GB geboten werden, zuzüglich dann natürlich Mehrspeicher und den neueren Features der Ada-Lovelace-Architektur. Ob diese Performance-Prognose passt und welches Performance/Preis-Verhältnis damit erreicht werden kann, soll mit dieser Launch-Analyse unter Verwendung der Benchmark-Werte von 17 Launch-Reviews herausgearbeitet werden ... zum Artikel.

nVidias 8-GB-Grafikkarten tendieren nunmehr deutlich in Richtung VRAM-Mangel

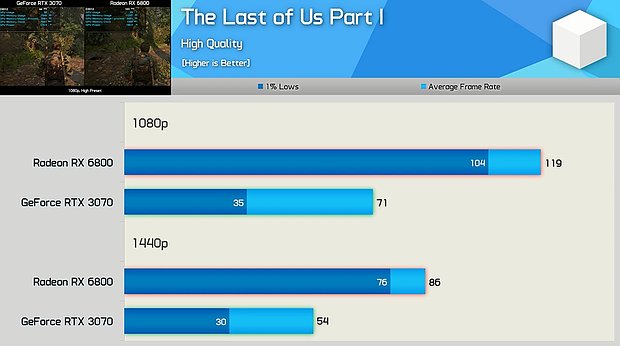

Für viel Beachtung sorgt derzeit ein YouTube-Video seitens Hardware Unboxed, welche sich den alten Vergleich von GeForce RTX 3070 (8GB) gegen Radeon RX 6800 (16GB) neu unter dem Blickwinkel der VRAM-Problematik bei jener nVidia-Karte angesehen haben. Die AMD-Karte geht mit einem natürlichen Vorteil in diese Benchmarks, ist gemäß früherer Messungen unter der WQHD-Auflösung im Schnitt +11% schneller (wobei sich das Verhältnis unter RayTracing bekannterweise umkehrt). Relevant sind also nur beachtbare Abweichungen hiervon – welche sehr wohl zu finden waren, wenngleich nicht unter allen Spiele-Titeln. Ein markantes Beispiel ergibt sich wieder unter "The Last of Us, Part 1", welches selbst unter dem zweithöchsten Bildqualitäts-Preset "High" einen heftigen Vorteil für die AMD-Karte aufzeigt. Jener ist um so deutlicher bei den Minimum-Frameraten, was auf die VRAM-Problematik als Auslöser hindeutet.

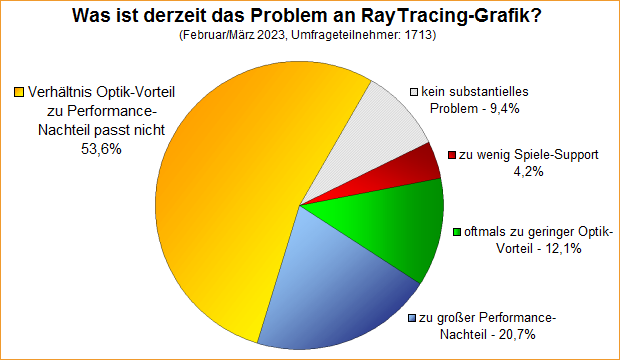

Umfrage-Auswertung: Was ist derzeit das Problem an RayTracing-Grafik?

Mittels einer Umfrage von Mitte Februar wurde abgefragt, wo derzeit das Problem an RayTracing-Grafik zu sehen ist – in Nachfolge und als Ergänzung einer Umfrage zum Einfluß von RayTracing auf die Kaufentscheidung. Die neuere Umfrage ergab ein ähnlich klares Ergebnis wie die ältere: Mit 53,6% sogar die absolute Mehrheit der Umfrage-Teilnehmer sieht das Verhältnis von Optik-Vorteil zu Performance-Nachteil bei RayTracing als derzeit größtes Problem des "neuen" Grafik-Features. Faktisch wird den Spiele-Entwicklern hiermit sogar eine Richtschnur vorgegeben, wie man RayTracing zukünftig besser einbinden kann.

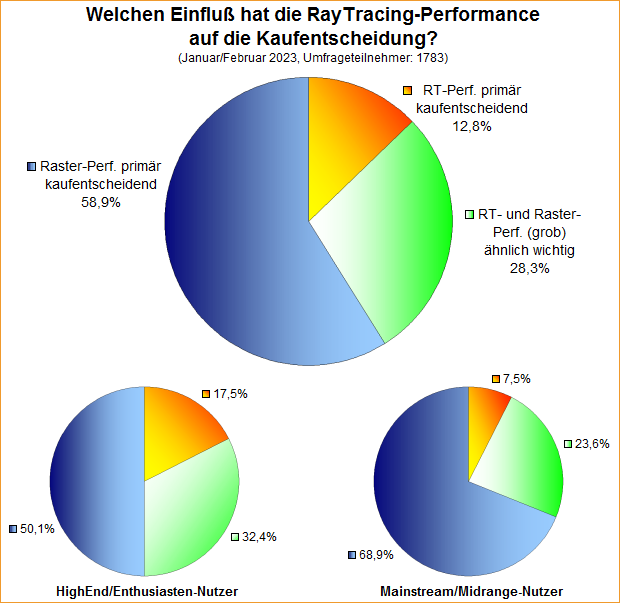

Umfrage-Auswertung: Welchen Einfluß hat die RayTracing-Performance auf die Kaufentscheidung?

Mittels einer Umfrage von Ende Januar wurde nach dem Einfluß der RayTracing-Performance auf die Grafikkarten-Kaufentscheidung gefragt, zuzüglich einer inhaltlich identischen Umfrage auf Twitter. Beide Umfragen kamen grob beim selben Ergebnis heraus: Jeweils etwas mehr als ein Zehntel stimmte dafür, dass die RayTracing-Performance tatsächlich (vorrangig) kaufentscheidend sei. Bei diesen Anwendern sollte somit tatsächlich RayTracing als Normalzustand zum Einsatz kommen bzw. geht man von der Überlegung aus, dass eventuelle Unterschiede bei der Raster-Performance auf einem viel höheren Frameraten-Niveau stattfinden als unter RayTracing – womit dessen Performance-Wertung höher zu gewichten wäre.

Neuer Artikel: Launch-Analyse nVidia GeForce RTX 4070 Ti

Mit der GeForce RTX 4070 Ti bringt nVidia die dritte RTX40-Grafiklösung, basierend auf dem dritten Ada-Lovelace-Grafikchip und erstmals bei nVidias neuer Grafikkarten-Generation in den dreistelligen Preisbereich herabreichend. Prinzipiell handelt es sich hierbei um eine umbenannten "GeForce RTX 4080 12GB" zum leicht abgesenkten Preis. Letzteres war wohl auch notwendig, um wenigstens einen gewissen Performance/Preis-Vorteil gegenüber der von den Grafikkarten-Käufern weitgehend verschmähten GeForce RTX 4080 (16GB) zu erreichen. Ob dies ausreichend ist bzw. wo sich die GeForce RTX 4070 Ti im Performance-Gesamtbild einordnen kann, soll nachfolgend auf Basis der Performance-Werte der Launch-Reviews ermittelt werden ... zum Artikel.

| RTX 3090 Ti | RTX 4070 Ti | RX 7900 XT | |

|---|---|---|---|

| Ampere, 24GB | Ada, 12GB | RDNA3, 20GB | |

| Raster/4K-Performance | +7,6% | 100% | +11,0% |

| Raster/WQHD-Performance | ±0 | 100% | +8,4% |

| Raster/FullHD-Performance | –3,4% | 100% | +5,7% |

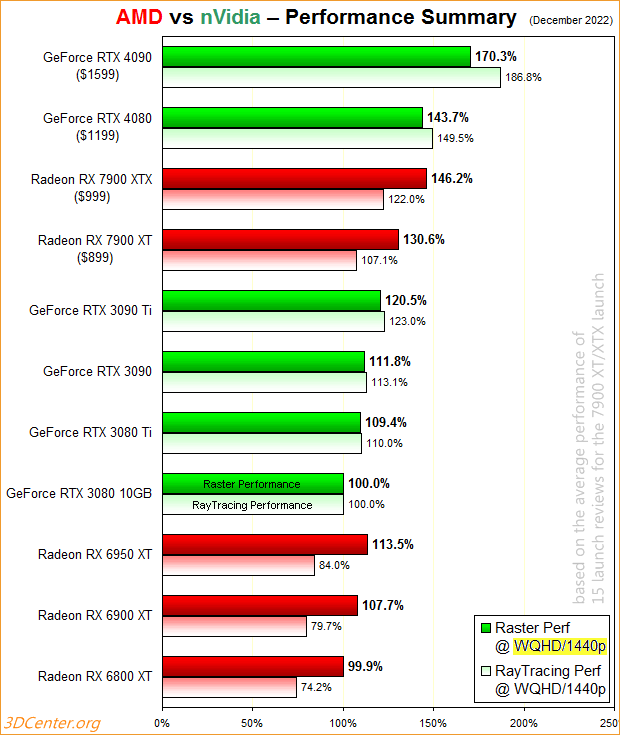

Neuer Artikel: Launch-Analyse AMD Radeon RX 7900 XT & XTX

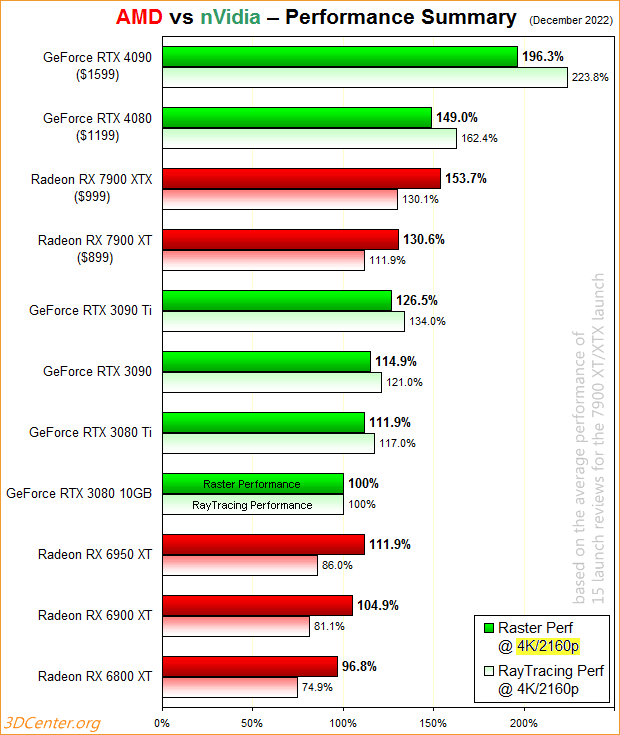

Mit dem Navi-31-Chip und den darauf basierenden Radeon RX 7900 XT & XTX Grafikkarten startet nun auch AMD seine neue Grafikkarten-Generation, im Wettstreit mit nVidias GeForce RTX 40 Serie auf Basis der Ada-Lovelace-Chips. Die von AMD hierfür angesetzte Preislage von 899 bzw. 999 Dollar deutet dabei schon an, dass man sich mitnichten mit nVidias größten RTX40-Beschleunigern messen kann, sondern etwas kleinere Brötchen backt. Trotzdem ist natürlich zu ermitteln, wie die beiden neuen AMD-Grafikkarten sowohl gegenüber GeForce RTX 4080 & 4090 als auch der vorherigen Grafikkarten-Generation von AMD & nVidia bestehen können. Die nachfolgende Launch-Analyse wird somit auf Basis der von den Launch-Reviews aufgestellten Benchmarks und Meßwerte eine Einschätzung zur gemittelten Performance, Stromverbrauch, Energieeffizienz, Generations-Gewinn und Preis/Leistungs-Verhältnis abgeben ... zum Artikel.

Neuer Artikel: Launch-Analyse nVidia GeForce RTX 4090

Mit der GeForce RTX 4090 läutet nVidia eine neue Grafikchip- und damit Grafikkarten-Generation ein: Architektur-seitig kommt hierbei erstmals die "Ada Lovelace" Architektur in Form des "AD102"-Grafikchips zum Einsatz, welche im Verkauf dann in der "GeForce RTX 40" Serie mit der GeForce RTX 4090 als erster Grafikkarte hieraus resultiert. Versprochen wurde seitens nVidia ein erheblicher bis drastischer Performance-Sprung, letzterer allerdings nur zu erzielen unter Einsatz von "Hilfsmitteln" wie dem neuen Upscaler DLSS3. Nach den Launchreviews zur Founders Edition am 11. Oktober sowie den Launchreviews zu den Herstellerdesign samt dem gemeinsamen Marktstart am 12. Oktober soll die nachfolgende Launch-Analyse die (massig) angefallenen Benchmark-Werte zur neuen nVidia-Karte sammeln und in Form bringen, so dass sich ein belastbares Performance-Bild über die neue Situation im Enthusiasten-Segment ergibt ... zum Artikel.

| Gen. & Speicher | FHD-Index | 4K-Index | Real-Verbr. | Listenpreis | Straßenpreis | |

|---|---|---|---|---|---|---|

| GeForce RTX 4090 | Ada, 24GB | 2760% | 640% | 418W | $1599 / 1949€ | 2300-2650 Euro |

| GeForce RTX 3090 Ti | Ampere, 24GB | 2200% | 410% | 462W | $1999 / 2249€ | 1200-1300 Euro |

| GeForce RTX 3090 | Ampere, 24GB | 2100% | 376% | 359W | $1499 / 1649€ | 1080-1200 Euro |

| Radeon RX 6950 XT | RDNA2, 16GB | 2230% | 368% | 348W | $1099 / 1239€ | 900-1000 Euro |

Neuer Artikel: Launch-Analyse Intel Arc A750 & A770

Mit gut einem Jahr Verspätung gegenüber ursprünglichen Planungen und sowie einem halben Jahr Verspätung gegenüber der ersten offiziellen Ankündigung bringt Intel am kommenden 12. Oktober endlich die ersten Grafikkarten auf Basis seines großen Alchemist-Chips "ACM-G10" in den Markt – Arc A750 und A770. Mit dem späten Termin kommt Intel nicht mehr rechtzeitig, um von der seinerzeitigen Chipkrise profitieren zu können. Vielmehr muß sich nun gegenüber den AMD- und nVidia-Angeboten des Mainstream- und Midrange-Segments beweisen, welche sich gerade in der letzten Zeit wieder auf Preislagen um den Listenpreis herum eingefunden haben. Als gewissen Vorteil für Intel hat nVidia seine NextGen-Grafikkarten preislich derart hoch angesetzt, dass aus dieser Warte derzeit kein Problem für Intel droht. Auf Basis der bereits am 5. Oktober veröffentlichten Launch-Reviews soll nachfolgend dargelegt werden, wo sich Arc A750 & A770 im Mittel der aufgestellten Benchmarks im großen Performance-Bild einordnen lassen ... zum Artikel.

| Gen. & Speicher | FHD-Index | 4K-Index | Real-Verbr. | Liste | Straßenpreis | |

|---|---|---|---|---|---|---|

| Radeon RX 6600 XT | RDNA2, 8GB | 1260% | 159% | 159W | $379 | 380-440 Euro |

| Arc A770 "LE" | Alchemist, 16GB | 1190% | 195% | 223W | $349 | erwartbar für ~420€ |

| GeForce RTX 3060 | Ampere, 12GB | 1130% | 165% | 172W | 329$ | 380-420 Euro |

| Arc A750 | Alchemist, 8GB | 1100% | 171% | 208W | $289 | erwartbar für ~350€ |

| Radeon RX 6600 | RDNA2, 8GB | 1090% | 134% | 131W | $329 | 290-330 Euro |