Hauptlinks

Suchen

RayTracing

Neuer Artikel: Launch-Analyse nVidia GeForce RTX 3090

Mit der GeForce RTX 3090 hat nVidia an diesem Donnerstag die zweite Grafikkarte der Ampere-Generation in den Ring geschickt. Während die GeForce RTX 3080 von vorangegangener Woche das neue HighEnd-Flaggschiff darstellt, ist die GeForce RTX 3090 als reine Enthusiasten-Lösung konzipiert – sehr gut anhand der vergleichsweise geringen Mehrperformance für einen geradezu extremen Preisaufschlag zu sehen. Bei dieser Karte geht es darum, denjenigen "das Allerbeste" an die Hand zu geben, welche nichts darunter akzeptieren wollen, Vernunft oder gar das Preis/Leistungs-Verhältnis spielen hierbei keine bedeutsame Rolle. Mittels der nachfolgenden Launch-Analyse soll wiederum zusammengetragen werden, was die Launchreviews zur GeForce RTX 3090 an relevanten Informationen aufgeboten haben, mit Konzentration auf die übliche Werte-Verdichtung zu den Punkten Performance, Stromverbrauch, Energieeffizienz sowie (Sakrileg) des Preis/Leistungs-Verhältnisses ... zum Artikel.

| Mehrleistung der GeForce RTX 3090 | UltraHD | RT/4K | Energieeff. | Preis/Leist. |

|---|---|---|---|---|

| 3090 vs. GeForce RTX 3080 | +12% | +14% | +2% | −48% |

| 3090 vs. GeForce RTX 2080 Ti | +47% | +58% | +12% | +18% |

| normiert auf FE/Referenz-Modelle; Energieeffizienz und Preis/Leistungs-Verhältnis bezogen auf die UltraHD/4K-Performance | ||||

Neuer Artikel: Launch-Analyse nVidia GeForce RTX 3080

Mit dem Launch der GeForce RTX 3080 gibt nVidia den Startschuß zu einer neuen Grafikkarten-Generation basierend auf einer neuen Technik-Grundlage in Form der Ampere-Architektur. Jene soll mal wieder ein ordentliches Performance-Plus ohne dafür allerdings steigende Grafikkarten-Preise bieten – ein Punkt, welcher bei der vorhergehenden Turing-Generation (anfänglich) nicht gegeben war und welchen nVidia mittels der Ampere-Generation korrigieren möchte. Das Erstlingswerk "GeForce RTX 3080" beerbt dabei die vorherigen GeForce RTX 2080 & 2080 Super Karten zum selben Preispunkt, soll aber dennoch klar schneller als die (teurere) GeForce RTX 2080 Ti herauskommen. Mittels der nachfolgenden Launch-Analyse soll zusammengetragen werden, was die Launchreviews an relevanten Informationen zu bieten haben, mit Konzentration auf die übliche Werte-Verdichtung in den Bereichen Performance und Stromverbrauch ... zum Artikel.

| Speicher | Perf.Index | Verbrauch | Liste | Straßenpreis | |

|---|---|---|---|---|---|

| GeForce RTX 3080 | 10 GB | 324% | 325W | $699 | 790-900 Euro — nVidia-Shop: 699€ |

| GeForce RTX 2080 Ti | 11 GB | 247% | 273W | $1199 | 1050-1300 Euro (Auslauf-Status) |

| GeForce RTX 2080 Super | 8 GB | 205% | 246W | $699 | 600-750 Euro (Auslauf-Status) |

| GeForce RTX 2080 | 8 GB | 192% | 230W | $799 | 600-750 Euro (Auslauf-Status) |

| GeForce RTX 2070 Super | 8 GB | 178% | 215W | $499 | 420-520 Euro |

| Radeon VII | 16 GB | 176% | 274W | $699 | EOL |

| GeForce GTX 1080 Ti | 11 GB | 173% | 239W | $699 | EOL |

| Radeon RX 5700 XT | 8 GB | 163% | 221W | $399 | 360-400 Euro |

| Performance, Verbrauch & Listenpreis = FE/Referenz-Modelle; Straßenpreise = alle verfügbaren Modelle | |||||

Microsoft gibt Termin & Preis seiner NextGen-Konsolen samt den Hardware-Spezifikationen zur Xbox Series S bekannt

Nach der Offenlegung der Hardware-Daten zur größeren Xbox Series X in diesem März hat Microsoft nun auch noch die Hardware-Daten zur kleineren Xbox Series S offiziell gemacht, sowie für beide kommenden NextGen-Konsolen Preise und den Termin bekanntgegeben. Selbige treten zusammen am 10. November für 299 bzw. 499 Dollar an, die Euro-Preise sind dazu (bis auf die obligatorischen ",99 Cent") aufgrund des derzeit günstigen Dollar/Euro-Wechselkurses identisch. Beide Xbox-Konsolen bieten dabei sowohl gleichlautende als auch abweichende Hardware-Teile auf: Die Prozessoren (bis auf eine minimale Taktraten-Differenz) und auch fast alle Features sind identisch (primär fehlt der XBSS das optische Laufwerk der XBSX) – was auch logisch ist, um eine Software-Kompatibilität untereinander garantieren zu können. Die größeren Hardware-Differenzen liegen als erstes bei der NVMe-SSD, welche zwar identisch schnell ist, jedoch bei der XBSS nur halb so groß daherkommt. Dieser Punkt läßt sich nach wie vor über die proprietären Expansion-Cards ausgleichen – hinzukommend wiederum die Möglichkeit eine USB-Festplatte anzuschließen (welche aber wohl keine für diese Konsolen-Generation gedachten Spiele tragen darf).

| Microsoft Xbox Series S | Microsoft Xbox Series X | Sony Playstation 5 | |

|---|---|---|---|

| Prozessor | 8C/16T Zen 2 @ 3.4 GHz (ohne SMT @ 3.6 GHz) | 8C/16T Zen 2 @ 3.6 GHz (ohne SMT @ 3.8 GHz) | 8C/16T Zen 2 @ ≤3.5 GHz |

| Grafiklösung | 20 CU RDNA2 @ 1.565 GHz (4,0 TFlops) | 52 CU RDNA2 @ 1.825 GHz (12,1 TFlops) | 36 CU RDNA2 @ ≤2.23 GHz (≤10,3 TFlops) |

| Speicherinterface | 128 Bit GDDR6 @ 14 Gbps (Ø 190 GB/sec) | 320 Bit GDDR6 @ 14 Gbps (Ø 476 GB/sec) | 256 Bit GDDR6 @ 14 Gbps (448 GB/sec) |

| Speicherausbau | 10 GB GDDR6 (7,5 GB nutzbar) | 16 GB GDDR6 (13,5 GB nutzbar) | 16 GB GDDR6 |

| Festplatte | 512 GB NVMe-SSD @ 2,4 GB/sec (4,8 GB/sec mit Kompression) | 1 TB NVMe-SSD @ 2,4 GB/sec (4,8 GB/sec mit Kompression) | 825 GB NVMe-SSD @ 5,5 GB/sec (8-9 GB/sec mit Kompression) |

| Preislage | 299 Dollar (UVP: 299,99 Euro) | 499 Dollar (UVP: 499,99 Euro) | unbekannt |

| Release | 10. November 2020 | 10. November 2020 | "Holiday Season" 2020 |

Microsoft bringt das DirectX Feature-Level 12_2 mit verpflichtendem Support von RayTracing und Shader Model 6.5

Nach dem erst im März vorgestellten "DirectX 12 Ultimate" bringt Microsoft nunmehr mit dem "Feature-Level 12_2" von DirectX (im eigentlichen dem für 3D-Grafik gedachten Teil "Direct3D") eine weitere Ausbaustufe der DirectX 12 Grafik-API. Dabei beinhaltet DirectX 12_2 (inoffizielle Abkürzung) alle Änderungen von DirectX 12 Ultimate – welche ja sowieso "nur" die vier neuen Hauptfeatures "DirectX RayTracing", "Mesh Shaders", "Variable Rate Shading" (VRS) und "Sampler Feedback" umfasst, sprich vergleichsweise plakative Veränderungen. DirectX 12_2 ist hingegen dann wiederum ein echtes DirectX-Update, sprich zuzüglich zu den Verbesserungen von DirectX 12 Ultimate gibt auch noch noch einen ganzen Strauß an weiteren Detail-Verbesserungen. Am Hardware-Support ändert sich hingegen nichts: Wie auch bei DirectX 12 Ultimate, wird DirectX 12_2 von den Grafik-Architekturen AMD RDNA2, Intel Xe-HPC, nVidia Turing (nur GeForce-20-Modelle) und nVidia Ampere unterstützt.

| Feature-Level 12_0 | Feature-Level 12_1 | Feature-Level 12_2 | |

|---|---|---|---|

| AMD | GCN2, GCN3, GCN4 | GCN5, RDNA1 | RDNA2 |

| Intel | - | - | Xe-HPG |

| nVidia | - | Maxwell 2, Pascal, Turing (GF16) | Turing (GF20), Ampere |

Intel "Xe-HPG" als extra Gaming-Ausführung des Xe-Projekts

Laut Videocardz werden die zu erwartenden Gaming-Grafikkarten des Intel Xe-Projekts nunmehr unter einer eigenen Sub-Architektur namens "Xe-HPG" geführt – in Abgrenzung der bisher bekannten "Xe-LP", "Xe-HP" und "Xe-HPC". Videocardz ordnen das ganze unter "Intel hat bestätigt" ein, leider hat sich dafür aber bislang noch keine andere Quelle finden lassen und Videocardz haben nicht ausgeführt, woher das ganze kommt. In jedem Fall läßt sich somit besser erklären, wie Intel Gaming-Grafikkarten auf Basis der Xe-Architektur erstellen will, denn Xe-LP ist hierfür zu klein angesetzt und Xe-HP/HPC sind mit ihrer Stuktur aus mehreren Tiles (Chiplets) eher ungeeignet für Desktop-Grafikkarten, wo die Ausnutzung der Rechenkraft von mehreren Grafikchips zur Zeit Software-seitig nicht gewährleistet ist.

| Codename | Segment | Fertigung | Technik | RT | Release | |

|---|---|---|---|---|---|---|

| Xe-LP | - | iGPUs & LowCost-Grafik | Intel 10nm | 96 EU | ✗ | Q3/2020 |

| Xe-HPG | - | Gaming-Grafikkarten | angebl. externer Fertiger | unklare Hardware @ GDDR6 | ✓ | 2021 |

| Xe-HP | Arctic Sound | Datacenter-Beschleuniger | Intel 10nm | 1/2/4 Tiles á 512 EU @ HBM2 | ✗ | 2021 |

| Xe-HPC | Ponte Vecchio | Supercomputer-Beschleuniger | Intel 7nm/10nm | bis zu 16 Tiles @ HBM2 | ✗ | Ende 2021 |

Gerüchteküche: Aktuelle Performance-Projektionen sehen nVidias Ampere GA102 und AMDs "Big Navi" grob gleichauf

In einem YouTube-Video breiten Moore's Law Is Dead die neueste Gerüchtelage zu nVidias Ampere und AMDs "Big Navi" aus. Die dabei präsentierten Informationen werden nur zum kleineren Teil belegt, stammen aber augenscheinlich zum gehörigen Teil aus bereits bekannten Leaks/Gerüchten, teilweise werden jedoch auch neue Informationen eingeflochten. Man kann es somit als aktuellen Stand der Gerüchteküche verstehen, weniger denn als singulären Leak. Bezüglich nVidias Ampere werden die maximal 84 Shader-Cluster des GA102-Chips bestätigt, zudem soll ein Testsample mit 12 GB Speicher auf 18 Gbps ausgestattet sein und auf realen Boosttaktraten von ~2.0 GHz laufen, wofür aber auch über 300 Watt Stromverbrauch zu Buche stehen. Ohne TDP-Limit geht es dann auf real anliegende ~2.2 GHz hinauf und werden Stromverbrauch-Werte sogar oberhalb von 400 Watt erreicht.

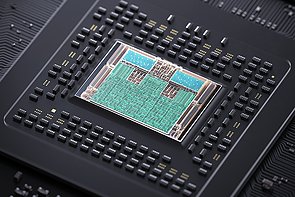

nVidia "Ampere" GA102

voller Chip trägt 5376 Shader-Einheiten

12 GB Speicher auf 18 Gbps (auf diesem Testsample)

Testsample boostet real auf ~2.0 GHz, wobei mehr als 300 Watt Stromverbrauch erreicht werden

realer Boosttakt geht ohne TDP-Limit auf ~2.2 GHz hinauf, dabei werden 400 Watt Stromverbrauch überschritten

40% mehr Rasterization-Performance unter 4K

"solider" IPC-Gewinn gegenüber Turing

RayTracing-Performance soll keinen großen Performance-Verlust mehr produzieren

DLSS 3.0 als weitere Qualitäts-Verbesserung gegenüber DLSS 2.0 (möglicherweise per default aktiviert)

NVCache (nVidias Antwort auf AMDs HBCC)

Tensor Memory Compression (20-40% VRAM-Ersparnis mittels VRAM-Kompression durch Tensor-Kerne)

Launch: September

Quelle: Moore's Law Is Dead @ YouTube am 19. Juli 2020

Gerüchteküche: Gaming-Ampere wieder nur mit ca. +35% Mehrperformance, dafür aber RTX für alle

Von den Twitterern KittyKitties und Kopite7kimi kommt der nächste Schwung an Gerüchten zu nVidias Gaming-Ampere – mit natürlich unsicherer, da nicht genauer ausgeführter Quellenlage. So beschreibt KittyKitties den erwarteten Enthusiasten-Chip "GA102" als denn schwerlich +40% schneller als eine GeForce GTX 2080 Ti – und in jedem Fall soll es unterhalb dieses Performancesprungs liegen, wenn man auf Chip-Basis gegenüber einem vollen TU102-Chip vergleicht (die GeForce RTX 2080 Ti stellt schließlich auch nicht den Vollausbau des TU102-Chips dar). Kopite7kimi schlägt in die gleiche Kerbe und nennt eine "GeForce RTX 3090" (augenscheinlich eine neue Namenswahl anstatt der bisherigen Ti-Modelle) als wahrscheinlich mit "nur" 4992 Shader-Einheiten ausgerüstet. Dies wären gerade einmal +15% mehr Shader-Einheiten als bei der GeForce RXT 2080 Ti, was demzufolge dann noch mittels Mehrtakt samt Architektur-Verbesserungen aufzuhübschen wäre – damit aber voraussichtlich doch unterhalb den vorgenannten (maximal) +40% Performance-Gewinn bleibt bzw. diese Marke in jedem Fall nicht gerade gravierend schlägt.

1. Surprisingly, the next gen chip will be based on Samsung 10nm node

2. Not very solid about what GA102 really got, may struggle to be 40% above 2080Ti, but bound to be under that number if compared against full bore TU102

3. SLi will be available to GA102 ONLY

4. RTX for everyone

Quelle: KittyKitties @ Twitter am 11. März 2020

Microsoft stellt "DirectX 12 Ultimate" mit vier verpflichtenden "neuen" Grafik-Features vor

Microsoft hat mit "DirectX 12 Ultimate" eine neue, offizielle Ausbaustufe der DirectX 12 Grafik-API mittels eines Blog-Eintrags vorgestellt, welche ab dem kommenden Windows-Update 20H1 verfügbar wird. Für jene neue Ausbaustufe wählte man keine numerische Bezeichnung wie bisher mit den Feature-Levels – was immer leicht mißverständlich war und mittels der verschiedenen Tier-Levels auch ziemlich schwammig daherkommt. Inoffiziell kann man DirectX 12 Ultimate natürlich auch als "DirectX 12 Feature-Level 12_2" bezeichnen, treffender wäre aber eher die Abkürzung "DX12U". Unter dieser hat Microsoft dann schlicht vier bereits existierende optionale DirectX-12-Feature nunmehr verpflichtend gemacht: "DirectX RayTracing" (DXR) in der neuen Version 1.1, "Variable Rate Shading" (VSR), "Mesh Shaders" & "Sampler Feedback". Sinn und Zweck der Maßnahme ist natürlich die Abgrenzung neuerer Hardware gegenüber älterer Hardware – weswegen sich AMD & nVidia auch gleich bemühten zu betonen, welche ihrer Hardware nunmehr bereits DX12U unterstützt: Bei AMD wird dies die kommende RDNA2-basierte Generation um die Navi-2X-Grafikchips sein, während nVidia in dieser Angelegenheit vorn liegt, da bereits deren aktuelle RTX-Grafikkarten der GeForce-20-Serie für DX12U (und damit das entsprechende Logo) ausgelegt sind.

| DirectX 12 FL 12_0 | DirectX 12 FL 12_1 | DirectX 12 Ultimate | |

|---|---|---|---|

| AMD | GCN2/GCN3, Polaris | Vega, RDNA1 | RDNA2 |

| Intel | - | Skylake, Kaby Lake, Coffee Lake, Comet Lake | ? |

| nVidia | - | Maxwell 2, Pascal, Turing (GF16) | Turing (GF20), Ampere |

Sony gibt die Hardware-Spezifikationen der Playstation 5 bekannt

Nach Microsoft hat nun auch Sony die mehr oder weniger vollständigen Hardware-Spezifikationen seiner NextGen-Konsole "Playstation 5" im Rahmen eines Videostream-Events bekanntgegeben. Eigentlich sollte diese Vorstellung auf der (nunmehr abgesagten) GDC erfolgen – war insofern wohl lange vorher geplant und ist demzufolge keine Reaktion auf die kürzliche Microsoft-Offenlegung der Xbox Series X. Gegenüber dieser hat es die Playstation 5 derzeit in den Augen der Öffentlichkeit schwer, da man mit der Playstation 5 unterhalb der Hardware-Daten der Microsoft-Konsole herauskommt: Bei der CPU ergibt sich noch ein grober Gleichstand, aber die GPU ist mit nur 36 Shader-Clustern und bis zu 10,3 TFlops Rechenleistung an einem 256 Bit GDDR6-Interface doch augenscheinlich kleiner ausgelegt als beim Microsoft-Pendant mit 52 Shader-Clustern auf 12,1 TFlops Rechenleistung an einem 320 Bit GDDR6-Interface.

| Sony Playstation 5 | Microsoft Xbox Series X | |

|---|---|---|

| Prozessor | 8C/16T Zen 2 @ ≤3.5 GHz | 8C/16T Zen 2 @ 3.6 GHz (ohne SMT @ 3.8 GHz) |

| Grafiklösung | 36 CU RDNA2 @ ≤2.23 GHz (≤10,3 TFlops) | 52 CU RDNA2 @ 1.825 GHz (12,1 TFlops) |

| Speicherinterface | 256 Bit GDDR6 @ 3500 MHz QDR (448 GB/sec) | 320 Bit GDDR6 @ 3500 MHz QDR (Ø 476 GB/sec) |

| Speicher | 16 GB GDDR6 | 16 GB GDDR6 (13,5 GB für Spiele) |

| Festplatte | 825 GB NVMe-SSD @ 5,5 GB/sec (8-9 GB/sec mit Kompression) | 1 TB NVMe-SSD @ 2,4 GB/sec (4,8 GB/sec mit Kompression) |

| Preislage | ??? | ??? |

| Release | "Holiday Season" 2020 | "Holiday Season" 2020 |

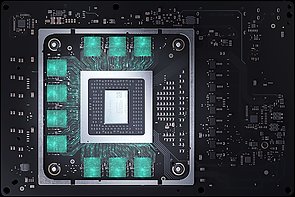

Microsoft gibt die vollständigen Spezifikationen der Xbox Series X bekannt

Nach der bereits weitgehenden Microsoft-Offenlegung Ende Februar zur Technik der kommenden Spielekonsole "Xbox Series X" haben Microsoft im eigenen Xbox-Blog sowie Eurogamer mittels eines unter Mithilfe von Microsoft entstandenden Artikels die Konsolen-Spezifikationen nun nochmals genauer ausgeführt – und dabei insbesondere die bestehenden Wissenlücken bei CPU, Speicherinterface und Speichermenge geschlossen. Somit präsentiert sich der SoC der Xbox Series X nunmehr als ein 360mm² großer Chip mit 15,3 Mrd. Transistoren unter der N7P-Fertigung von TSMC – hierbei kommt also noch keine EUV-Belichtung zum Einsatz, sondern "nur" das zweitbeste der drei 7nm-Verfahren von TSMC. In diese nahe der Xbox One X kommende Chipfläche quetschen AMD und Microsoft dann 8 CPU-Kerne auf Basis von Zen 2 samt SMT auf Taktraten von 3.8 GHz sowie eine RDNA2-basierte Grafiklösung mit 52 Shader-Clustern (aka 3328 Shader-Einheiten) auf 1825 MHz GPU-Takt – was dann 12,1 TFlops FP32-Rechenleistung ergibt und damit früheren Microsoft-Vorgaben entspricht.